深度学习Attention机制解析与应用

需积分: 14 48 浏览量

更新于2024-07-17

1

收藏 5.01MB PPTX 举报

"该资源是一份深度学习领域的PPT,主要讲解了attention机制,由手工制作,特别关注了2017年Google提出的‘Attention Is All You Need’理念在机器翻译中的应用。"

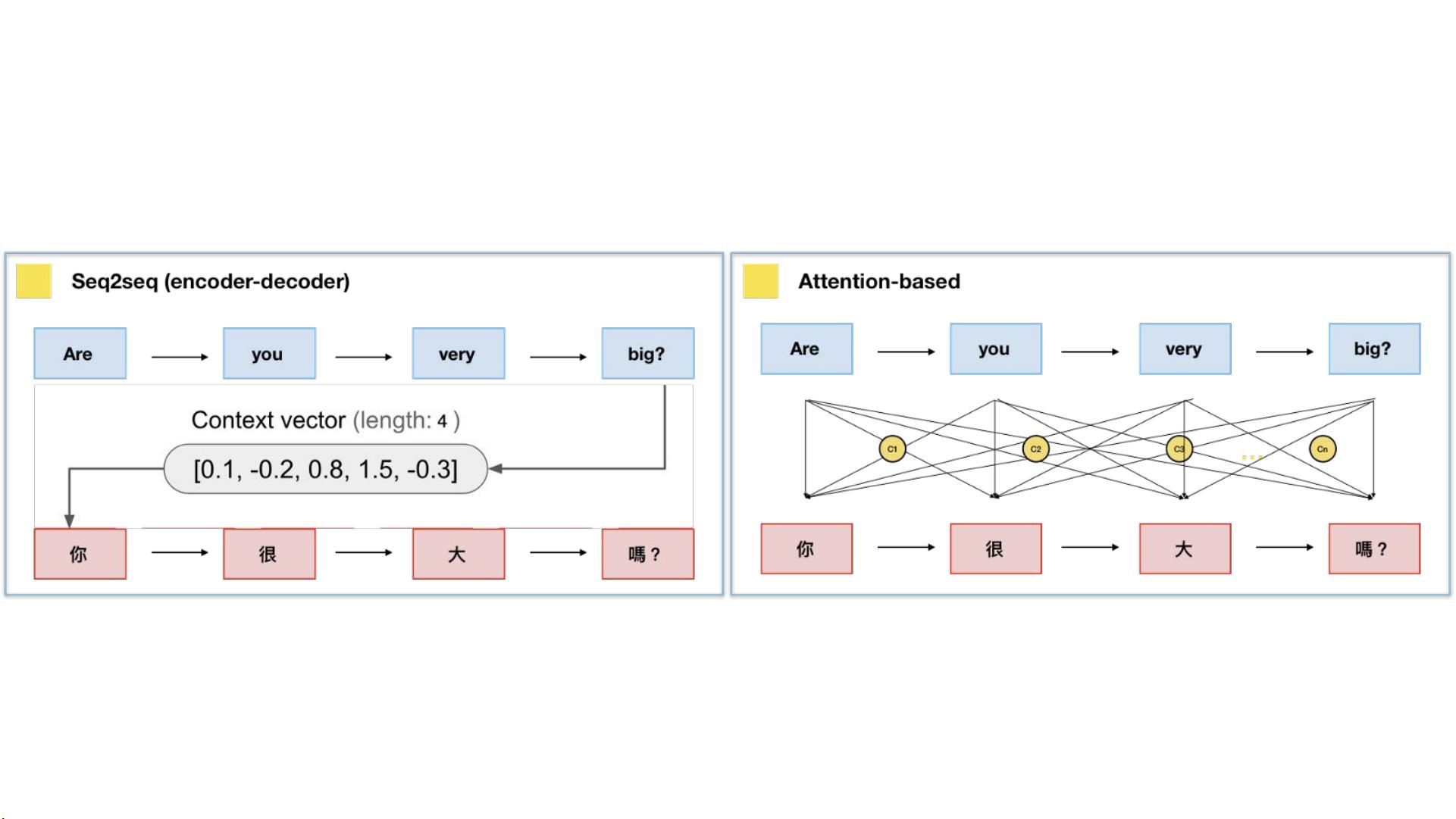

在深度学习中,注意力机制(Attention)已经成为理解和处理序列数据的重要工具,尤其是在自然语言处理(NLP)任务中。它源自于2017年Google发布的Transformer模型,该模型完全基于注意力机制,抛弃了传统的循环神经网络(RNN)和卷积神经网络(CNN),从而能够更有效地捕捉全局信息。

注意力机制的核心思想是赋予不同部分不同的权重,使得模型在处理序列时可以关注到关键信息,而非同等对待所有信息。在基本的注意力机制中,我们有三个概念:Query、Key和Value。Query通常代表我们需要查询的信息,Key是信息的标识,而Value则是与Key相关联的具体信息。通过计算Query与各个Key之间的相似性,我们可以得到一个注意力分数(Attention Score),这个分数表示了Query对每个Key的重视程度。然后,我们根据这些分数对Value进行加权求和,生成最终的注意力上下文向量(Attention/Context Vector),这个向量包含了输入序列的关键信息。

Transformer模型是注意力机制的典型应用,它由Encoder和Decoder堆叠而成。Encoder负责理解输入序列,而Decoder则用于生成输出序列。在Transformer中,注意力机制有多种形式,其中最重要的是Scaled Dot-Product Attention,它是通过点积运算并进行缩放来计算Query和Key的相似性,以避免数值过大或过小的问题。此外,Multi-Head Attention是Transformer的另一个创新,它同时考虑多个不同的注意力分布,增加了模型的表达能力,使得模型可以从不同的角度理解序列。

位置编码(Position Encoding)是Transformer中的另一个关键组件,因为在Transformer中没有内在的顺序信息处理机制。位置编码向每个词的位置添加了一个固定模式的向量,使模型能够区分序列中的词序。

自注意力(Self-Attention)是Transformer中的一种特殊形式,其中Query、Key和Value都来自同一序列。这样,模型可以同时考虑序列中的所有部分,实现了自我关注和信息的全局交互。

这份PPT详细介绍了注意力机制的概念、工作原理以及在Transformer模型中的应用,对于理解深度学习中的序列建模和机器翻译有着重要的参考价值。同时,它也提到了一些后续研究,如在生物信息学关系提取中的应用,展示了注意力机制在不同领域的潜力。

2021-10-10 上传

2023-08-29 上传

2023-04-30 上传

2023-04-20 上传

2023-03-20 上传

2023-06-28 上传

2023-05-28 上传

2023-08-27 上传

皮皮先生

- 粉丝: 4

- 资源: 5

最新资源

- JDK 17 Linux版本压缩包解压与安装指南

- C++/Qt飞行模拟器教员控制台系统源码发布

- TensorFlow深度学习实践:CNN在MNIST数据集上的应用

- 鸿蒙驱动HCIA资料整理-培训教材与开发者指南

- 凯撒Java版SaaS OA协同办公软件v2.0特性解析

- AutoCAD二次开发中文指南下载 - C#编程深入解析

- C语言冒泡排序算法实现详解

- Pointofix截屏:轻松实现高效截图体验

- Matlab实现SVM数据分类与预测教程

- 基于JSP+SQL的网站流量统计管理系统设计与实现

- C语言实现删除字符中重复项的方法与技巧

- e-sqlcipher.dll动态链接库的作用与应用

- 浙江工业大学自考网站开发与继续教育官网模板设计

- STM32 103C8T6 OLED 显示程序实现指南

- 高效压缩技术:删除重复字符压缩包

- JSP+SQL智能交通管理系统:违章处理与交通效率提升