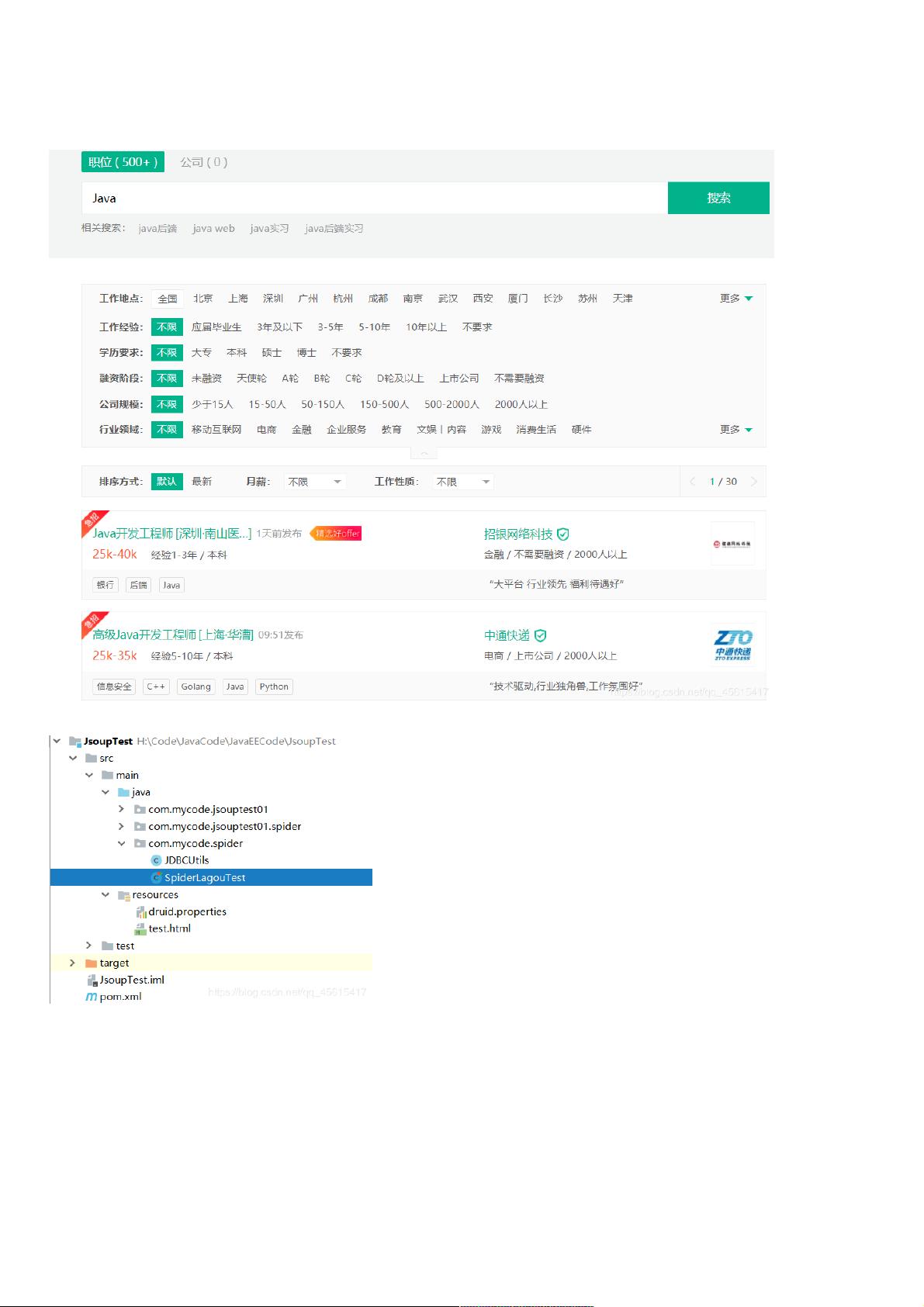

Java+Jsoup爬虫教程:抓取招聘网站Java职位信息

164 浏览量

更新于2024-08-29

收藏 780KB PDF 举报

"本教程将指导你如何使用Java结合Jsoup库进行网页抓取,特别是针对招聘网站上的Java职位信息。我们将学习如何设置项目依赖、使用Jsoup解析HTML以及将数据存储到数据库中。"

在Java中实现数据爬虫,Jsoup是一个非常强大的库,它提供了方便的API来解析HTML文档并提取结构化数据。以下是你需要了解的关键知识点:

1. **Jsoup介绍**:

Jsoup是一个用于处理实际世界HTML的Java库。它提供了一个方便的API,可以用来提取和操作数据,使用DOM、CSS和jquery-like方法。对于初学者来说,Jsoup易于上手,能帮助我们快速地解析HTML页面,找到需要的数据。

2. **项目依赖**:

在Java项目中,我们需要在`pom.xml`文件中引入必要的依赖,包括Jsoup、HttpClient(用于网络请求)、Apache Commons IO(处理IO流),以及Spring框架的相关组件(用于数据库操作)。这些依赖使得我们可以发送HTTP请求、解析HTML、存储数据到数据库。

3. **设置环境**:

- 引入JUnit作为测试框架,确保代码的正确性。

- 使用Druid数据库连接池,它提供了性能监控、健康检查等高级特性,优化了数据库连接的管理。

4. **数据库配置**:

- 配置`druid.properties`文件,包含数据库连接的URL、用户名、密码等信息。

- 创建工具类`JDBCUtils`,用于根据配置文件创建数据库连接池,并提供获取数据库连接的方法。

5. **网页抓取**:

- 使用Jsoup的`connect()`方法发送HTTP请求到目标网页。

- `get()`方法获取响应,然后调用`parse()`方法解析HTML内容。

- 使用CSS选择器或DOM遍历方法找到特定的元素,如职位名称、职责描述等。

- 提取数据后,可以使用Jsoup的`text()`或`attr()`方法获取元素的文本或属性值。

6. **数据存储**:

- 准备数据库表结构,例如创建一个`jobs`表,包含字段如`job_title`,`description`等。

- 使用Spring JDBC或者JDBC API执行SQL语句,将爬取到的信息插入到数据库中。可以使用`PreparedStatement`来防止SQL注入。

7. **异常处理**:

在处理网络请求和数据库操作时,必须做好异常处理,捕获可能发生的IOException、SQLException等,确保程序的健壮性。

8. **最佳实践**:

- 尊重网站的robots.txt文件,遵循爬虫道德规范,避免对目标网站造成过大压力。

- 使用代理IP或设置请求间隔,减少被目标网站封禁的风险。

- 对于动态加载的内容,可能需要模拟浏览器行为或使用Selenium等工具。

通过以上步骤,你可以构建一个基础的Java+Jsoup爬虫,定期抓取并存储招聘网站上的Java职位信息。不断学习和优化,你将能够处理更复杂的网页结构和更高效的数据抓取任务。

1363 浏览量

404 浏览量

381 浏览量

1623 浏览量

116 浏览量

471 浏览量

394 浏览量

158 浏览量

weixin_38642285

- 粉丝: 5

- 资源: 946

最新资源

- 蓝桥杯算法辅导.zip

- szOA.Core.rar

- Polopromini.github.io

- 3155-Project:ITCS 3155的小组项目

- piano-lessons-with-greg-kaighin-website

- 自定义滚动条:使用自定义滚动条使Firefox具有个性化效果!

- lengtooyinxiang

- 使用langchain+千问72b+m3e-large+chroma的对话机器人源码python实现

- cqlsh_standalone:独立CQLSH可执行文件

- chapter9 codes_palel6y_撞击_hitormishit_

- algo-green-bond

- pdksh-5.2.14-36.el5.i386.rpm

- IN3170:2021年Spring在Corse IN3170上的文件

- TP_SIR_mongodb

- whois:智能的纯Ruby WHOIS客户端和解析器

- SoyHuCe-technical-test