C++内存模型应对高更新率数据结构的挑战:Paul E. McKenney的解决方案

需积分: 10 34 浏览量

更新于2024-07-20

收藏 1.38MB PDF 举报

在2014年的CPPCON会议上,Paul E. McKenney,一位来自IBM的Distinguished Engineer和Linux Technology Center的成员,探讨了C++内存模型如何应对高更新率数据结构的问题。演讲的主题是"C++内存模型与高更新率数据结构:Issaquah Challenge",该挑战的核心是处理并行更新时的数据一致性问题,尤其是在多线程环境中。

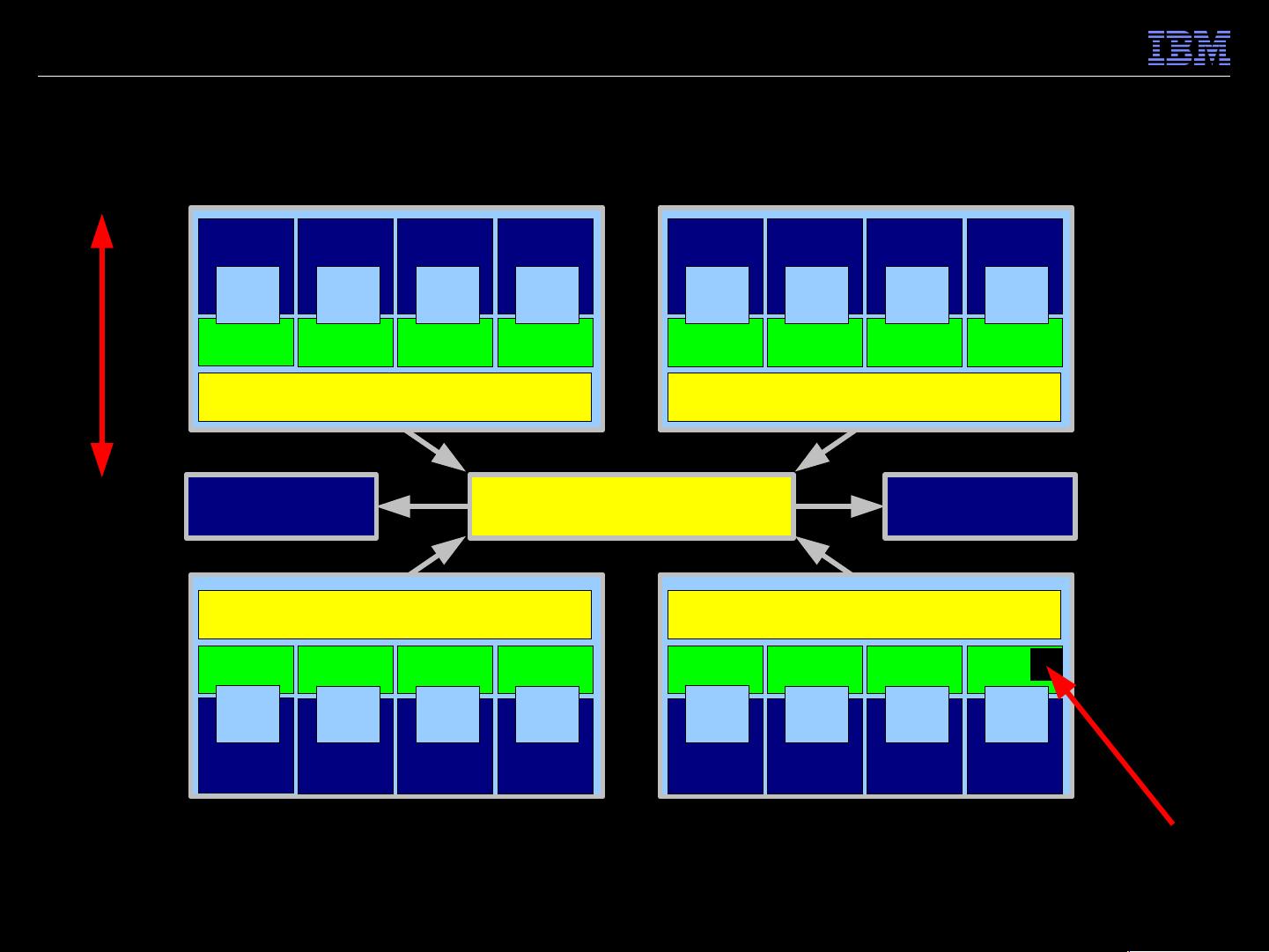

首先,McKenney提到了"Issaquah Challenge",这是一个具体场景,其中涉及多个CPU或线程对同一数据结构进行并发更新。在这个场景中,传统的并行更新方法并不完全适用,因为它们可能依赖于每线程独立处理或特定条件下的读取和写入。例如,如果更新只针对被读取位置的元素,并且采用存在性为基础的更新策略,这要求一种更高效、原子性的解决方案。

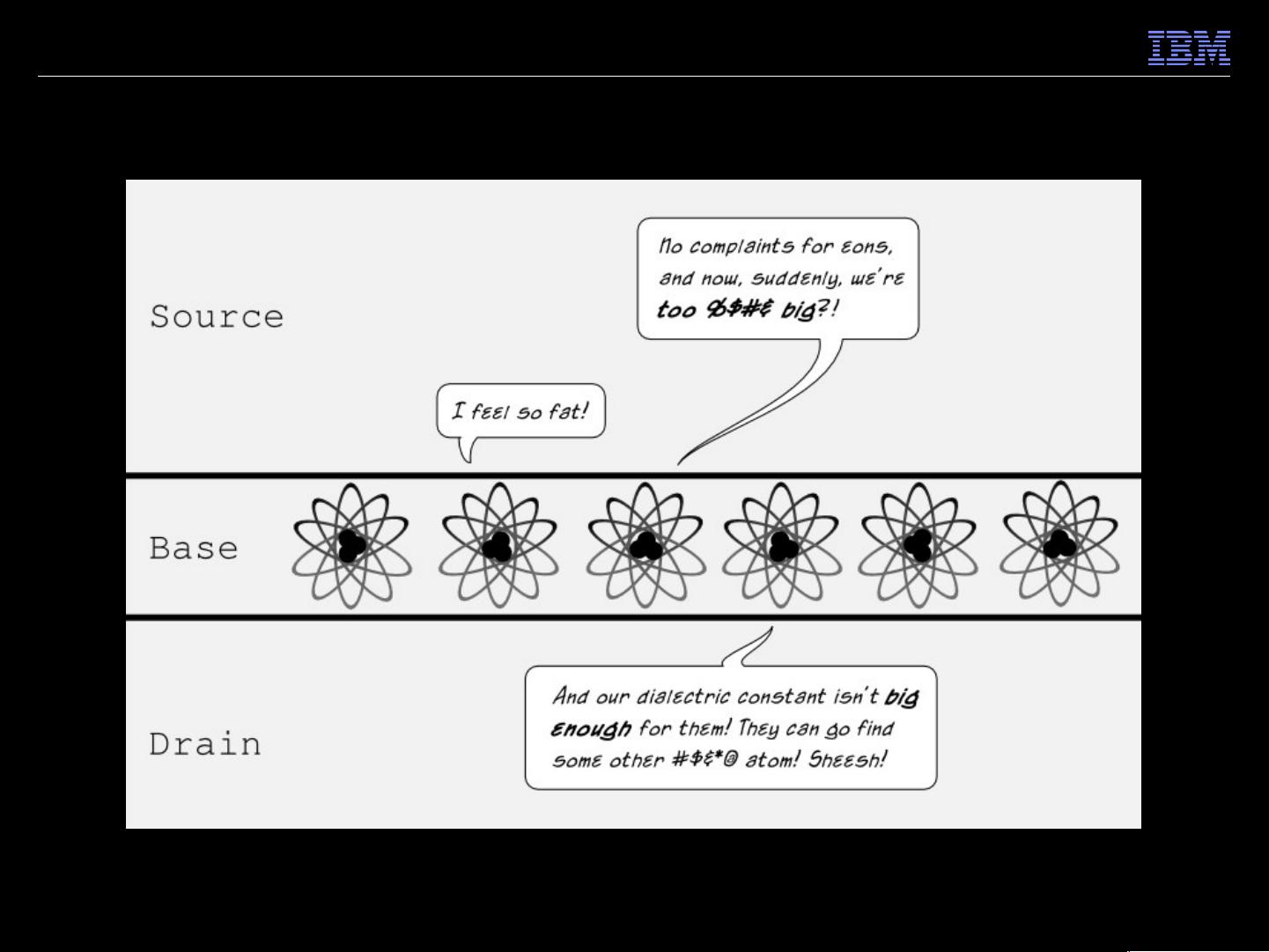

然后,演讲者强调了一个关键问题,即C++中的内存模型如何处理这种复杂性。传统的编程范式,如C语言,可能会导致竞态条件和数据竞争,而这些在高并发和低延迟的应用中是致命的。McKenney指出,C++标准并未直接解决这个问题,特别是在原子操作和内存顺序控制方面。

接着,他提出了一种名为"原子多结构更新"的方法,作为Issaquah Challenge的一个解决方案。这个方法的核心思想是设计一种机制,能够确保在执行多步原子操作时,比如在二叉树中同时从左向右移动一个元素(步骤1),再从右向左移动另一个元素(步骤4),这样的操作能够保证数据的一致性和完整性,即使在并发环境下也不会出现数据丢失或不一致。

为了实现这一目标,McKenney可能讨论了诸如原子引用(atomic reference)、原子操作(atomic operations)、内存屏障(memory fences)以及C++11/14标准中提供的std::atomic模板类等技术,这些都是保证内存模型正确性的关键手段。他可能会解释如何利用这些工具来构建线程安全的并发数据结构,比如使用std::atomic_ptr或std::atomic<T>来包装共享数据,同时避免读修改冲突。

此外,演讲中还可能提及了一些陷阱,如循环不变性(loop invariants)的重要性,以及如何通过正确的数据依赖分析来确保并发代码的正确执行。他还可能提到,尽管有了这些技术,程序员仍然需要谨慎处理并发场景,避免过度使用锁(lock-free编程)以提高性能,但同时也必须保持代码的可读性和维护性。

McKenney的演讲深入剖析了C++内存模型在处理高并发、高更新率数据结构时的挑战,以及如何通过创新的原子操作和内存管理技术来克服这些问题。这对于理解和实践现代高性能、并行计算的C++开发者来说,是一份宝贵的资源。

159 浏览量

105 浏览量

2019-09-17 上传

125 浏览量

2019-09-17 上传

133 浏览量

136 浏览量

141 浏览量

2021-08-11 上传

laocongzi

- 粉丝: 0

- 资源: 2

最新资源

- Molyx论坛 Simple

- eJava:一个极轻量的JAVA框架,适合开发API,采用Maven

- hexopictures

- kaggle dataset: nys-child-care-regulated-programs-数据集

- 纯CSS3实现幻灯片焦点图特效源码 v1.0

- tracking-sanity:对视觉跟踪研究保持理智和诚实

- SDM 工具箱:用于空间分析和合成房间声学脉冲响应的工具箱。-matlab开发

- 大型拖拉机模型

- portfolio-www.joonshakya.com.np

- simpletcpclient:简单的android tcp客户端

- Docker:Dockerfile存储

- 千博商城购物系统 v2017 Build0629

- foundation-sdk:创建一个更容易的sdk!

- Discuz! 魅力の城市

- World_Weather_Analysis

- hrw-fablab-prosper