机器学习算法详解:从线性回归到神经网络

版权申诉

21 浏览量

更新于2024-07-04

收藏 2.18MB PDF 举报

"该资源是一份关于机器学习算法步骤的PDF文档,涵盖了监督学习、回归模型、线性回归以及各种优化方法,如梯度下降、正规方程法和随机梯度下降。此外,还讨论了逻辑回归、神经网络、SVM、贝叶斯分类和聚类算法,如K-means和GMM,以及降维技术PCA。文档还提到了评估模型性能的方法和指标,如留出法、K折交叉验证,以及错误率、精度、查准率和查全率等。"

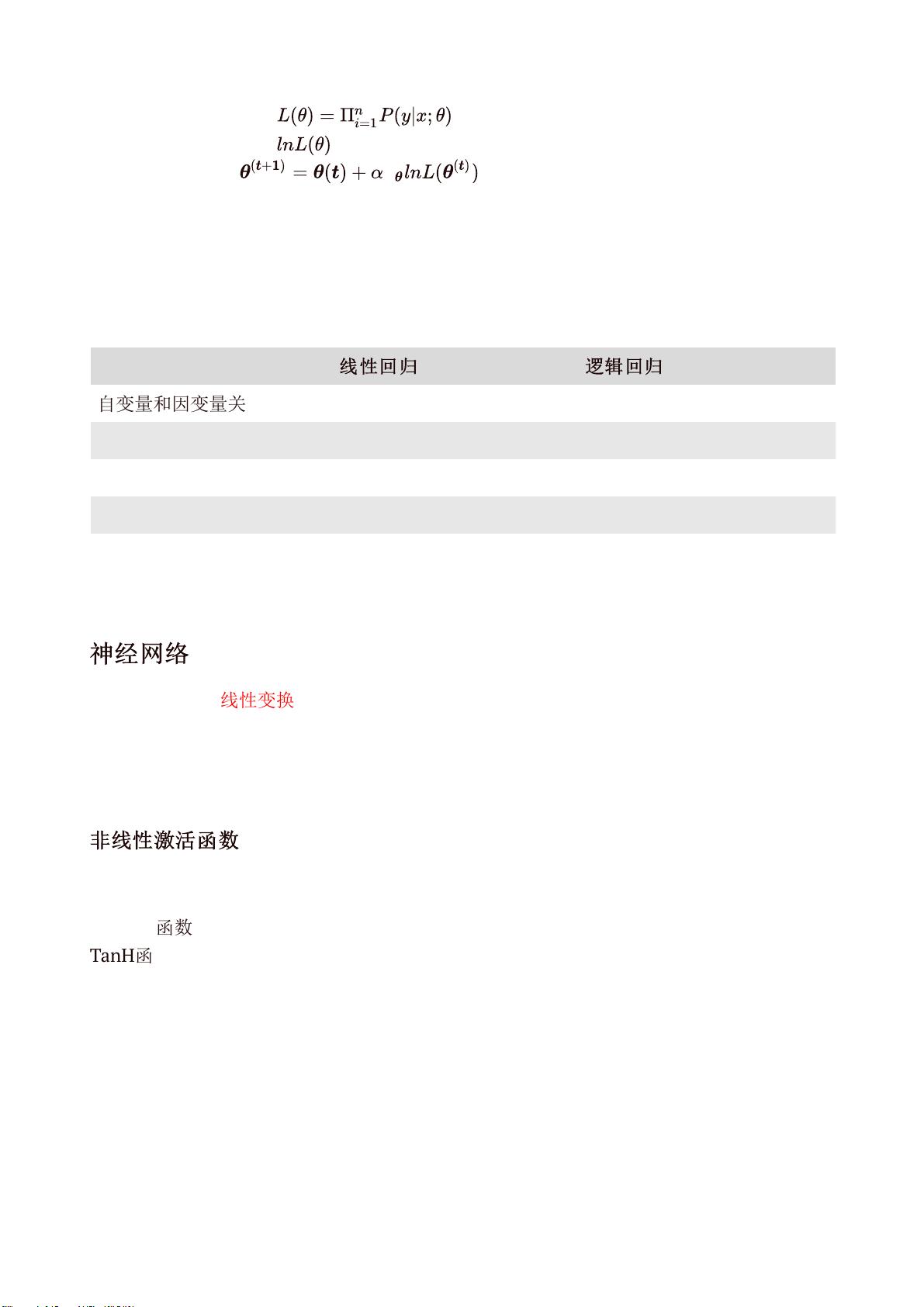

在机器学习领域,算法步骤是构建有效模型的关键。监督学习是一种常见方法,其中回归模型用于预测连续值,而线性回归是最基础的模型之一。线性回归通过最小化均方误差来拟合数据,可以采用梯度下降法迭代更新参数,也可以通过正规方程一次性求解。梯度下降法虽然简单且能收敛,但速度较慢;正规方程法计算量大但能直接得到最优解。随机梯度下降和小批量梯度下降则在效率和准确性之间做了平衡。

逻辑回归是处理离散输出的模型,它通过sigmoid函数将线性回归的连续输出转换为概率。在分类问题中,逻辑回归可以计算出每个类别的概率,且其损失函数通常使用交叉熵。与线性回归相比,逻辑回归引入了非线性的sigmoid函数,使其能处理非线性决策边界。

神经网络进一步扩展了这一概念,通过多层非线性激活函数(如阶跃函数、sigmoid、TanH和ReLU)实现更复杂的决策边界。损失函数的选择对模型训练至关重要,可以是交叉熵或二次代价函数,通过反向传播(BP)算法来更新权重和偏置,以最小化损失函数。

在无监督学习中,聚类如K-means和高斯混合模型(GMM)用于发现数据的内在结构,而降维技术如PCA用于减少特征维度,但理解起来较为复杂。

评估模型性能的方法包括留出法和K折交叉验证,常用的性能度量有错误率、精度、查准率和查全率,以及F1分数。这些指标有助于我们了解模型在不同场景下的表现,以便进行模型选择和优化。

1348 浏览量

294 浏览量

2022-11-05 上传

2022-05-29 上传

2021-09-24 上传

2021-09-24 上传

2021-09-24 上传

2021-09-24 上传

2021-12-02 上传

若年封尘

- 粉丝: 2w+

最新资源

- C#实现桌面飘雪效果,兼容Win7及XP系统

- Swift扩展实现UIView视差滚动效果教程

- SQLServer 2008/2005版驱动sqljdbc4.jar下载

- 图像化操作的apk反编译小工具介绍

- 掌握IP定位技术,轻松获取城市信息

- JavaFX项目计划应用PlanAmity代码库介绍

- 新华龙C8051系列芯片初始化配置教程

- readis:轻松从多Redis服务器获取数据的PHP轻量级Web前端

- VC++开发的多功能计算器教程

- Android自定义图表的Swift开发示例解析

- 龙门物流管理系统:Java实现的多技术项目源码下载

- sql2008与sql2005的高效卸载解决方案

- Spring Boot微服务架构与配置管理实战指南

- Cocos2d-x跑酷项目资源快速导入指南

- Java程序设计教程精品课件分享

- Axure元件库69套:全平台原型设计必备工具集