信用卡欺诈检测:Kaggle实战与不平衡数据处理

152 浏览量

更新于2024-08-29

9

收藏 772KB PDF 举报

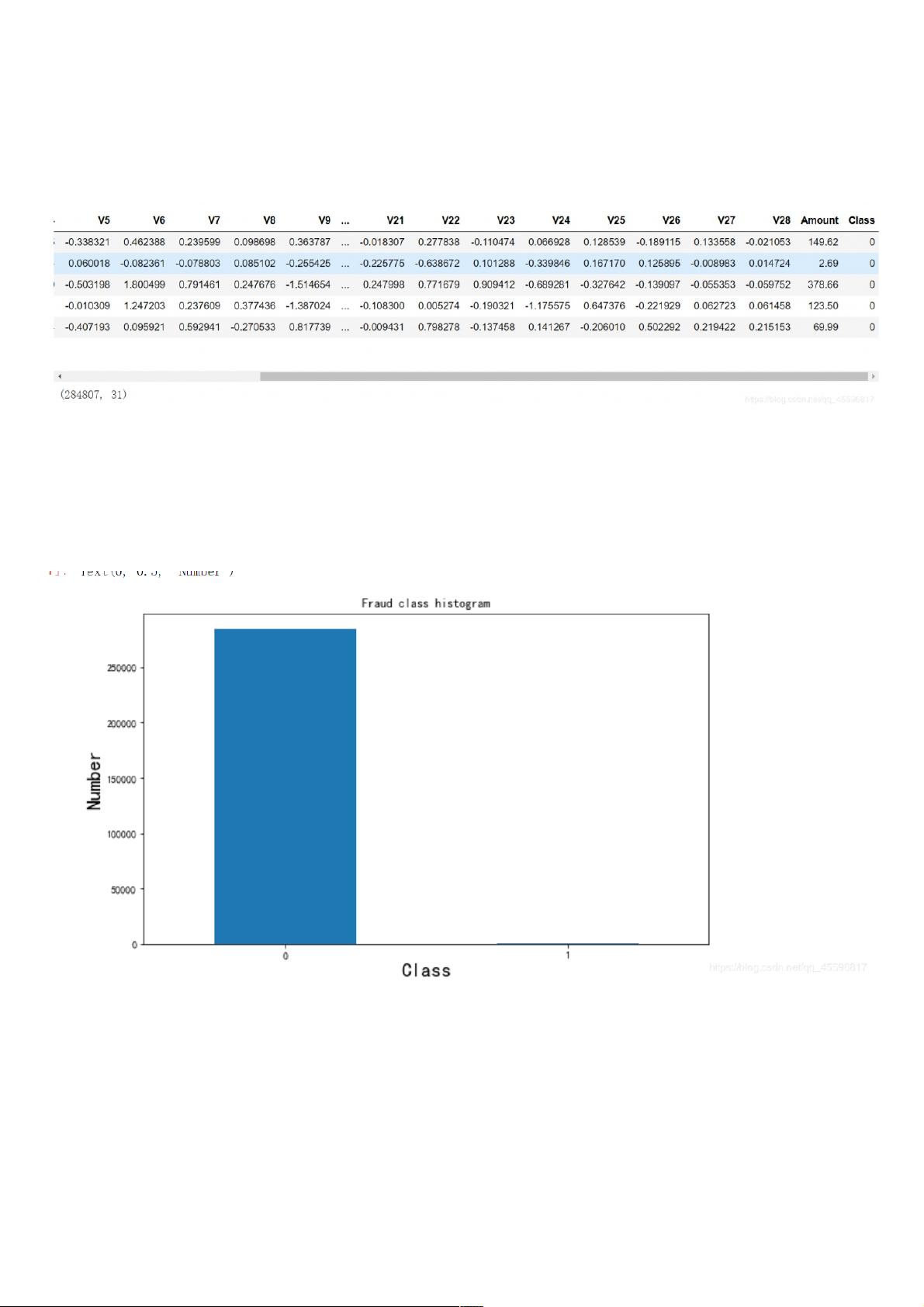

在Kaggle的经典案例中,我们探讨了信用卡诈骗检测的问题,通过Python编程实现了一个完整的分析流程。首先,导入必要的库如pandas、matplotlib和numpy,并读取名为"creditcard.csv"的数据集。数据集包含多个特征(V1-V28),其中"Amount"表示交易金额,"Class"标签区分正常交易(0)和欺诈交易(1)。目标是建立一个二分类模型来识别异常交易。

在探索数据阶段,我们注意到样本数据存在严重的类别不平衡,即正常交易(负样本)的数量远大于欺诈交易(正样本)。这种不平衡可能导致模型容易偏向于多数类,从而影响模型性能。为解决这个问题,可以采用两种策略:

1. **下采样**(Undersampling):减少正样本的数量,使两类样本数量接近,以平衡数据。这样可以避免模型过度拟合多数类,提高对少数类的识别能力。

2. **过采样**(Oversampling):增加负样本的数量,使得两类样本量相等。常见的过采样方法有SMOTE(Synthetic Minority Over-sampling Technique),通过生成新的合成样本来扩充少数类。

数据预处理中,特别关注了"Amount"列的数值范围问题。由于与其他特征相比,其值的差异较大,可能会影响模型训练的准确性。因此,对"Amount"进行归一化或标准化处理,比如使用sklearn库中的StandardScaler或MinMaxScaler,确保各特征在相似的尺度上进行分析。

此外,文章可能还会涉及数据可视化(如绘制Class数量的直方图),以及逻辑回归模型的选择和训练过程,包括特征选择、模型参数调优和评估指标(如准确率、精确率、召回率、F1分数等)。最后,为了提升模型的泛化能力,可能还会讨论交叉验证和模型集成(如随机森林、AdaBoost等)的应用。

在整个流程中,学习者将深入了解数据预处理、不平衡数据处理、特征工程和模型评估的关键环节,从而更好地应对信用卡诈骗检测这类实际问题。

2020-07-02 上传

2020-04-07 上传

2019-02-12 上传

2023-09-22 上传

2024-05-13 上传

2023-06-09 上传

2023-05-17 上传

2024-05-11 上传

2023-06-12 上传

weixin_38621427

- 粉丝: 10

- 资源: 941

最新资源

- Fizmez Web Server-开源

- jdk-8u271-linux-x64.zip

- c代码-这是一个输出0-50z之间所有能被3整除的的程序。

- movie-inc:影片制作数据库中的挑战奖的制作,预告片制作和制作,以及在影片库中编写的API

- matlab归零码功率谱源码-Genesis-1.3-Version4:随时间变化的3D代码可模拟自由电子激光器的放大过程

- acnh-critter-calendar:生成可以在岛上捕获的生物的列表

- video-layout2.zip

- Filter IE History-开源

- BooksStoreExcercise

- mysql代码-单表查询,多表查询

- 模拟电路-答案.zip-综合文档

- SD_HTMLRegPage

- mysql5.7安装软件及教程含主从配置.zip

- Fast Login Script-开源

- ShaggyShooters

- rock_paper_scissors:石头剪刀布游戏