使用PyTorch实现中英神经网络翻译模型

"自然语言处理期末大作业,涵盖了编码器-解码器模型、LSTM、注意力机制、PyTorch框架以及数据预处理等核心概念。"

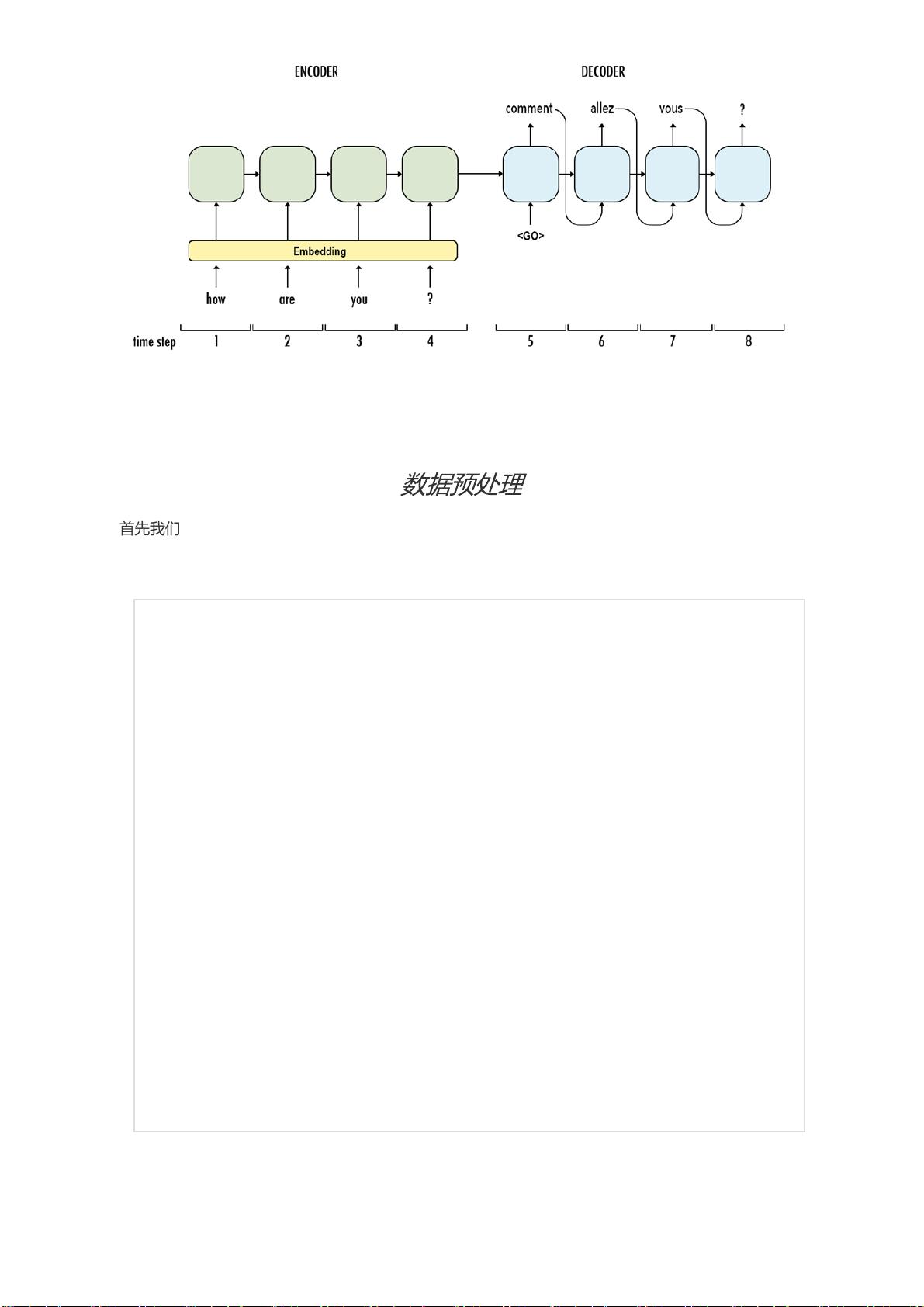

自然语言处理(NLP)是计算机科学领域的一个重要分支,涉及机器理解和生成人类语言。在这个期末大作业中,学生需要构建一个中文到英文的神经网络翻译模型。该模型基于编码器-解码器架构,这是一种广泛用于机器翻译任务的深度学习模型。

编码器部分使用了双向长短时记忆网络(LSTM),它能捕捉序列中的长期依赖关系。在输入序列中,每个句子以特定的开始标志<bos>表示,结束于<eos>标志,且通过添加<pad>确保同一批次(batch)内的序列长度一致。双向LSTM将中文句子转换为固定维度的向量,结合了前向和后向的信息。

解码器部分则采用单向LSTM,以编码器的最终状态作为其初始状态,开始翻译过程。在训练过程中,有两种策略可以选择:Teacher Forcing和Curriculum Learning。Teacher Forcing直接使用正确答案(groundtruth)作为输入,而Curriculum Learning则按一定概率p选择使用预测结果或真实答案。

为提高翻译质量,引入了注意力机制(Attention)。解码器在每个时间步会根据编码器的输出计算注意力权重,并对这些输出加权求和得到一个context_vector。这个向量与解码器的当前状态拼接,增强了模型对源语言语义的理解。

模型的输出层是一个线性层,将拼接后的向量映射到词汇表大小,通过softmax激活函数生成每个单词的概率分布。训练时,使用交叉熵损失函数,通过反向传播优化模型参数。

在实际应用中,数据预处理是必不可少的步骤。这包括文本清洗、分词(如使用jieba库)、构建词汇表、将文本转化为适合神经网络输入的数字序列等。在这个项目中,学生需要完成这些预处理工作,以便训练模型。

这个自然语言处理的期末大作业深入探讨了神经机器翻译的关键技术,涵盖了从模型设计到实际实现的全过程,对学生理解NLP领域的核心概念具有重要意义。

2020-01-03 上传

2023-12-23 上传

2024-06-08 上传

2023-05-20 上传

2023-05-30 上传

2023-05-16 上传

2023-05-11 上传

2024-10-19 上传

thebestuzi

- 粉丝: 34

- 资源: 311

最新资源

- 明日知道社区问答系统设计与实现-SSM框架java源码分享

- Unity3D粒子特效包:闪电效果体验报告

- Windows64位Python3.7安装Twisted库指南

- HTMLJS应用程序:多词典阿拉伯语词根检索

- 光纤通信课后习题答案解析及文件资源

- swdogen: 自动扫描源码生成 Swagger 文档的工具

- GD32F10系列芯片Keil IDE下载算法配置指南

- C++实现Emscripten版本的3D俄罗斯方块游戏

- 期末复习必备:全面数据结构课件资料

- WordPress媒体占位符插件:优化开发中的图像占位体验

- 完整扑克牌资源集-55张图片压缩包下载

- 开发轻量级时事通讯活动管理RESTful应用程序

- 长城特固618对讲机写频软件使用指南

- Memry粤语学习工具:开源应用助力记忆提升

- JMC 8.0.0版本发布,支持JDK 1.8及64位系统

- Python看图猜成语游戏源码发布

已收录资源合集

已收录资源合集