汪嘉怿:双语专家揭示翻译误差评估与质量预测挑战

需积分: 0 41 浏览量

更新于2024-07-01

收藏 1.52MB PDF 举报

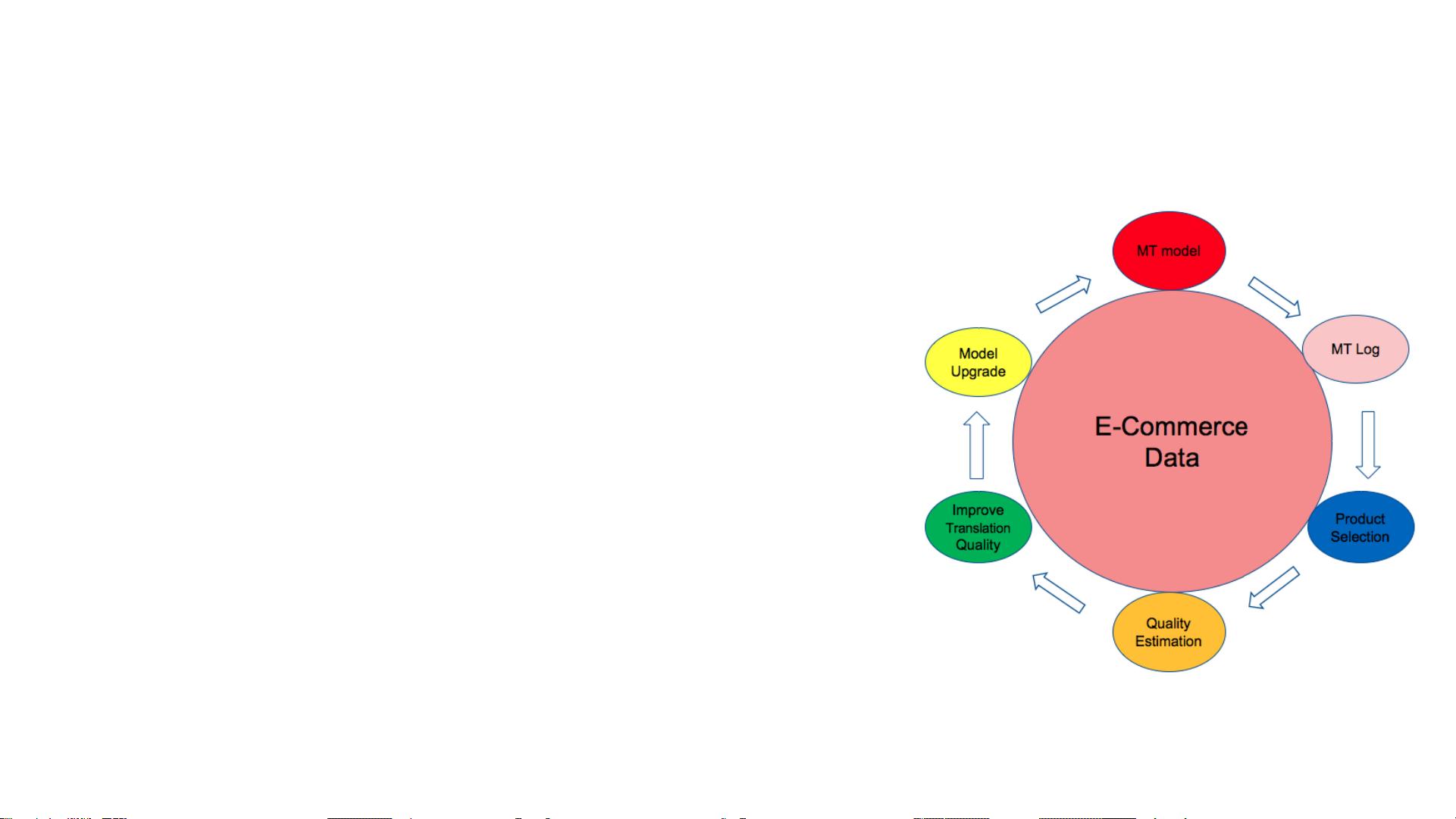

本文由汪嘉怿(Jiayi Wang),一位在阿里巴巴达摩院机器智能技术领域的专家撰写,重点关注的是双语专家如何识别和评估机器翻译(Machine Translation, MT)中的错误。文章的核心主题围绕"Translation Evaluation"(机器翻译质量评估)和"Quality Estimation"(无参考质量估计)两个关键领域展开。

首先,翻译评价部分探讨了对自动从一种语言到另一种语言进行机器翻译的质量进行评估的方法。作者提出了以下几个关键点:

1. 可接受性:质疑直接发布机器翻译结果的可行性,因为机器翻译可能存在无法准确传达原文精髓的问题。

2. 编辑需求:评估翻译后是否值得人工校对,以及校对所需的修正工作量。

3. 常用指标:如BLEU(Bilingual Evaluation Understudy),TER(Translation Edit Rate)和METEOR(Metric for Evaluation of Translation with Explicit ORdering)等评估工具的应用,它们衡量翻译的相似度和流畅度。

接下来,文章关注的是质量估计,这是基于人类参考翻译的局限性。它指出依赖黄金标准参考译文的评估方法存在以下问题:

- 人工参考依赖:需要一个高质量的翻译样本集合,但不同参考版本的巨大差异可能导致评估不一致。

- 分数误导:分数提高并不一定意味着翻译质量提升,因为评分标准可能无法全面反映翻译的优劣。

- 工业应用受限:这种评估方法在实际的机器翻译系统中可能不适用,因为难以在实时运行时进行有效的质量控制。

文章提出自动质量估计的任务概述,旨在解决上述问题,目标是在翻译过程中实时评估翻译质量,以便优化机器翻译系统的精度。然而,这需要开发出能够适应各种文本风格和上下文的技术,同时还要处理不断变化的语言动态。

汪嘉怿的研究着重于解决翻译质量评估中的挑战,并寻求一种更精确、实时且适用于工业环境的方法,这对于提高机器翻译的准确性和用户满意度具有重要意义。通过深入探讨现有方法的局限性和潜在解决方案,这篇文章为翻译领域的实践者提供了有价值的观点和思考方向。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2022-08-03 上传

2023-08-30 上传

2023-07-24 上传

2021-12-01 上传

2024-05-20 上传

2024-02-07 上传

蓝洱

- 粉丝: 28

- 资源: 316

最新资源

- 俄罗斯RTSD数据集实现交通标志实时检测

- 易语言开发的文件批量改名工具使用Ex_Dui美化界面

- 爱心援助动态网页教程:前端开发实战指南

- 复旦微电子数字电路课件4章同步时序电路详解

- Dylan Manley的编程投资组合登录页面设计介绍

- Python实现H3K4me3与H3K27ac表观遗传标记域长度分析

- 易语言开源播放器项目:简易界面与强大的音频支持

- 介绍rxtx2.2全系统环境下的Java版本使用

- ZStack-CC2530 半开源协议栈使用与安装指南

- 易语言实现的八斗平台与淘宝评论采集软件开发

- Christiano响应式网站项目设计与技术特点

- QT图形框架中QGraphicRectItem的插入与缩放技术

- 组合逻辑电路深入解析与习题教程

- Vue+ECharts实现中国地图3D展示与交互功能

- MiSTer_MAME_SCRIPTS:自动下载MAME与HBMAME脚本指南

- 前端技术精髓:构建响应式盆栽展示网站