"特征选择方法及实现:过滤法、嵌入法、包装法"

需积分: 12 151 浏览量

更新于2023-12-31

收藏 1.75MB PPTX 举报

本文介绍了监督学习中的特征工程和特征选择的方法。特征选择是指从原始特征集中选择最具有代表性和相关性的特征,以提高模型的性能和效果。

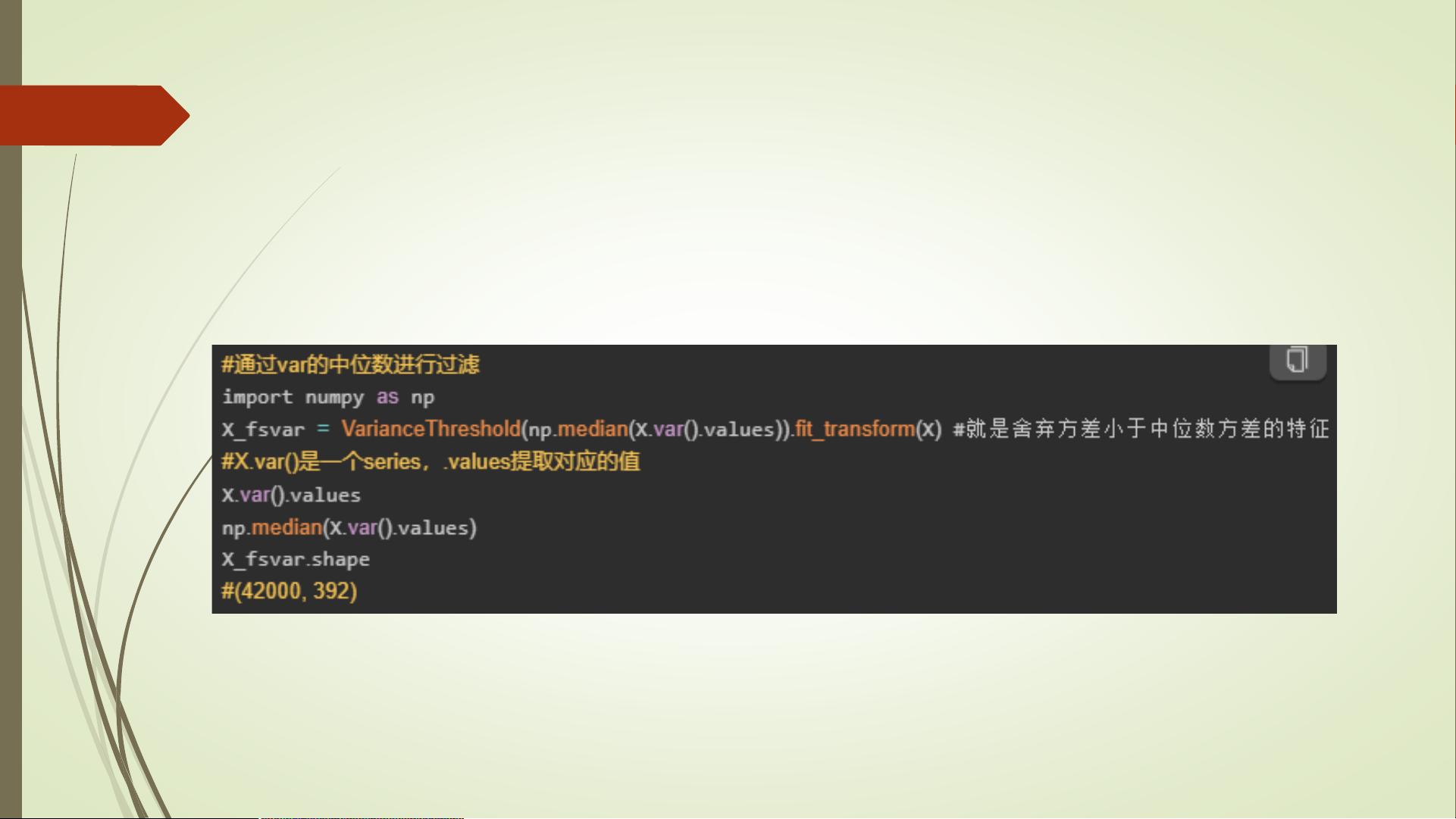

特征选择常用的方法有:过滤法,嵌入法,包装法,和降维算法。其中,过滤法是最简单且常用的一种方法。过滤法通过对特征本身的统计特征进行分析,筛选出对目标变量预测有较大影响的特征。其中一个常用的过滤法是VarianceThreshold方差过滤法。该方法通过计算特征的方差,优先消除方差为0的特征。通过设定阈值,可以根据方差的大小决定舍弃哪些特征。方差小的特征往往表示该特征的取值变化较小,对目标变量预测的影响较小。

除了过滤法,嵌入法也是一种常用的特征选择方法。嵌入法是指在模型训练的同时进行特征选择。具体做法是将特征选择嵌入到模型的训练过程中,根据模型的权重或系数来确定特征的重要性。常见的嵌入法有Lasso回归和决策树。Lasso回归通过加入L1正则化项,可以实现对特征的稀疏性约束,从而选择出对目标变量有显著影响的特征。决策树在构建过程中可以计算特征的重要性,通过剪枝过程来选择重要的特征。

包装法是另一种常见的特征选择方法。包装法将特征选择看作是一个搜索问题,通过穷举所有可能的特征子集来确定最佳的特征组合。具体做法是使用目标函数评估每个特征子集的性能,从中选择性能最好的特征子集作为最终的特征组合。常见的包装法有递归特征消除和遗传算法。

降维算法也可以作为一种特征选择的手段。降维算法通过将高维特征空间映射到低维空间来减少特征的数量。常见的降维算法有主成分分析(PCA)和线性判别分析(LDA)。这些算法都可以通过计算特征的投影系数来确定特征的重要性,从而实现特征选择的目的。

在实际应用中,不同的特征选择方法可以根据具体的问题和数据集的特点来选择和组合使用。特征选择的目的是找到最具有代表性和相关性的特征,以提高模型的性能和效果。通过合理使用特征选择方法,可以提高模型的预测能力,并减少特征维度带来的计算负担和过拟合的风险。特征选择是特征工程中的重要环节,对于构建准确、高效的机器学习模型具有重要意义。

1486 浏览量

2024-04-23 上传

2023-11-12 上传

2022-03-22 上传

2022-03-06 上传

2022-03-19 上传

深耕智能驾驶

- 粉丝: 1803

最新资源

- Subclipse 1.8.2版:Eclipse IDE的Subversion插件下载

- Spring框架整合SpringMVC与Hibernate源码分享

- 掌握Excel编程与数据库连接的高级技巧

- Ubuntu实用脚本合集:提升系统管理效率

- RxJava封装OkHttp网络请求库的Android开发实践

- 《C语言精彩编程百例》:学习C语言必备的PDF书籍与源代码

- ASP MVC 3 实例:打造留言簿教程

- ENC28J60网络模块的spi接口编程及代码实现

- PHP实现搜索引擎技术详解

- 快速香草包装技术:速度更快的新突破

- Apk2Java V1.1: 全自动Android反编译及格式化工具

- Three.js基础与3D场景交互优化教程

- Windows7.0.29免安装Tomcat服务器快速部署指南

- NYPL表情符号机器人:基于Twitter的图像互动工具

- VB自动出题题库系统源码及多技术项目资源

- AndroidHttp网络开发工具包的使用与优势