CNN发展历程:从LeNet到Inception-v2的关键组件与经典网络结构

版权申诉

CNN基本网络结构的发展历程可以追溯到早期的LeNet5,它是第一个将卷积层、池化层和全连接层结合的经典架构。LeNet5由两层卷积层(5×5的卷积核,步长为1)和两次最大池化操作,之后是两个全连接层,主要用于图像识别任务。

随后,AlexNet引入了更为深度的网络设计和创新技术。它包括五个卷积层、三个全连接层,ReLU激活函数的应用显著增强了网络的非线性表达能力。为了防止过拟合,AlexNet采用了Dropout和数据增强策略,以及利用LRN(局部响应归一化)来增强特征学习。同时,AlexNet通过双GPU并行训练加快了模型训练速度。

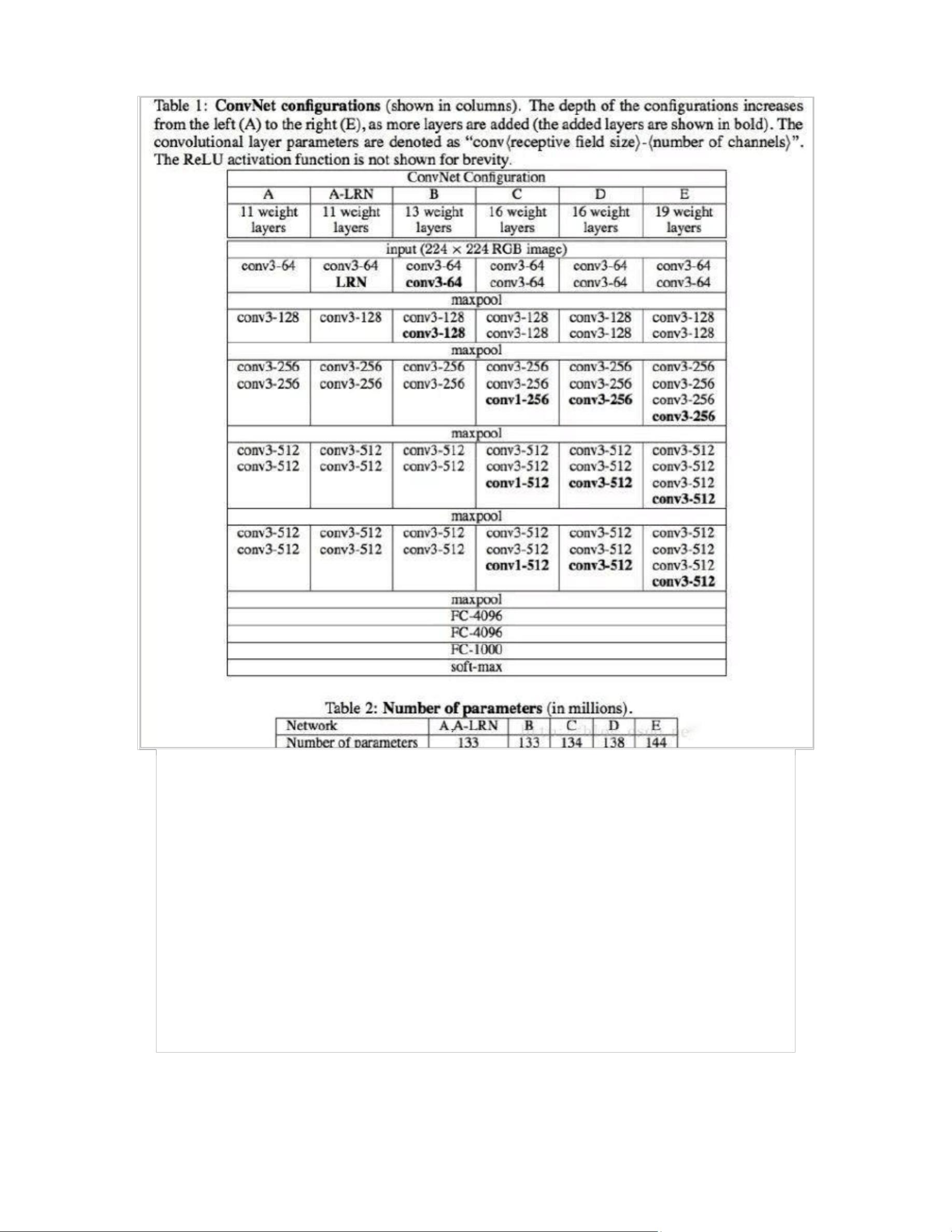

VGGNet进一步推动了深度学习在计算机视觉领域的应用,它采用堆叠3×3卷积核来模拟更大感受野,且加深网络层次,增加了卷积核数量。然而,VGGNet也认识到过深网络可能导致过拟合,因此在每一组卷积层后增加最大池化层以减小模型大小。

GoogLeNet(Inception-v1)针对深度与参数量的关系进行了优化。它提出了一种“inception”模块,通过不同尺寸的卷积核以及1×1卷积来控制参数量,提高了网络对多尺度特征的捕捉能力,同时保持了计算效率。这一设计在减少过拟合的同时,提升了模型的泛化性能。

Inception-v2在此基础上引入了批量标准化(Batch Normalization,BN)技术,BN有助于加速收敛、提高模型稳定性和泛化能力。BN通过标准化每个批次的输入,使得网络的学习更加稳定,从而在不增加参数的情况下提高了网络的性能。

总结来说,CNN的发展从最初的局部感知逐步深化,从LeNet5到AlexNet再到VGGNet,再到GoogLeNet和Inception系列,网络结构越来越复杂,技术不断迭代,如卷积核大小的选择、池化操作、激活函数、正则化方法和标准化技术等,这些都在持续推动着计算机视觉领域的进步。每一阶段的进步都体现了对模型复杂度、计算效率和过拟合问题的精细调控。

191 浏览量

5706 浏览量

1770 浏览量

638 浏览量

2024-04-23 上传

109 浏览量

apple_51426592

- 粉丝: 9848

- 资源: 9652

最新资源

- NWWbot:僵尸程序的稳定版本

- EFRConnect-android:这是Android的EFR Connect应用程序的源代码-Android application source code

- Project_Local_Library_1

- nhlapi:记录NHL API的公共可访问部分

- 智能电子弱电系统行业通用模板源码

- asp_net_clean_architecture

- snapserver_docker:Docker化的snapclient

- leetcode答案-programming-puzzles:一个在TypeScript中包含编程难题和解决方案的存储库

- 永不消失的责任

- 资料库1488

- Python模型

- subseq:子序列功能

- load81:适用于类似于Codea的孩子的基于SDL的Lua编程环境

- leetcode答案-other-LeetCode:其他-LeetCode

- 有效的增员管理

- 数据结构