理解决策树算法:Python实现与原理解析

76 浏览量

更新于2024-08-03

收藏 372KB PDF 举报

"决策树算法及Python实现内含PYTHON源码"

决策树是一种广泛应用于机器学习领域的分类和回归方法。在分类问题中,决策树通过一系列特征测试来对数据进行分割,最终形成一个树状结构,其中每个内部节点代表一个特征测试,每个分支表示测试的不同输出,而每个叶节点则代表一个类别决策。这种模型易于理解和解释,因为它能够以直观的if-then规则形式展示决策过程。

决策树的主要优点包括:

1. 自学习能力:决策树算法能够在训练过程中自动学习,不需要用户具备深厚的背景知识,只要提供充分标注的数据即可。

2. 可读性强:决策树的结构清晰,便于人类理解,有助于进行深入的分析。

3. 高效率:一旦构建完成,决策树可以反复使用,预测过程的时间复杂度与树的深度相关,通常效率较高。

以母亲为女儿介绍对象为例,我们可以构建一个简单的决策树来模拟女性对约会对象的选择标准。在这个例子中,年龄、外貌、收入和职业是决定是否见面的关键因素。如果将这些条件量化,我们就能得到一个精确的决策树模型。

构建决策树通常遵循以下步骤:

1. 将所有数据集视为一个初始节点。

2. 对每个特征进行评估,找出最佳的分裂特征,即能够最大化数据纯度的特征。

3. 根据最佳特征将数据集分割成子集。

4. 对每个子集重复步骤2和3,直到满足停止条件,如达到预定的纯度或达到最小样本数。

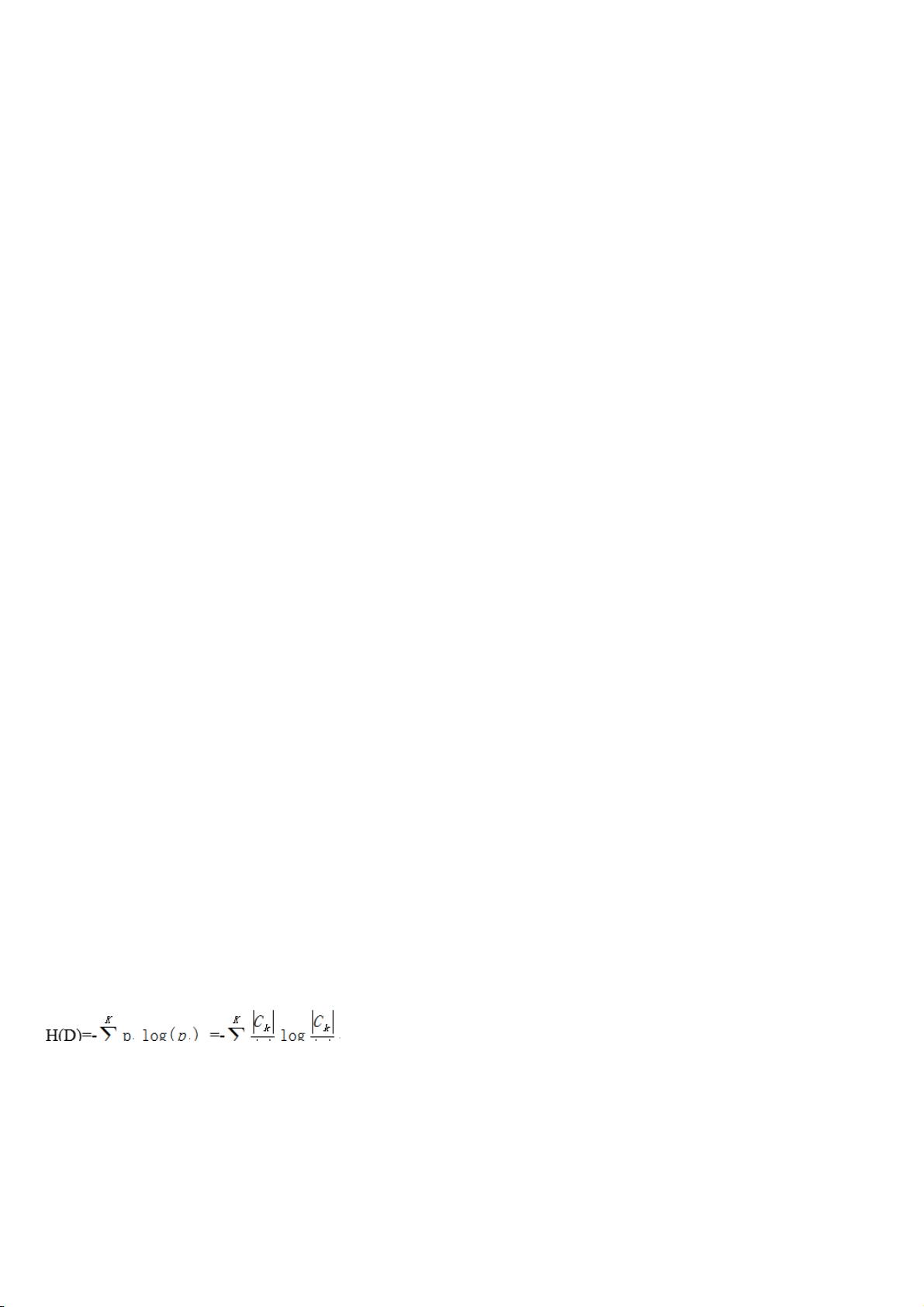

评估分裂特征好坏的标准有多种,如信息增益(ID3)、信息增益率(C4.5)和基尼系数(CART)。信息增益衡量了特征A对数据集D的信息熵减少程度,信息增益率在信息增益的基础上考虑了特征A的信息熵,以防止偏向于选择具有更多取值的特征。基尼系数则是衡量数据集纯度的一个指标,越低表明数据集越纯。

在Python中,可以使用如scikit-learn库来实现决策树算法。scikit-learn提供了DecisionTreeClassifier和DecisionTreeRegressor等类,用于分类和回归任务,同时还提供了构建、训练和评估决策树的接口,方便用户进行模型构建和优化。

决策树算法因其易用性、可解释性和高效性而在实际应用中占有一席之地,而Python作为流行的编程语言,提供了强大的库支持,使得开发者能够轻松地实现和运用决策树模型。

2024-05-08 上传

2024-05-09 上传

2024-05-08 上传

2024-05-15 上传

2024-05-29 上传

2024-05-10 上传

2024-05-09 上传

2024-05-09 上传

2024-05-16 上传

emma20080101

- 粉丝: 1081

- 资源: 5280