CUDA程序设计入门:GPGPU与CUDA解析

“CUDA程序设计 - 介绍了CUDA的起源、作用以及GPU与CPU的硬件架构对比,探讨了GPGPU的概念和CUDA编程模型。”

在计算机科学领域,CUDA(Compute Unified Device Architecture)是一种由NVIDIA公司推出的并行计算平台和编程模型,主要用于利用GPU(Graphics Processing Unit,图形处理器)进行通用计算。CUDA使得开发者能够利用GPU的强大计算能力来解决非图形计算任务,如科学计算、数据分析、机器学习等。

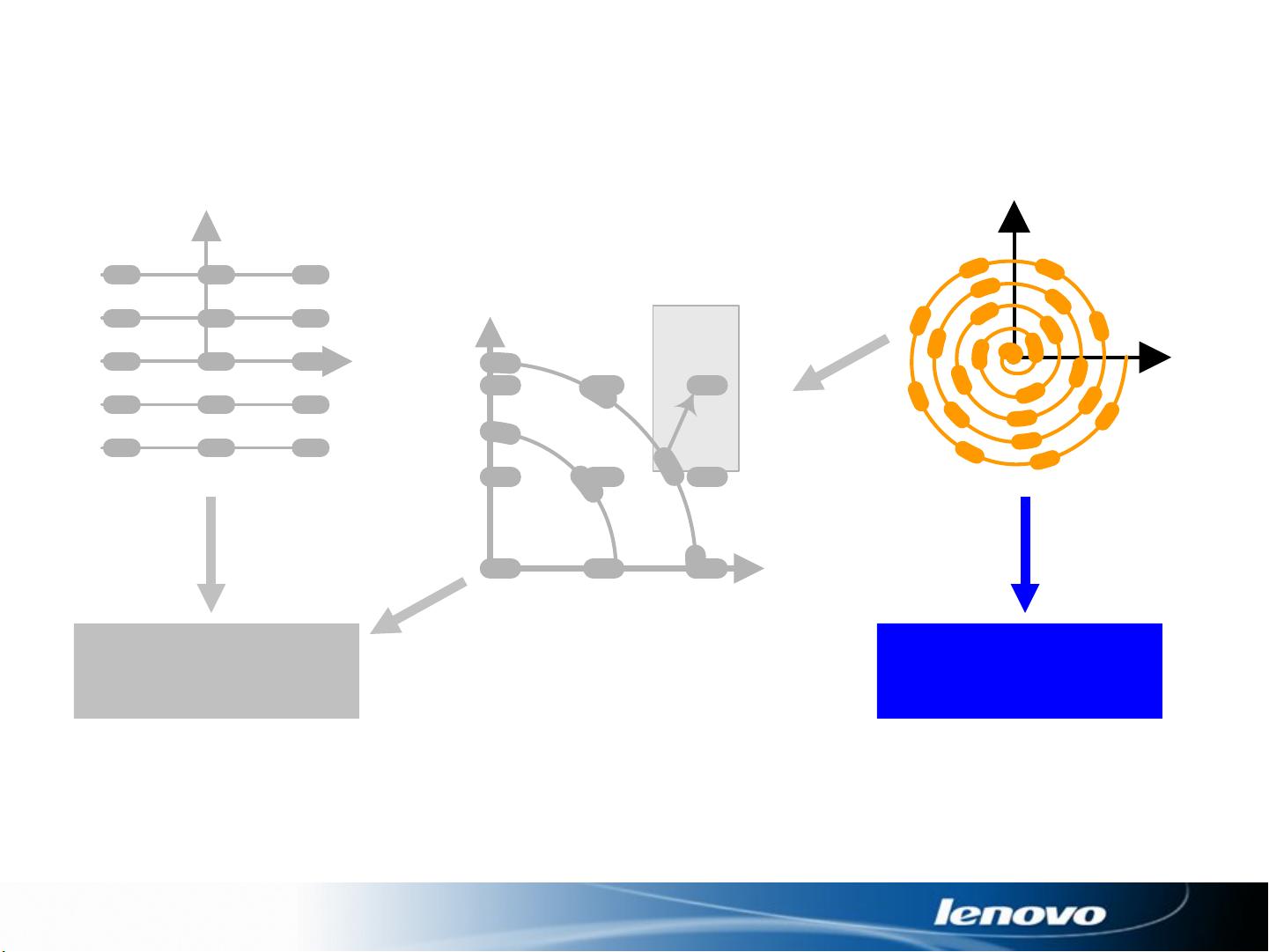

CUDA的出现源于多核时代的到来,随着计算机硬件的发展,拥有多个复杂度适中、低功耗核心的处理器成为趋势。CPU(Central Processing Unit,中央处理器)通常具有丰富的缓存和复杂的流控单元,适用于处理不规则数据结构、不可预测存取模式和递归算法等。而GPU则专注于大量数据的并行计算,拥有更多的ALU(算术逻辑单元),适合处理规则数据结构和可预测存取模式的任务,如油气勘探、金融分析、医疗成像等。

GPGPU(General-Purpose Computing on Graphics Processing Units)是将原本用于图形处理的GPU用于执行通用计算任务。通过将计算问题映射到GPU的顶点或片段处理器,GPGPU可以实现高性能计算。然而,早期的GPGPU编程存在硬件资源利用率不高、内存访问受限、调试困难等问题。

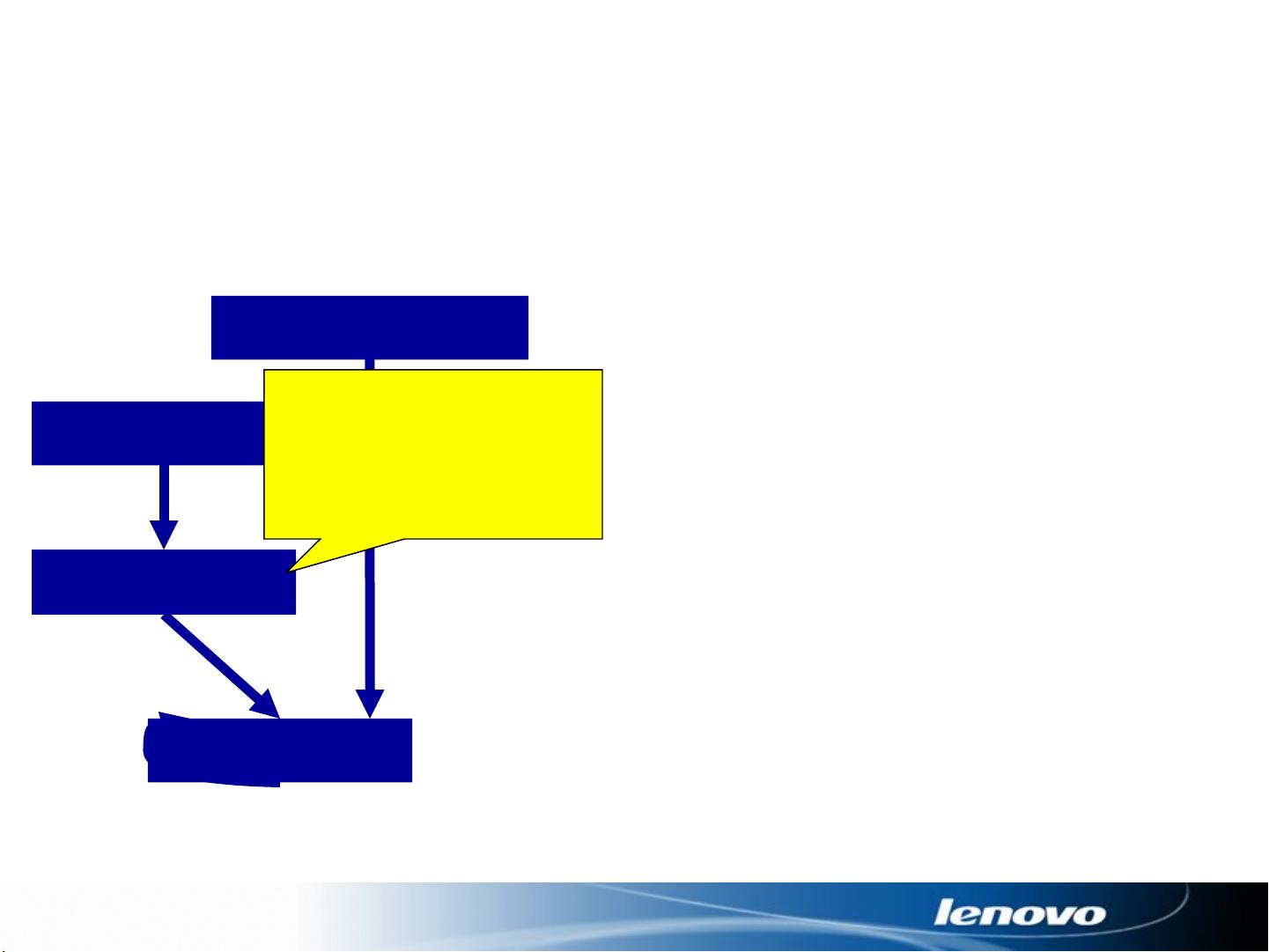

CUDA解决了这些问题,它提供了一个统一的架构,使得程序员可以在CPU上编写串行代码,而在GPU上执行并行计算的内核(Kernel)。GPU上的内核可以被调用并分配到多个线程块(Thread Blocks)上,每个线程块又包含多个线程(Threads)。这种编程模型允许开发者充分利用GPU的并行处理能力,显著提升计算效率。

CUDA编程模型包括以下几个关键概念:

1. **线程**:基本的执行单元,可以执行内核指令。

2. **线程块**:一组线程,它们在GPU上并行执行,并且可以共享数据。

3. **网格**(Grid):由多个线程块组成,代表整个内核的执行实例。

4. **全局内存**:所有线程都能访问的内存,适合大容量数据存储。

5. **共享内存**:线程块内的线程可以快速访问的内存,用于线程间的通信和同步。

6. **常量内存**:存储不会改变的常量数据。

7. **纹理内存**:优化过的内存类型,用于快速访问纹理数据。

CUDA编程涉及到内存管理、同步机制、错误检查等多个方面,需要开发者对并行计算有深入理解。通过CUDA,开发者可以编写出高效利用GPU的程序,从而在各种计算密集型任务中获得显著的性能提升。

2011-03-11 上传

2021-09-19 上传

2024-11-05 上传

2021-09-11 上传

2011-04-20 上传

2018-10-23 上传

2011-01-05 上传

青春的加贝

- 粉丝: 0

- 资源: 18

最新资源

- WordPress作为新闻管理面板的实现指南

- NPC_Generator:使用Ruby打造的游戏角色生成器

- MATLAB实现变邻域搜索算法源码解析

- 探索C++并行编程:使用INTEL TBB的项目实践

- 玫枫跟打器:网页版五笔打字工具,提升macOS打字效率

- 萨尔塔·阿萨尔·希塔斯:SATINDER项目解析

- 掌握变邻域搜索算法:MATLAB代码实践

- saaraansh: 简化法律文档,打破语言障碍的智能应用

- 探索牛角交友盲盒系统:PHP开源交友平台的新选择

- 探索Nullfactory-SSRSExtensions: 强化SQL Server报告服务

- Lotide:一套JavaScript实用工具库的深度解析

- 利用Aurelia 2脚手架搭建新项目的快速指南

- 变邻域搜索算法Matlab实现教程

- 实战指南:构建高效ES+Redis+MySQL架构解决方案

- GitHub Pages入门模板快速启动指南

- NeonClock遗产版:包名更迭与应用更新