Transformer在机器翻译中的革新:理论与实战应用

版权申诉

193 浏览量

更新于2024-07-04

收藏 4.11MB PDF 举报

自然语言处理(NLP)是人工智能(AI)的重要分支,尤其在深度学习时代,Transformer模型因其革命性的结构和性能提升引起了广泛关注。《Transformer新型神经网络在机器翻译中的应用》这份42页的公开课详细探讨了Transformer技术在机器翻译领域的应用,分为以下几个部分:

1. **Transformer新型网络结构解析**:

- Transformer摒弃了传统的循环神经网络(RNN)和长短时记忆网络(LSTM),采用了高度并行化的设计,这使得训练速度显著提高,能够更好地处理长距离依赖和层级结构,如句法和指代信息。

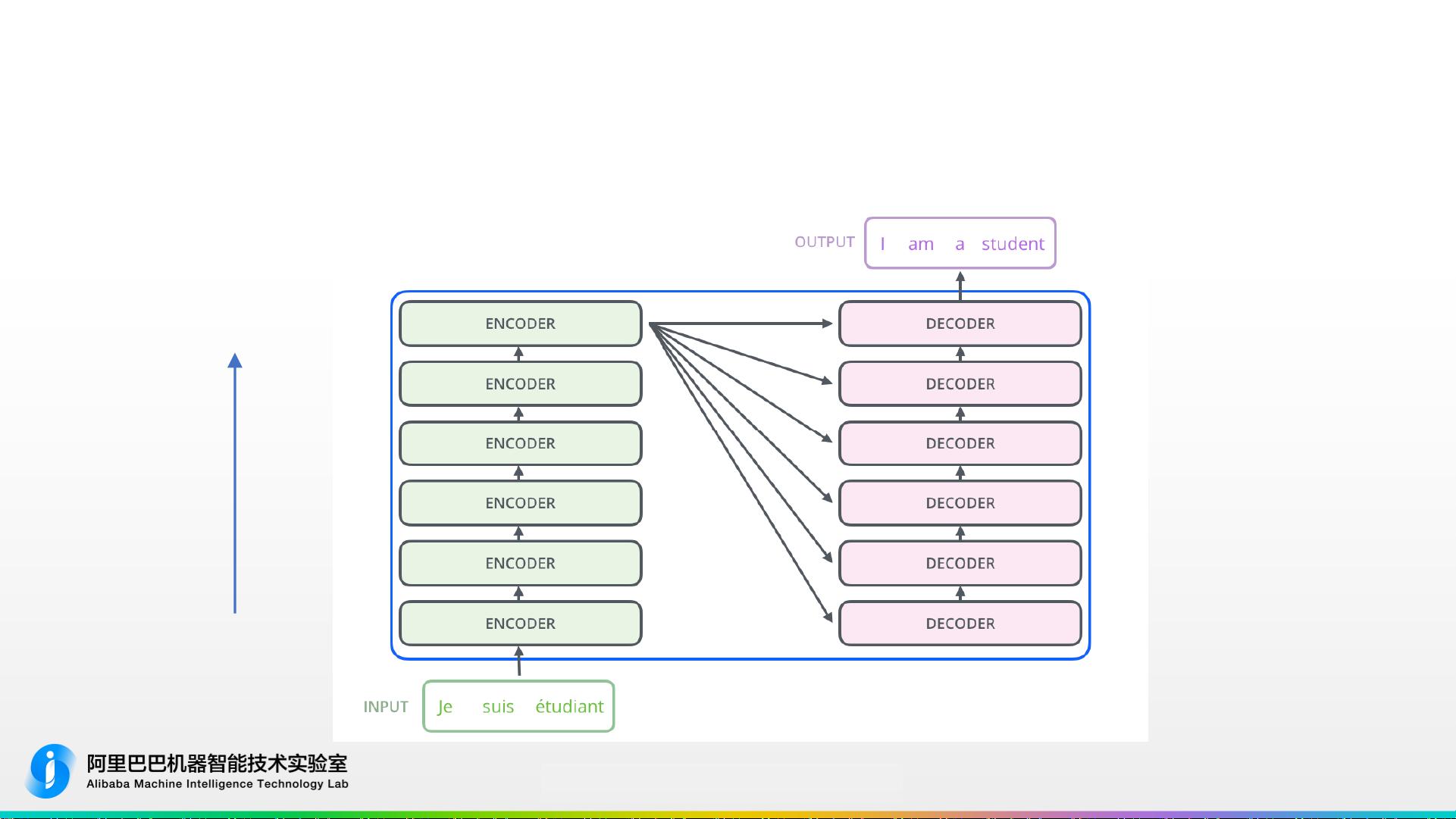

- 高层面上,Transformer依然保留了编码器-解码器(Encoder-Decoder)架构,但底层实现更为复杂,包括多层神经网络,如6层编码器和6层解码器,分别处理表层词法信息和抽象语义信息。

2. **基于Transformer的机器翻译系统**:

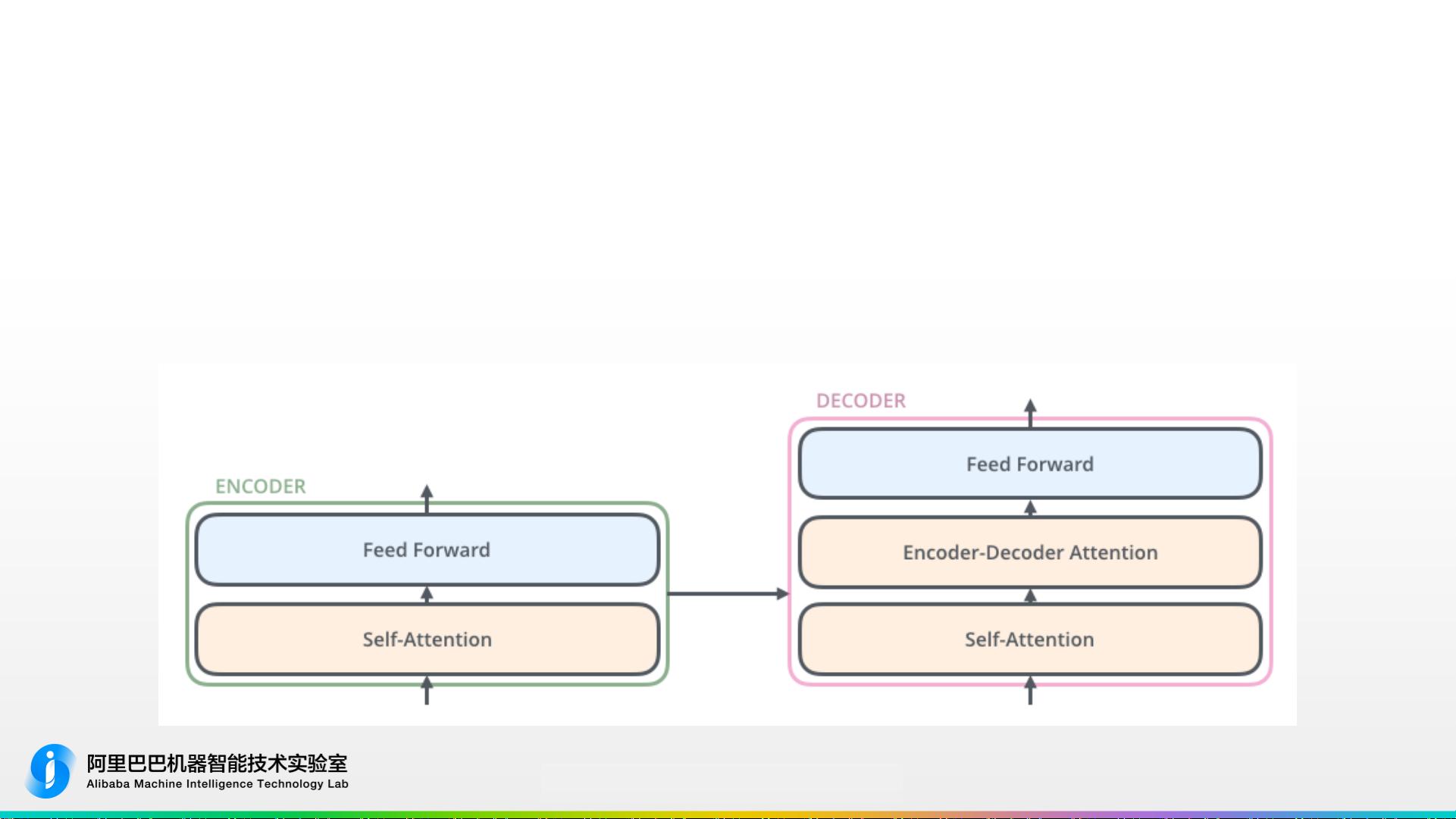

- 这部分深入介绍了Transformer如何通过自注意力(Self-Attention)机制来捕捉句子中不同位置词语之间的依赖关系,以及源端到目标端的注意力(Encoder-DecoderAttention)机制,以便模型理解和生成更准确的翻译。

3. **Transformer在阿里翻译中的工业化实践**:

- 阿里巴巴的翻译平台展示了Transformer在实际场景中的应用,通过高效的模型部署和优化,Transformer模型在阿里内部的翻译任务中表现出色,提高了翻译质量和效率。

4. **Transformer在WMT2018全球机器翻译评测中的表现**:

- Transformer在2018年的国际机器翻译大赛(WMT)上取得了显著的成绩,证明了其在大规模数据集上的优越性能,对于跨语言的理解和生成具有重要意义。

5. **Transformer的不足与改进**:

- 虽然Transformer解决了RNN的并行化问题,但仍然面临一些挑战,例如如何更好地捕捉长距离依赖和语法结构。作者强调了引入更多上下文信息(如指代信息)和自注意力机制的重要性。

这份公开课提供了对Transformer模型从理论到实战的深入理解,展示了其在机器翻译领域的核心优势和应用潜力,以及在实际工业环境中的优化策略。Transformer的出现标志着自然语言处理技术的一个重大飞跃,对未来的AI发展产生了深远影响。

2021-01-06 上传

2022-04-26 上传

2022-04-25 上传

2024-12-21 上传

2024-12-21 上传

2024-12-21 上传

2024-12-21 上传

2024-12-21 上传

passionSnail

- 粉丝: 467

- 资源: 7835

最新资源

- JavaScript实现的高效pomodoro时钟教程

- CMake 3.25.3版本发布:程序员必备构建工具

- 直流无刷电机控制技术项目源码集合

- Ak Kamal电子安全客户端加载器-CRX插件介绍

- 揭露流氓软件:月息背后的秘密

- 京东自动抢购茅台脚本指南:如何设置eid与fp参数

- 动态格式化Matlab轴刻度标签 - ticklabelformat实用教程

- DSTUHack2021后端接口与Go语言实现解析

- CMake 3.25.2版本Linux软件包发布

- Node.js网络数据抓取技术深入解析

- QRSorteios-crx扩展:优化税务文件扫描流程

- 掌握JavaScript中的算法技巧

- Rails+React打造MF员工租房解决方案

- Utsanjan:自学成才的UI/UX设计师与技术博客作者

- CMake 3.25.2版本发布,支持Windows x86_64架构

- AR_RENTAL平台:HTML技术在增强现实领域的应用