深入解析Hadoop源代码:分布式基石与核心组件

"Hadoop源代码分析(完整版),包括对Hadoop的核心组件HDFS和MapReduce的详细解析,以及它们与其他开源项目的关联"

Hadoop是一个开源的分布式计算框架,最初受到Google的分布式计算技术的启发,如GFS、BigTable和MapReduce。Hadoop主要由两个核心组件构成:Hadoop分布式文件系统(HDFS)和MapReduce计算模型。HDFS为大规模数据存储提供了高容错性、高可扩展性的解决方案,而MapReduce则负责处理数据的并行计算。

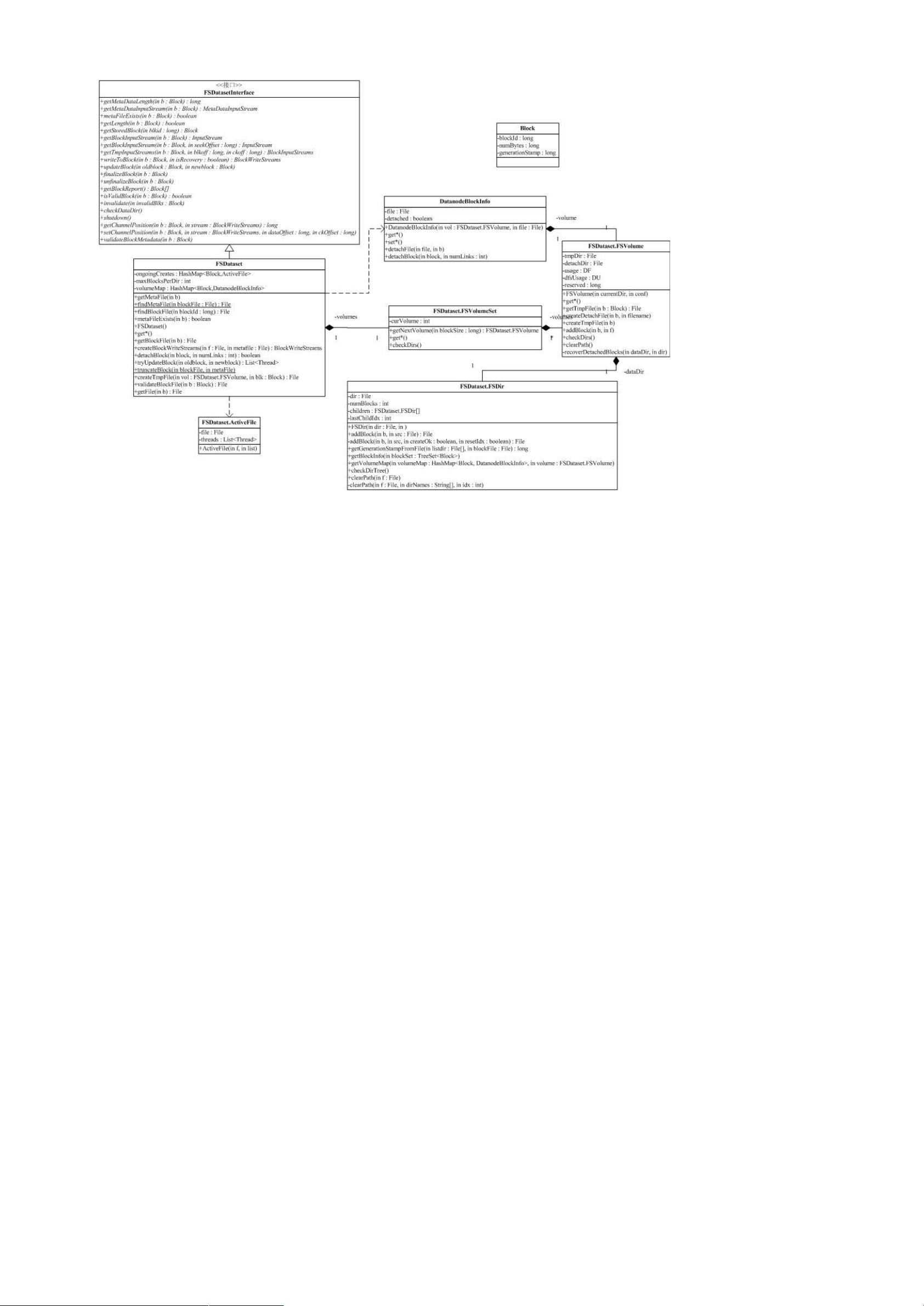

HDFS的设计目标是提供高吞吐量的数据访问,适合大数据集的应用场景。HDFS将大文件分割成块,并在集群中的多个节点上进行复制,以确保数据的可用性和容错性。HDFS的API使得应用程序可以透明地访问分布式文件系统,无需关心底层的分布式细节。HDFS中的NameNode负责元数据管理,DataNode则实际存储数据块。

MapReduce是一种编程模型,用于处理和生成大数据集。它将复杂的计算任务分解为两个阶段:Map和Reduce。Map阶段将输入数据集分割成独立的键值对,然后对每个键值对进行函数操作。Reduce阶段则聚合Map阶段的结果,对相同键的值进行合并处理,生成最终结果。Hadoop MapReduce框架负责任务调度、数据分发、错误处理等任务,使得开发人员可以专注于编写Map和Reduce函数,而不必关心底层的分布式实现。

在Hadoop的源代码中,包结构复杂,例如`conf`包用于读取系统配置,依赖于`fs`包来实现文件系统相关的操作。`fs`包抽象了不同类型的文件系统,包括本地文件系统和分布式文件系统如HDFS。`zookeeper`作为Chubby的开源替代品,用于提供分布式协调服务,确保集群中的节点能够正确通信和同步状态。

Hadoop的包功能分析可以帮助我们理解各个组件的作用和它们之间的关系。例如,`mapred`包包含了MapReduce的实现,`hdfs`包则是HDFS的相关代码。此外,`io`包处理基本的输入/输出操作,`net`包处理网络通信,`util`包提供通用工具类。

Hive是Facebook开发的一个数据仓库工具,它可以将结构化的数据文件映射为一张数据库表,并提供SQL查询功能,与Hadoop结合,用于大数据分析。HBase则是一个分布式、列式存储的NoSQL数据库,基于HDFS,提供了实时读写和强一致性的能力。

深入理解Hadoop的源代码对于优化Hadoop集群性能、解决故障、开发新的分布式应用或改进现有应用都是非常有价值的。通过源代码分析,我们可以洞察Hadoop设计的精妙之处,以及如何利用这些技术构建大规模的分布式系统。

2013-10-23 上传

2021-03-13 上传

2012-01-05 上传

2022-06-18 上传

2014-11-10 上传

emili

- 粉丝: 118

- 资源: 6

最新资源

- 构建基于Django和Stripe的SaaS应用教程

- Symfony2框架打造的RESTful问答系统icare-server

- 蓝桥杯Python试题解析与答案题库

- Go语言实现NWA到WAV文件格式转换工具

- 基于Django的医患管理系统应用

- Jenkins工作流插件开发指南:支持Workflow Python模块

- Java红酒网站项目源码解析与系统开源介绍

- Underworld Exporter资产定义文件详解

- Java版Crash Bandicoot资源库:逆向工程与源码分享

- Spring Boot Starter 自动IP计数功能实现指南

- 我的世界牛顿物理学模组深入解析

- STM32单片机工程创建详解与模板应用

- GDG堪萨斯城代码实验室:离子与火力基地示例应用

- Android Capstone项目:实现Potlatch服务器与OAuth2.0认证

- Cbit类:简化计算封装与异步任务处理

- Java8兼容的FullContact API Java客户端库介绍