加速图卷积网络的批量稀疏矩阵乘法策略

需积分: 10 139 浏览量

更新于2024-07-17

收藏 2.39MB PDF 举报

"批量稀疏矩阵乘法在加速图卷积网络中的应用"

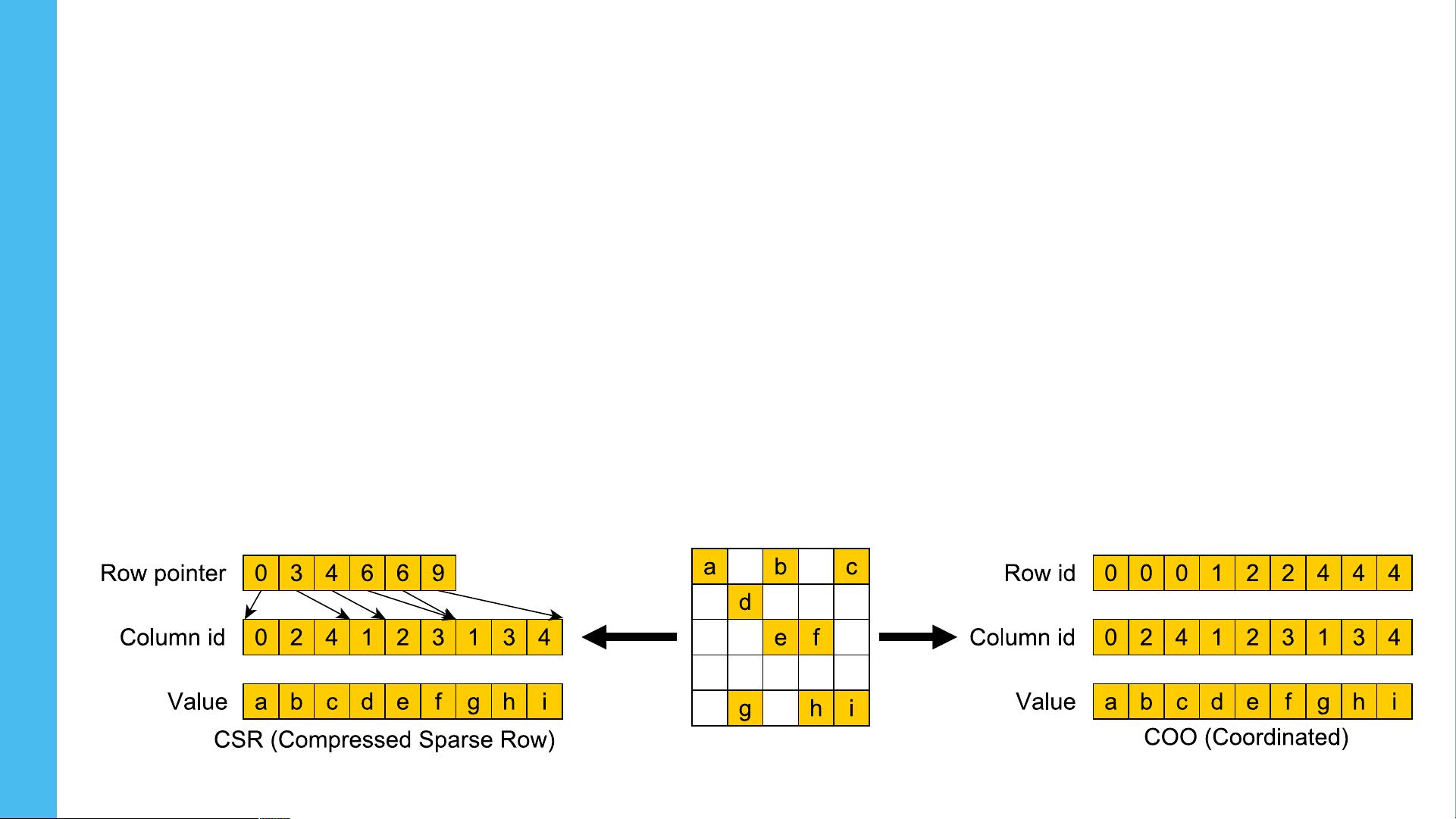

标题"Batched Sparse Matrix Multiplication for Accelerating Graph Convolutional Networks"聚焦于图卷积网络(GCNs)的性能优化策略,特别是在处理大规模图数据时,稀疏矩阵乘法(SpMM)是一种关键计算操作。图卷积是神经网络用于处理非结构化数据如化学化合物、蛋白质网络和知识图谱的有效工具。其核心概念是通过邻接矩阵表示图的结构,并通过与特征向量的交互提取节点属性。

在图卷积过程中,首先将输入图的结构(邻接矩阵A)和节点特征(X)相乘,然后与权重矩阵W以及可能的偏置项结合,形成新的特征表示Y。传统的方法可能会涉及到大量的小规模计算,比如密集矩阵与稀疏矩阵的乘法(GEMM和SpMM),这些操作占据了相当大的执行时间。

批量处理(batching)作为一种有效的优化手段,可以显著减少由于频繁启动新CUDA内核导致的启动开销。批量稀疏矩阵乘法(Batched SpMM)是实现这一目标的关键技术,它将多个图的数据整合在一起,使得每次计算可以同时处理多个图的邻接矩阵和特征向量,极大地提高了并行性和效率。

然而,实现批量稀疏矩阵乘法并非易事,需要解决的问题包括如何有效地组织数据以便充分利用硬件的并行性,如何设计高效的算法来合并计算,以及如何降低内存访问的复杂性,因为稀疏矩阵通常包含大量零元素。此外,还需要考虑如何在保持精度的同时减小计算量,避免过拟合或信息损失。

该研究者,来自东京工业大学、京都大学和理化学研究所,探讨了这些问题,并可能提出了一些创新的方法论和技术解决方案,如优化的数据布局、并行化策略和算法改进。他们的工作旨在推动GCNs在实际应用中的性能提升,尤其是在大规模数据处理场景下,如社交网络分析、药物发现等领域。

批量稀疏矩阵乘法对于加速图卷积网络具有重要意义,它不仅提升了计算效率,还可能帮助我们更好地理解和利用图数据的复杂结构。通过深入理解这个技术,我们可以期待看到更多的高效和可扩展的图神经网络模型。"

647 浏览量

2021-03-04 上传

2019-08-28 上传

380 浏览量

2024-10-07 上传

2021-04-10 上传

380 浏览量

130 浏览量

104 浏览量

不务正业的土豆

- 粉丝: 1820

- 资源: 47

最新资源

- QT 3.3 中文白皮书.pdf

- CMMI能力成熟度模型1.2版

- 信息系统项目管理师讲义

- 做PPT的技巧 doc !

- 想成为嵌入式程序员应知道的0x10个基本问题

- oracle 031 ppt les04 ppt

- 高质量C、C++编程指南

- oracle 031 ppt les02 ppt

- 不错的网上书店文档自己做个人项目的时候整理的

- oracle 031 ppt les01 ppt

- Springer.Algorithms.And.Data.Structures

- MATLABstudy.doc

- 《卓有成效的程序员》迷你书

- JavaScript 语言精髓与编程实践迷你书

- 正则表达式基础知识与常用类型

- 2006南开上机100题