一元线性回归模型详解:假设检验与预测

需积分: 28 125 浏览量

更新于2024-07-10

收藏 610KB PPT 举报

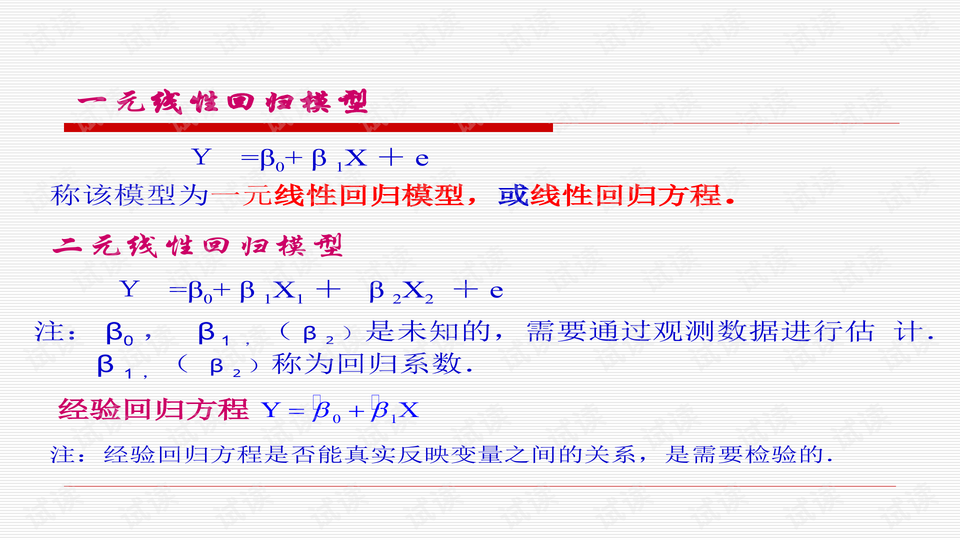

本篇文档主要探讨了假设检验与预测在回归模型中的应用,特别是关注线性回归模型。线性回归是一种广泛应用的统计模型,用于分析变量间的线性关系,包括一元线性回归(如Y=β0+β1X+e),二元线性回归(Y=β0+β1X1+β2X2+e)以及多元线性回归模型(Y=β0+β1X1+...+βpXp+e)。回归模型的核心任务是确定变量间的关系,找出可能的表达式,并通过这些关系进行预测。

1. **线性回归模型**:模型的基本形式是Y=f(X)+e,其中f(X)通常是线性函数,代表因变量Y与自变量X的关联。回归参数,尤其是回归系数(β0, β1等),需要通过最小二乘估计法来求解,确保模型拟合数据的最好方式。对于线性模型的构建,关键是验证经验回归方程是否准确反映了变量间的实际关系。

2. **回归参数估计**:最小二乘估计是最常见的方法,它寻找使残差平方和最小化的回归系数值。约束最小二乘估计则在特定条件下进行,比如线性回归模型中的回归系数需满足正态性和方差齐性等假设。

3. **回归诊断**:这涉及到对模型拟合效果的检查,如残差分析(检查残差分布的均匀性和独立性)、影响分析(研究单个观测值改变对模型的影响)、以及Box-Cox变换(用于数据转换以改善线性关系)。

4. **假设检验**:对回归方程和回归系数进行显著性检验,确认它们在统计上的显著性;异常点检验则用于识别可能影响模型结果的异常观测值;而因变量预测则是利用模型对未来观测值的估计。

5. **模型选择**:在众多可能的回归模型中,选择合适的模型至关重要。选择标准可能涉及模型的复杂度、预测性能以及解释能力。逐步回归是一种常用的方法,它通过逐步添加或删除变量来优化模型。

6. **非线性回归**:对于那些不能直接用线性关系表示的数据,可以通过适当的变换使其接近线性,再进行一元或多元线性回归分析。

回归模型的应用广泛,不仅限于理论研究,还被应用于经济学、社会科学、自然科学等各种领域,为理解变量间的关系提供了强大的工具,并为预测未来趋势提供了基础。然而,无论何种模型,都需要通过严谨的假设检验和诊断来确保其有效性。

4696 浏览量

175 浏览量

792 浏览量

127 浏览量

162 浏览量

2021-10-07 上传

104 浏览量

2021-10-07 上传

123 浏览量

顾阑

- 粉丝: 24

最新资源

- Foobar2000均衡器最强配置文件解析指南

- 汉化版PEiD软件:揭秘程序加壳类型

- DELPHI源代码分享:联众台球助手V0.6

- Java Swing实现图片读取与展示方法

- AngularJS手机目录教程:构建Web应用的完整指南

- 虚拟主机在线解压工具:网站程序一键解压

- Java通过HTTPS接口读取不同格式证书教程

- YOLO_v3自定义数据集训练:darknet文件结构解析

- DNW变换压缩文件解析

- DELPHI7开发的转换游戏代码解析与实现

- MATLAB源码:SPIHT图像压缩技术实现解析

- JavaScript克隆经典街机游戏项目指南

- Cocos2d-x 数据加密技术:MD5/SHA1/BASE64实现解析

- C#实现仿QQ自动隐藏窗口小程序教程

- 快速部署:基于Spring全家桶的企业级项目

- 实现Android手机中的真实书籍翻页效果教程