Thomas_M[1].Cover信息论教材课后习题解答

"这篇资料是关于Thomas_M[1].Cover信息论英文教材的课后习题答案,包含了一些关于熵和函数关系的问题解答,以及联合熵的实例分析。"

在信息论中,熵是一个关键的概念,它度量了一个随机变量的不确定性。熵的计算基于随机变量取值的概率分布。当讨论函数与熵的关系时,我们通常关心的是函数如何影响原始随机变量的不确定性。

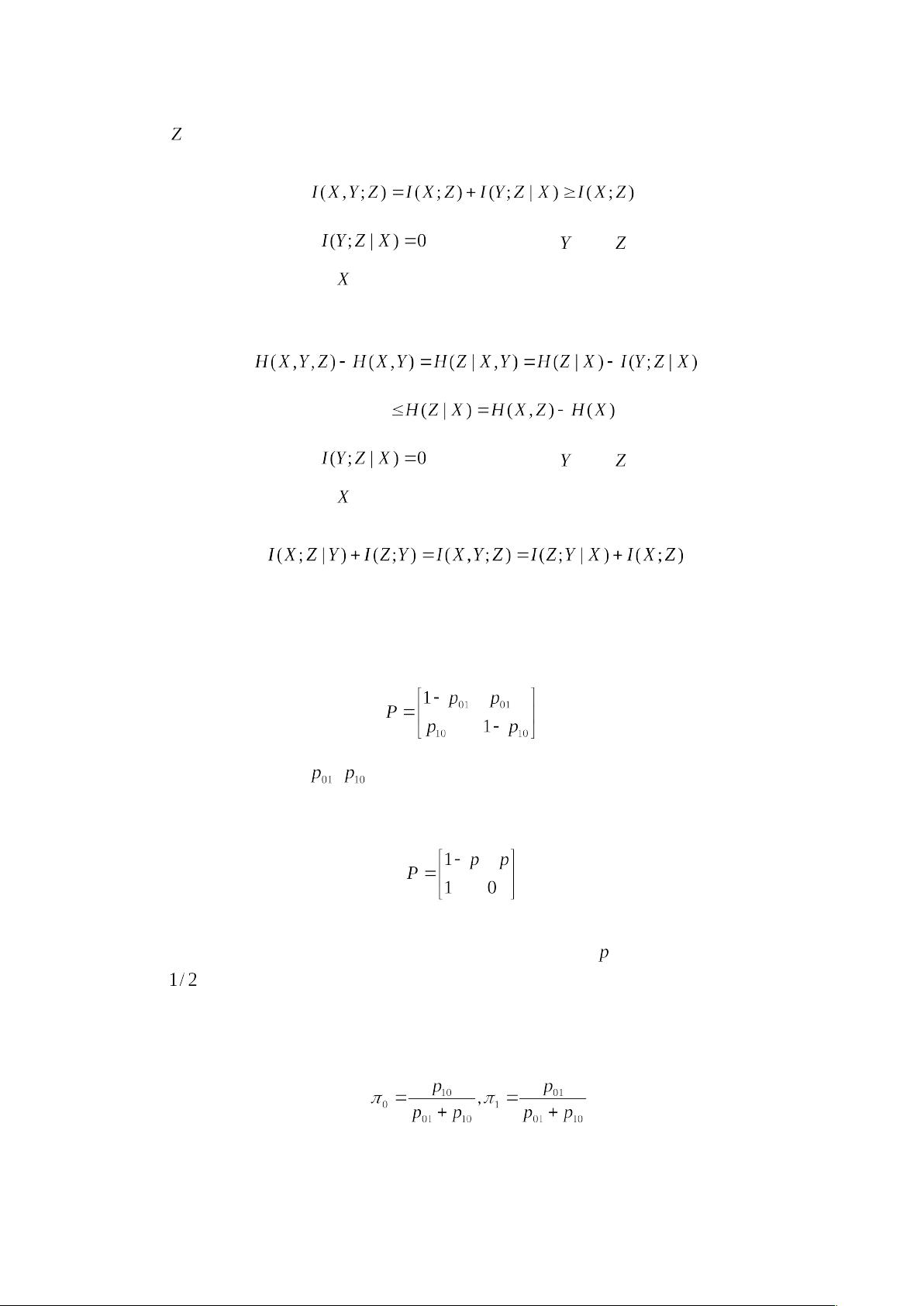

2.2节中提到了熵与函数之间的不等式关系。如果函数f将X映射到Y:

(a) 当f是一对一函数(bijection)时,意味着每个X的值都有一个唯一的Y值对应,因此熵H(Y)不会改变,即H(X) = H(Y)。因为概率分布没有被改变,熵仅依赖于概率分布。

(b) 当f不是一对一函数时,X的熵H(X)可能大于或小于H(Y),因为一个Y值可能对应多个X值,增加了不确定性。但我们可以确定的是H(X) ≥ H(Y),当且仅当f在X的范围内是一对一函数时,两者才相等。

在2.16节中,我们有一个联合熵的示例,涉及两个随机变量X和Y。给出了它们的联合概率分布表,我们需要找到各个熵和条件熵。

(a) X的熵H(X)可以通过计算每个X值的概率乘以其对应的对数来得到,即H(X) = -[1/3 log2(1/3) + 2/3 log2(2/3)]。

(b) Y的熵H(Y)可以类似地计算,得到H(Y)。同时,我们还可以计算条件熵H(Y|X),它表示知道X的值后Y的不确定性。这里,H(Y|X=0) = H(Y|X=1) = -[1/3 log2(1/3) + 1/3 log2(1/3)]。

(c) 联合熵H(X,Y)是X和Y同时出现的所有可能情况的熵之和,考虑到它们的联合概率。

(d) 条件熵H(X|Y)表明在已知Y的情况下X的不确定性,这可以通过计算所有可能的Y值下X的条件熵并加权求和得到。

(e) H(X,Y)与H(X)、H(Y)以及H(X|Y)的关系可以用信息熵的基本不等式表示,例如,H(X,Y) ≤ H(X) + H(Y)。

(f) 通过Venn图,我们可以直观地展示这些量之间的关系,如图1所示,Venn图可以帮助理解不同熵和条件熵之间的覆盖和重叠情况。

2.29节提到的不等式可能是熵的不等式,比如肖尔(Shannon)熵的单调性,数据处理不等式,或者联合熵和条件熵之间的关系等。这些不等式在信息论中扮演着核心角色,用于推导和证明其他理论结果。

这份资料提供了一个深入理解和应用信息论中熵概念的机会,包括熵的性质、函数影响、联合熵和条件熵的计算,以及它们在信息传输、压缩和编码中的应用。对于学习信息论的学生或研究人员来说,这是一份宝贵的参考资料。

2010-01-11 上传

helenaywu

- 粉丝: 10

- 资源: 3

最新资源

- WebLogic集群配置与管理实战指南

- AIX5.3上安装Weblogic 9.2详细步骤

- 面向对象编程模拟试题详解与解析

- Flex+FMS2.0中文教程:开发流媒体应用的实践指南

- PID调节深入解析:从入门到精通

- 数字水印技术:保护版权的新防线

- 8位数码管显示24小时制数字电子钟程序设计

- Mhdd免费版详细使用教程:硬盘检测与坏道屏蔽

- 操作系统期末复习指南:进程、线程与系统调用详解

- Cognos8性能优化指南:软件参数与报表设计调优

- Cognos8开发入门:从Transformer到ReportStudio

- Cisco 6509交换机配置全面指南

- C#入门:XML基础教程与实例解析

- Matlab振动分析详解:从单自由度到6自由度模型

- Eclipse JDT中的ASTParser详解与核心类介绍

- Java程序员必备资源网站大全