XGBoost详解:提升机器学习效率的利器

需积分: 39 78 浏览量

更新于2024-07-18

收藏 2.91MB PDF 举报

"陈天奇大神的XGBoost讲解PPT,内容涵盖了XGBoost的基本原理、系统功能、应用场景以及机器学习算法的常见用途。"

XGBoost是一种高效的梯度提升决策树(Gradient Boosting Decision Tree)算法,由陈天奇开发。它在机器学习领域广泛应用,因其出色的性能和易用性而备受赞誉。该算法的核心在于通过迭代构建多个决策树,并将它们集成在一起,以优化整体预测效果。

1. **简介**

XGBoost是梯度提升框架的优化实现,它针对大规模数据集进行了优化,支持分布式计算,并具有高效内存管理和并行计算能力。这使得它能够在处理大量数据时保持快速运行速度。

2. **XGBoost学习什么**

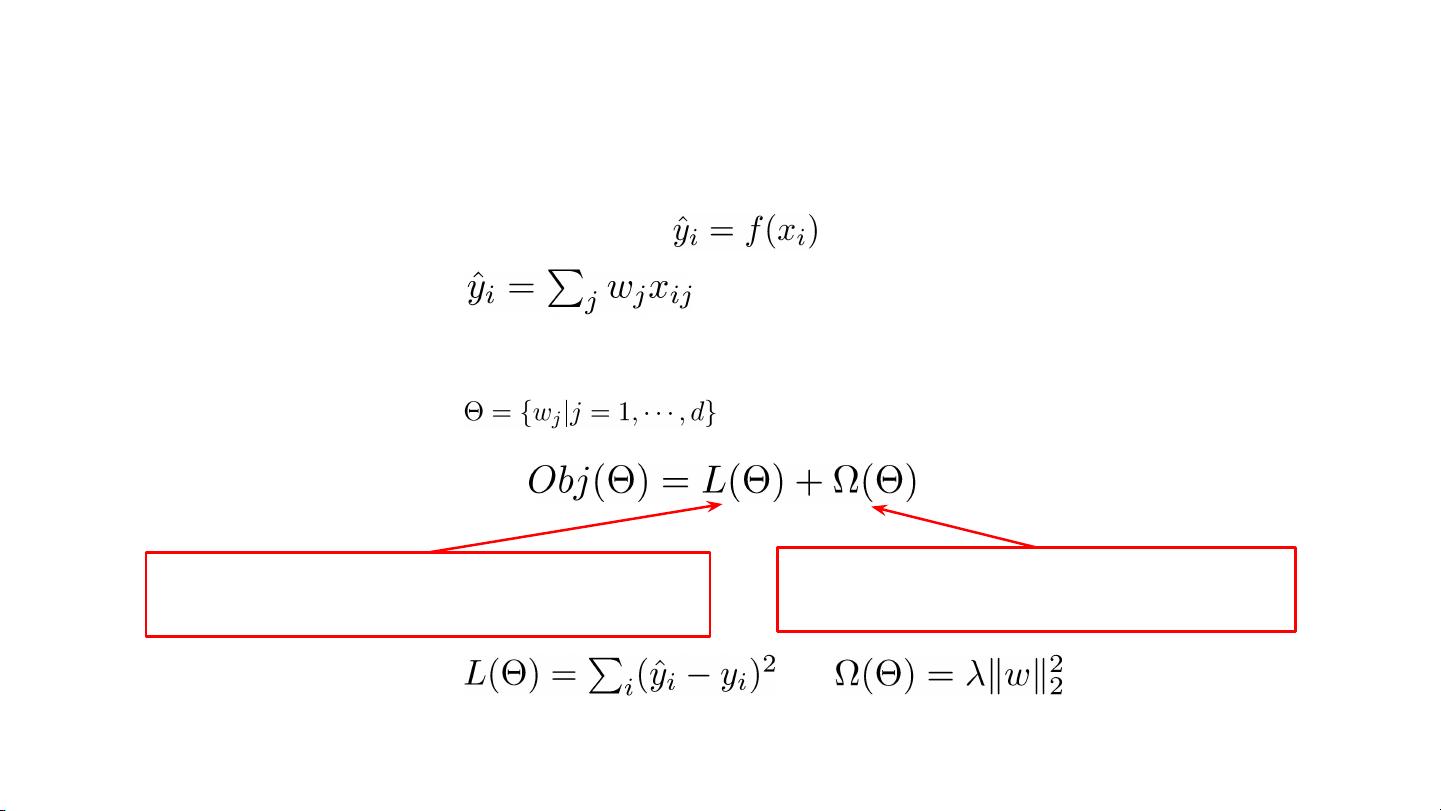

XGBoost学习的是一个加权模型,其中每个决策树都是对当前模型残差的修正。它通过最小化损失函数来训练模型,损失函数通常包括预测误差和模型复杂度的正则项,以防止过拟合。

3. **XGBoost系统能做什么**

- 提供了一个用户友好的API,方便用户进行模型训练和评估。

- 支持多种目标函数和评价指标,适用于分类、回归等多种任务。

- 内置特征重要性评估,有助于特征选择和模型解释。

- 具有并行和分布式计算能力,适应大数据环境。

4. **机器学习算法的应用场景**

- **线性模型**:常用于广告点击率预测,通过线性组合特征权重进行预测。

- **因子分解模型**:在推荐系统中,用于捕捉特征之间的非线性关系。

- **深度神经网络**:适用于图像、音频等高维度数据的识别和分类。

- **决策树**:尤其适合表格数据,广泛应用于异常检测、广告点击率预测、欺诈检测、保险风险评估等领域。

5. **决策树与森林**

- **决策树**(如CART)通过分裂节点来最大化信息增益或基尼指数,形成一系列规则来预测结果。每个叶子节点代表一个预测得分。

- **随机森林**:通过随机选择特征和样本来构建多棵树,然后取平均预测结果,降低过拟合风险。

- **梯度提升树**:逐步添加新树来减小残差,如GBDT,每棵树都聚焦于改进前一棵树的不足。

6. **算法变体**

- **随机森林**:由Breiman在1997年提出,Python中的`RandomForest`包提供了实现。

- **梯度提升树**:Friedman在1999年提出的算法,例如在`sklearn`库中的`GradientBoostingClassifier`和`GradientBoostingRegressor`。

XGBoost不仅在学术界受到关注,也在工业界广泛应用,如 Kaggle 竞赛中,XGBoost经常被用作赢得比赛的关键工具。其背后的优化技术和高效实现使其成为机器学习工具箱中的重要一环。

相关推荐

风生水气

- 粉丝: 378

最新资源

- Matlab数字信号处理实例源代码深入解析

- 使用SHFB创建DLL方法说明的HTML帮助文档

- QQ截图工具:文章写作中的得力助手

- Madgwick算法实现:C语言与Matlab代码解析

- 云台矩阵控制软件的功能与应用

- CMMI模型中英文术语对照解析

- task-yargs: 实现复杂程序的多子任务命令行界面

- RecyclerView基础实践与源码解析

- 制作透明文字背影图片的简易方法

- 北京理工大学分布式数据库课程核心课件解析

- C#实现单/双/循环链表的完整源码解析

- 掌握易语言实现汇编调用关机菜单的技巧

- Java实现多功能ZIP压缩工具包发布

- 冰点文库:一键免费获取百度文库等资源

- Mint-UI:一套完整的jQuery Web插件工具包介绍

- IIS宿主下WCF服务演示程序的构建与实现