使用Scrapy爬虫框架进行数据抓取

需积分: 0 194 浏览量

更新于2024-08-04

收藏 347KB DOCX 举报

"数据清洗可视化期末sad1阿斯顿撒多"

在IT领域,数据清洗和可视化是至关重要的步骤,特别是在处理Web数据时。本资源涉及的是使用Scrapy框架进行数据爬取、清洗以及可能的数据可视化过程。Scrapy是一个强大的Python爬虫框架,适用于快速开发复杂的爬虫项目。

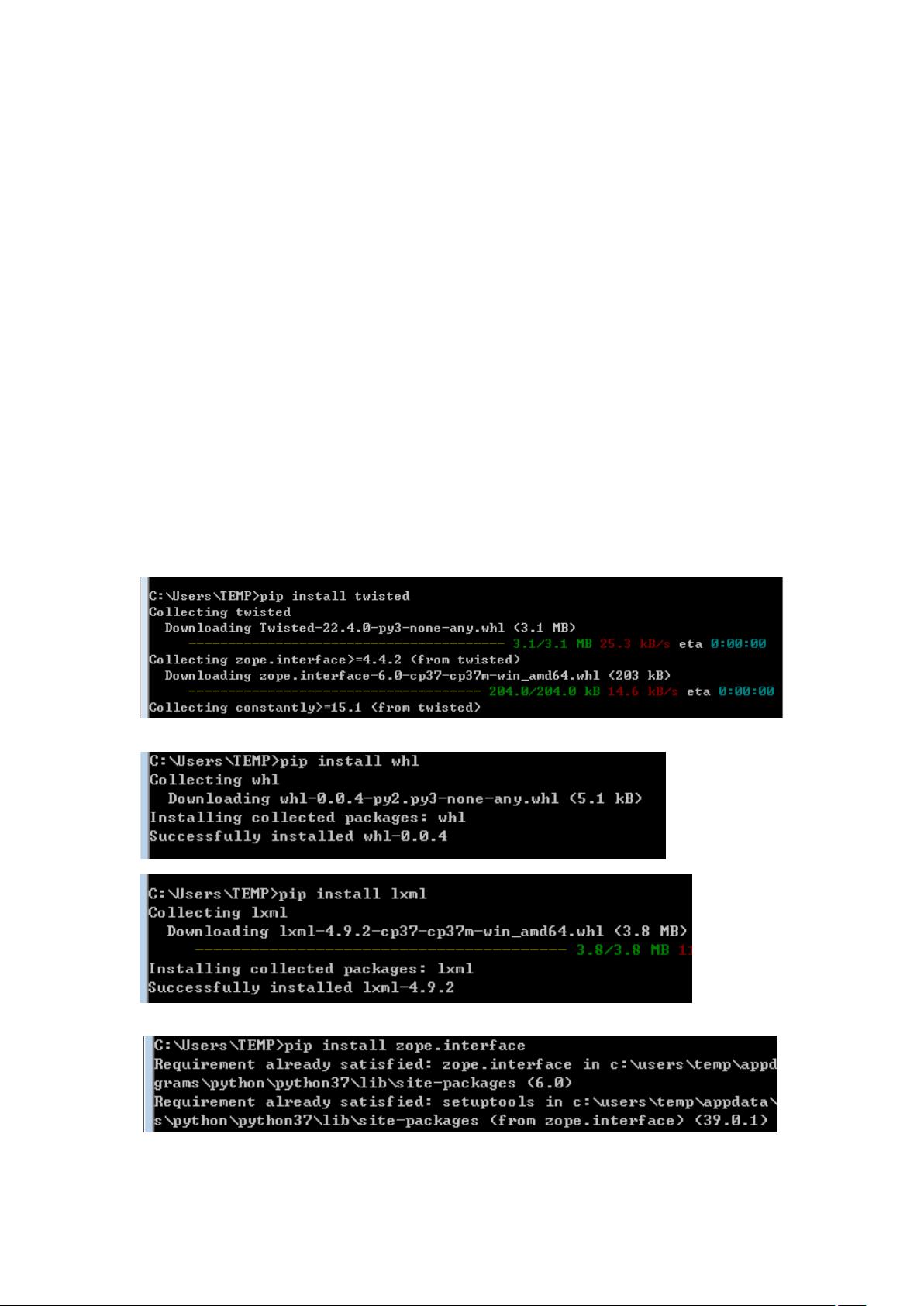

首先,要安装Scrapy,你需要确保已经安装了Python,并且通过Python的包管理器pip下载和安装Scrapy的依赖库,包括Twisted、wheel、lxml、zope.interface、pywin32(仅Windows系统)、以及pyOpenSSL。这些库对于Scrapy的正常运行是必要的,它们提供了网络通信、XML和HTML解析等功能。

接下来,我们创建一个新的Scrapy项目。在这个例子中,项目名为"AmericanFilm"。通过运行`scrapy startproject AmericanFilm`命令,可以初始化一个Scrapy项目结构。然后,进入项目目录`cd AmericanFilm`,并使用`scrapy genspider meijumeijutt.tv`创建一个名为"meiju"的爬虫程序,目标网站是"meijutt.tv"。

在爬虫代码中,`meiju.py`文件定义了一个名为`MeijuSpider`的类,继承自Scrapy的`Spider`类。这个类设置了爬虫的基本属性,如名称、允许的域名和起始URL。`parse`方法是Scrapy默认的回调函数,当爬虫请求的页面响应返回时,该方法会被调用。在这里,它使用XPath选择器抓取网页上的电影列表信息,并将数据存储到`AmericanFilmItem`对象中。

`items.py`文件定义了`AmericanFilmItem`类,它是一个Scrapy Item,用于存储爬取的数据。在这个例子中,只有一个字段`name`,用于存放电影的名称。

`settings.py`是Scrapy项目的配置文件,其中定义了项目的行为。`ITEM_PIPELINES`指定了一个管道(pipeline),用于处理爬取到的物品(items)。`AmericanFilmPipeline`被设置为100的优先级,意味着它会在所有其他优先级低于100的管道之前执行。`ROBOTSTXT_OBEY`被设置为False,表示爬虫会忽略站点的robots.txt规则,`DOWNLOAD_DELAY`设置为1秒,意味着两次请求之间有1秒的延迟,以防止对目标网站造成过大的访问压力。

最后,`pipelines.py`文件定义了`AmericanFilmPipeline`类,它负责处理和保存爬取到的数据。在`process_item`方法中,数据被转换为JSON格式并可能保存到本地文件或其他持久化存储中。

总结起来,这个项目展示了如何使用Scrapy框架从指定的电影网站抓取数据,进行简单的数据提取,然后通过自定义的管道进行数据清洗和存储。这只是一个基础的示例,实际的数据清洗和可视化过程中可能涉及到更复杂的数据处理、异常处理、数据验证、数据清洗和利用各种数据可视化工具(如Matplotlib、Seaborn或Pandas的内置功能)将数据转化为可读的图表和图形,以便于分析和理解。

129 浏览量

296 浏览量

2025-01-20 上传

2025-01-20 上传

2025-01-20 上传

2025-01-20 上传

2025-01-20 上传

喜欢编程的老白

- 粉丝: 8

最新资源

- C++编程语言第三版权威指南

- ExtJS基础教程:快速入门和开发指南

- 华为Java面试深度解析

- IBM AIX系统:关键命令探秘硬件架构与资源管理

- AIX系统维护全方位指南:日常管理到高级技巧

- Trac软件项目管理平台使用手册

- MAX3471:低功耗锂电驱动器,确保远程读数与安全通信

- ASP技术驱动的留言板系统设计与实现

- XMLHttpRequest使用教程与示例

- Windows系统文件详解:关键实用工具与驱动

- Div+CSS布局全攻略:从入门到高级实战

- BIOS设置中英文对照全解

- Java初学者必备:Sun公司CoreJava经典源代码示例

- DOS批处理基础教程:简单易懂的命令行操作指南

- Linux服务器技术与配置实战

- 机电系统智能控制:神经网络与模糊控制期末试题解析