快速精确的Hessian矩阵乘法技术在神经网络中的应用

71 浏览量

更新于2024-08-25

收藏 175KB PDF 举报

"Fast Exact Multiplication by the Hessian - 1993 (nc-hessian)-计算机科学"

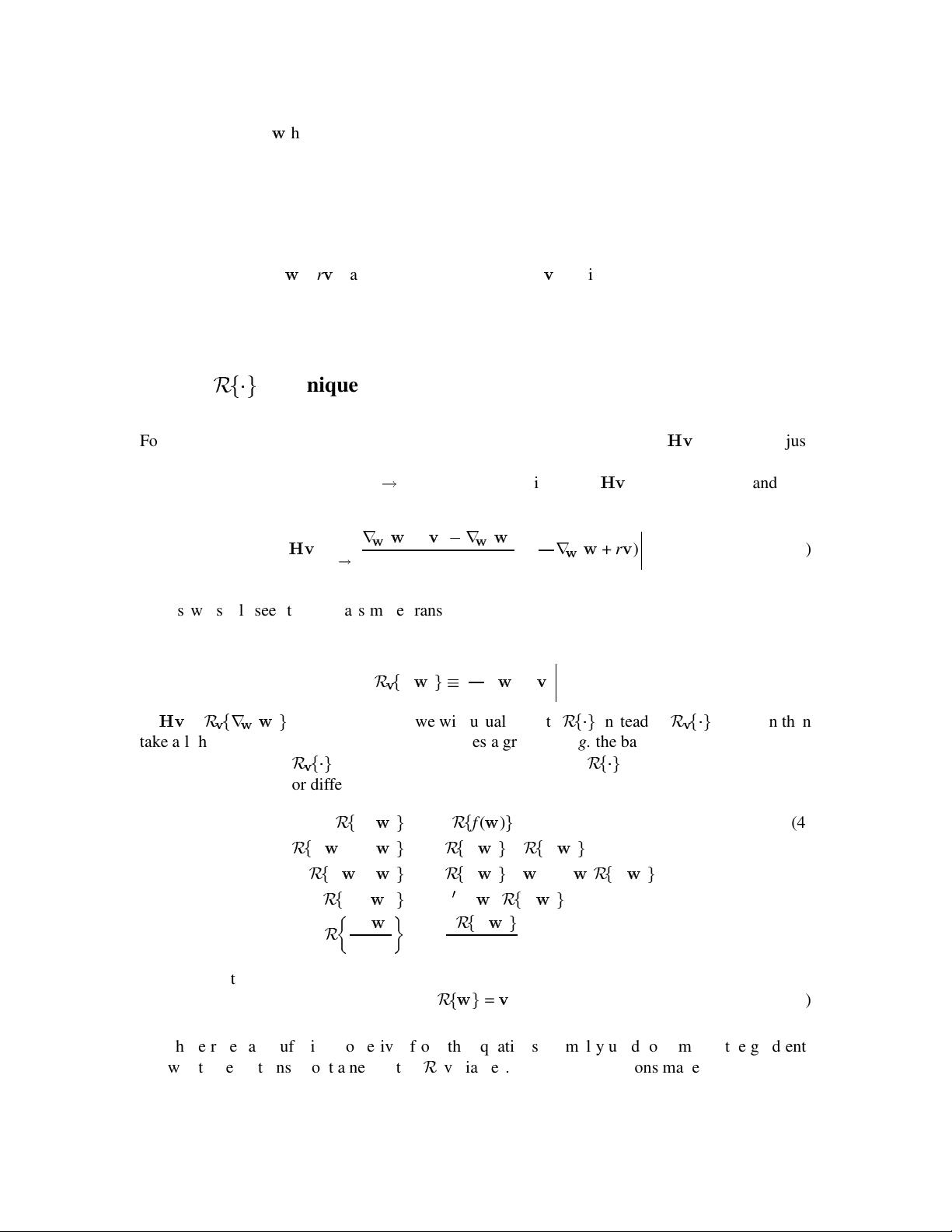

这篇论文由Barak A. Pearlmutter撰写,发表于1993年,主要探讨了在大型神经网络中快速精确地计算Hessian矩阵与向量乘积的问题。Hessian矩阵是误差E关于每个权重对的二阶导数∂^2E/∂wi∂wj的集合,对于大型网络来说,存储Hessian本身就极具挑战性。由于常常需要计算这类大矩阵与不同向量的乘积,作者提出了一种直接计算技术。

该技术的核心在于定义了一个微分算子,记作Δf(r) = (∂/∂r)f(r + α),其中α是任意向量。通过这个算子,可以将Hessian与向量v的乘积转换为计算Δ^2f(0)。注意到Δ^2f(0)等于Hessian与v的乘积,而Δf(0)等于v。接着,该技术应用到用于计算梯度的方程上,从而得到一个精确且数值稳定的计算Hessian与向量乘积的算法,其计算量大致相当于一次梯度评估,并且具有相当的局部性。

论文进一步将这种方法应用于四种不同的优化算法:

1. 一次通过的梯度计算算法(Backpropagation):这是反向传播算法的一种形式,通过链式法则计算损失函数关于权重的梯度。

2. 放松梯度计算算法(Recurrent Backpropagation):这种算法涉及到递归网络的训练,它允许信息在时间步之间回传,以改进权重更新。

3. 随机梯度计算算法(Stochastic Gradient Descent,SGD):在这种方法中,随机选取小批量数据来估计梯度,以减少计算成本并提高收敛速度。

4. 波尔兹曼机(Boltzmann Machine)的学习算法:这是一种概率图模型,利用模拟退火或Gibbs采样进行学习,其中涉及到了随机梯度下降的变体。

通过这些应用,Pearlmutter的算法展示了在各种优化策略中提高效率和稳定性的潜力,特别是在处理大规模神经网络时,能够有效地处理Hessian矩阵的计算问题,这对于网络参数的调整和学习过程的优化至关重要。

128 浏览量

174 浏览量

300 浏览量

2023-04-05 上传

2025-01-24 上传

2025-01-16 上传

182 浏览量

2023-07-08 上传

224 浏览量

weixin_38723027

- 粉丝: 9

最新资源

- C#实现程序A的监控启动机制

- Delphi与C#交互加密解密技术实现与源码分析

- 高效财务发票管理软件

- VC6.0编程实现删除磁盘空白文件夹工具

- w5x00-master.zip压缩包解析:W5200/W5500系列Linux驱动程序

- 数字通信经典教材第五版及其答案分享

- Extjs多表头设计与实现技巧

- VBA压缩包子技术未来展望

- 精选多类型导航菜单,总有您钟爱的一款

- 局域网聊天新途径:Android平台UDP技术实现

- 深入浅出神经网络模式识别与实践教程

- Junit测试实例分享:纯Java与SSH框架案例

- jquery xslider插件实现图片的流畅自动及按钮控制滚动

- MVC架构下的图书馆管理系统开发指南

- 里昂理工学院RecruteSup项目:第5年实践与Java技术整合

- iOS 13.2真机调试包使用指南及安装