视频字幕生成:从CNN+LSTM到S2VT模型

需积分: 40 16 浏览量

更新于2024-07-17

3

收藏 7.64MB DOCX 举报

“Video caption是指从视频中自动生成一段描述性的文字,以体现视频的主要内容和特征之间的关系。这一技术结合了视频特征提取和循环神经网络(RNN)的语义生成,尤其使用了卷积神经网络(CNN)和长短期记忆网络(LSTM)。”

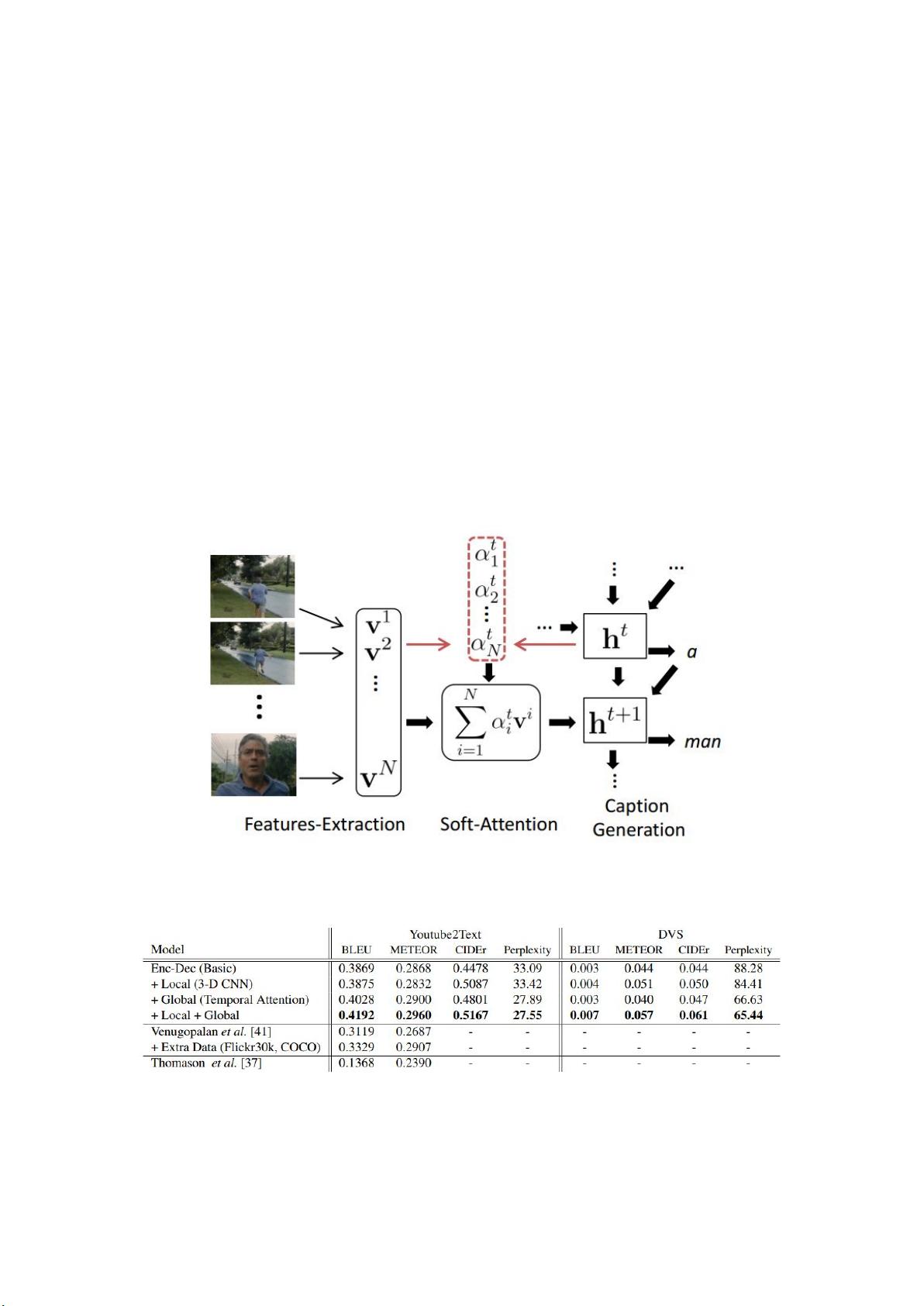

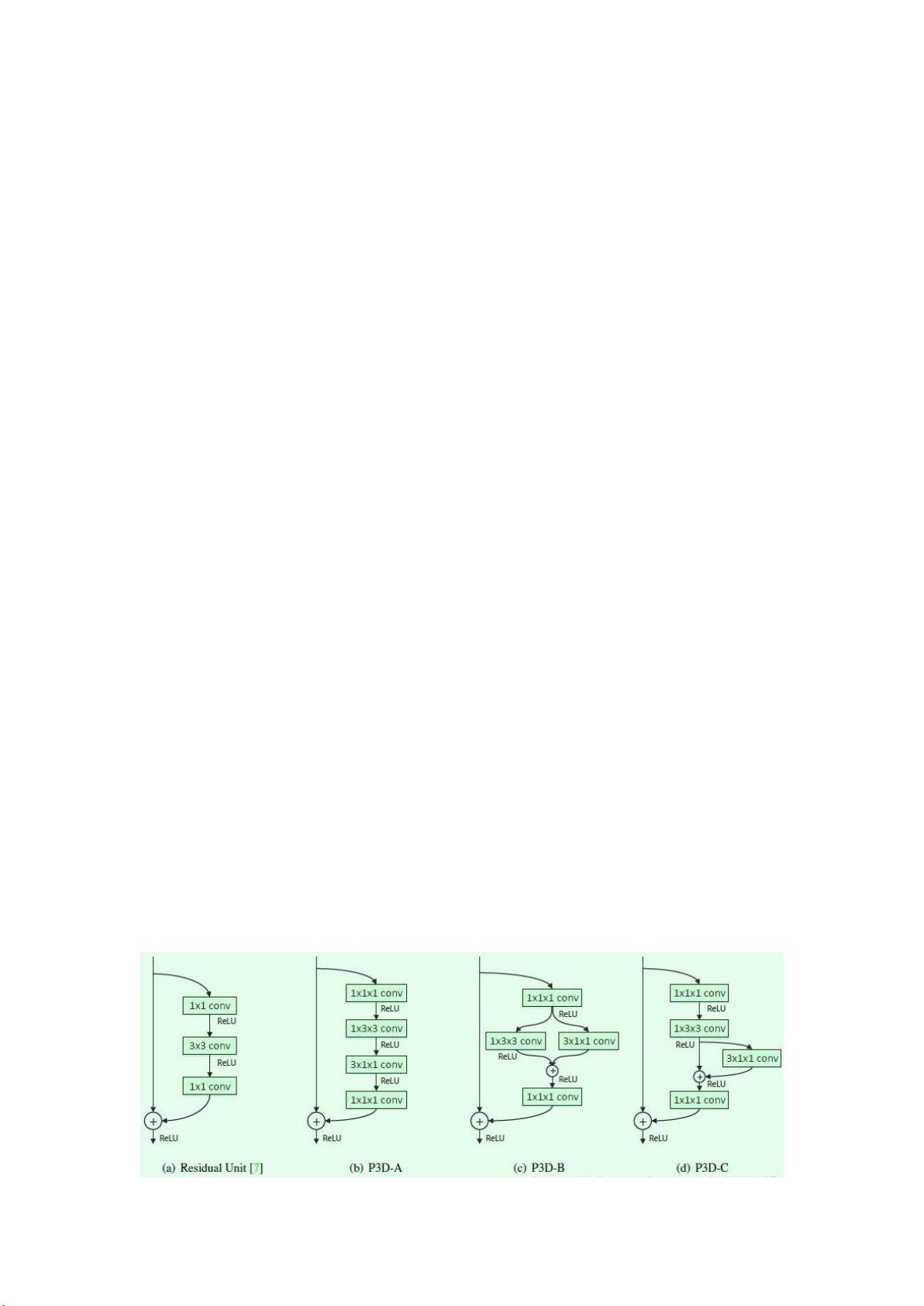

在“video caption”这一领域,研究主要集中在如何有效地从视频中捕获关键信息,并生成连贯、准确的文本描述。《Translating Videos to Natural Language Using Deep Recurrent Neural Networks》这篇论文由University of California, Berkeley的研究团队在CVPR 2015上发表,提出了一个基于image caption的video caption框架。他们将视频分割成帧,利用CNN提取每一帧的特征,然后通过meanpool方法整合这些特征来表示整个视频。接着,他们采用多层LSTM的RNN结构,将编码后的特征向量作为输入,生成最终的caption。双层LSTM有助于在输出时减少输入扰动,增强网络的记忆能力。然而,这种方法的一个局限是,它忽视了帧之间的顺序信息和视频的时序结构。

为了克服上述问题,另一篇名为《sequence to sequence -- video to text》的论文再次由UC Berkeley的研究者在CVPR 2015上提出,他们引入了S2VT模型。S2VT模型由两层LSTM构成,第一层处理帧级别的特征,第二层负责生成句子。这种结构能够更好地处理视频的时序特性,因为它在编码阶段考虑了帧的顺序,并在解码阶段生成句子。在训练过程中,顶层LSTM接收帧序列并编码,而第二层LSTM则根据第一层的隐藏状态生成单词。这个过程利用平行语料库进行端到端学习。

实验评估通常使用如YouTube2Text(也称为MSVD)数据集,其中包含1970段10-25秒的YouTube视频片段,每段视频都有大约40条英文描述。模型如LSTM-YT和S2VT在这类数据集上进行了测试,展示出较好的性能,尤其是在捕捉视频时序性和生成连贯描述方面。

总结来说,“video caption”技术结合了深度学习的图像理解和自然语言处理能力,旨在自动化地为视频生成描述,这在视频摘要、搜索和无障碍服务等方面具有广泛的应用潜力。通过不断优化模型结构,如S2VT模型对时序信息的处理,研究者们正逐步提升视频caption的准确性和流畅性。

173 浏览量

710 浏览量

136 浏览量

171 浏览量

107 浏览量

Josephq_ssp

- 粉丝: 3

最新资源

- 基于C语言的链表图书管理系统设计与文件操作

- 开源Quintum Tenor VoIP CDR服务器解决方案

- EnameTool:一站式域名查询解决方案

- 文件夹加密软件GLSCC-WLL:保护隐私文件不被查看

- 伟诠电子WT51F104微处理器的验证程序分析

- 红酒主题创意PPT模板设计:多彩三角形元素

- ViewWizard:程序窗口查看与进程监控工具

- 芯片无忧:U盘设备检测及信息查询工具

- XFTP5下载指南:便捷的文件传输解决方案

- OpenGatekeeper:探索开源H.323 Gatekeeper技术

- 探索龙卷风网络收音机的强大功能与使用技巧

- NOIP2011 标准程序精简代码解析

- 公司新春联谊会PPT模板设计与活动流程

- Android开发Eclipse ADT插件详解及安装指南

- 仅首次显示的引导界面实现技术

- 彼得·赫雷肖夫重编的《矩阵的几何方法》正式发布