理解机器学习:准确率陷阱与混淆矩阵详解

85 浏览量

更新于2024-08-30

收藏 275KB PDF 举报

在机器学习基础的笔记2中,我们讨论了准确率作为衡量分类模型性能的局限性。虽然高准确率通常给人留下好印象,但在处理实际问题时,特别是在样本极度不平衡的情况下,如癌症检测,仅依赖准确率可能会导致误导。例如,当患病率极低时,一个简单的系统只需持续预测“无癌症”就能达到接近99.9%的准确率,但这并不意味着模型真正有效。

准确率并未充分考虑误报和漏报的情况。误报(False Positive, FP)是指模型错误地预测了健康个体患有癌症,而漏报(False Negative, FN)则是指模型未能识别出实际患有癌症的人。这两种情况在医疗领域尤为关键,因为误报可能导致不必要的治疗和焦虑,而漏报则可能导致疾病的延误。

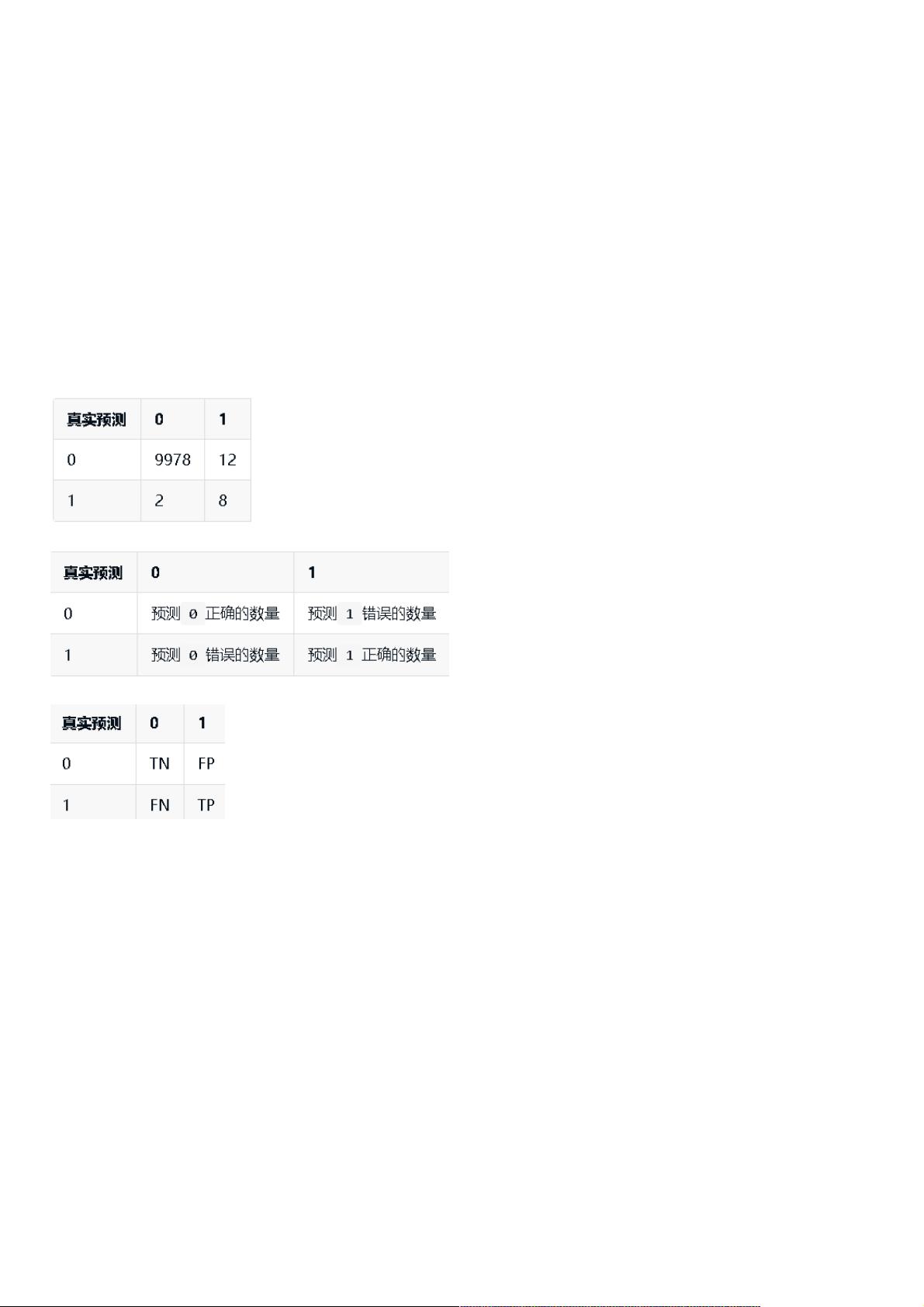

为了更全面地评估模型性能,引入了混淆矩阵这一工具。混淆矩阵是一个二维表格,用于展示实际类别与预测类别的对比。矩阵中的四个元素——真阳性(True Positive, TP)、真阴性(True Negative, TN)、假阳性(False Positive, FP)和假阴性(False Negative, FN)分别对应了四种可能的结果组合。

以癌症检测为例,当模型预测为1(癌症)和0(非癌症)时,混淆矩阵可以帮助我们计算精准率(Precision, TP / (TP + FP))和召回率(Recall, TP / (TP + FN)),这两个指标分别衡量了模型在预测为正例时的正确性和模型找出所有正例的能力。

Python中的实现如下:

```python

import numpy as np

def confusion_matrix(true_labels, predicted_labels):

tp = np.sum((true_labels == 1) & (predicted_labels == 1))

tn = np.sum((true_labels == 0) & (predicted_labels == 0))

fp = np.sum((true_labels == 0) & (predicted_labels == 1))

fn = np.sum((true_labels == 1) & (predicted_labels == 0))

return np.array([[tn, fp], [fn, tp]])

# 示例用法

true_data = [0]*9978 + [1]*12

predicted_data = [0]*9978 + [1]*12

matrix = confusion_matrix(true_data, predicted_data)

```

通过混淆矩阵,我们可以更深入地分析模型的表现,尤其是在关注精度和召回率时,这两个指标能提供比单一的准确率更为全面的评估,尤其是在处理不平衡数据集时。理解并运用混淆矩阵对于优化模型、避免误诊和漏诊至关重要。

2018-03-28 上传

2022-06-10 上传

2023-11-07 上传

2023-11-03 上传

2021-01-06 上传

2018-02-06 上传

weixin_38603259

- 粉丝: 5

- 资源: 922

最新资源

- Java毕业设计项目:校园二手交易网站开发指南

- Blaseball Plus插件开发与构建教程

- Deno Express:模仿Node.js Express的Deno Web服务器解决方案

- coc-snippets: 强化coc.nvim代码片段体验

- Java面向对象编程语言特性解析与学生信息管理系统开发

- 掌握Java实现硬盘链接技术:LinkDisks深度解析

- 基于Springboot和Vue的Java网盘系统开发

- jMonkeyEngine3 SDK:Netbeans集成的3D应用开发利器

- Python家庭作业指南与实践技巧

- Java企业级Web项目实践指南

- Eureka注册中心与Go客户端使用指南

- TsinghuaNet客户端:跨平台校园网联网解决方案

- 掌握lazycsv:C++中高效解析CSV文件的单头库

- FSDAF遥感影像时空融合python实现教程

- Envato Markets分析工具扩展:监控销售与评论

- Kotlin实现NumPy绑定:提升数组数据处理性能