PyTorch网络参数计数与层级分析

91 浏览量

更新于2024-08-28

收藏 77KB PDF 举报

在PyTorch中,理解并计算网络模型的参数数量是至关重要的,特别是在进行深度学习模型的训练和优化过程中。本文档提供了两种方法来求解网络模型的参数总数,重点集中在如何通过逐层分解参数来计算总参数量。

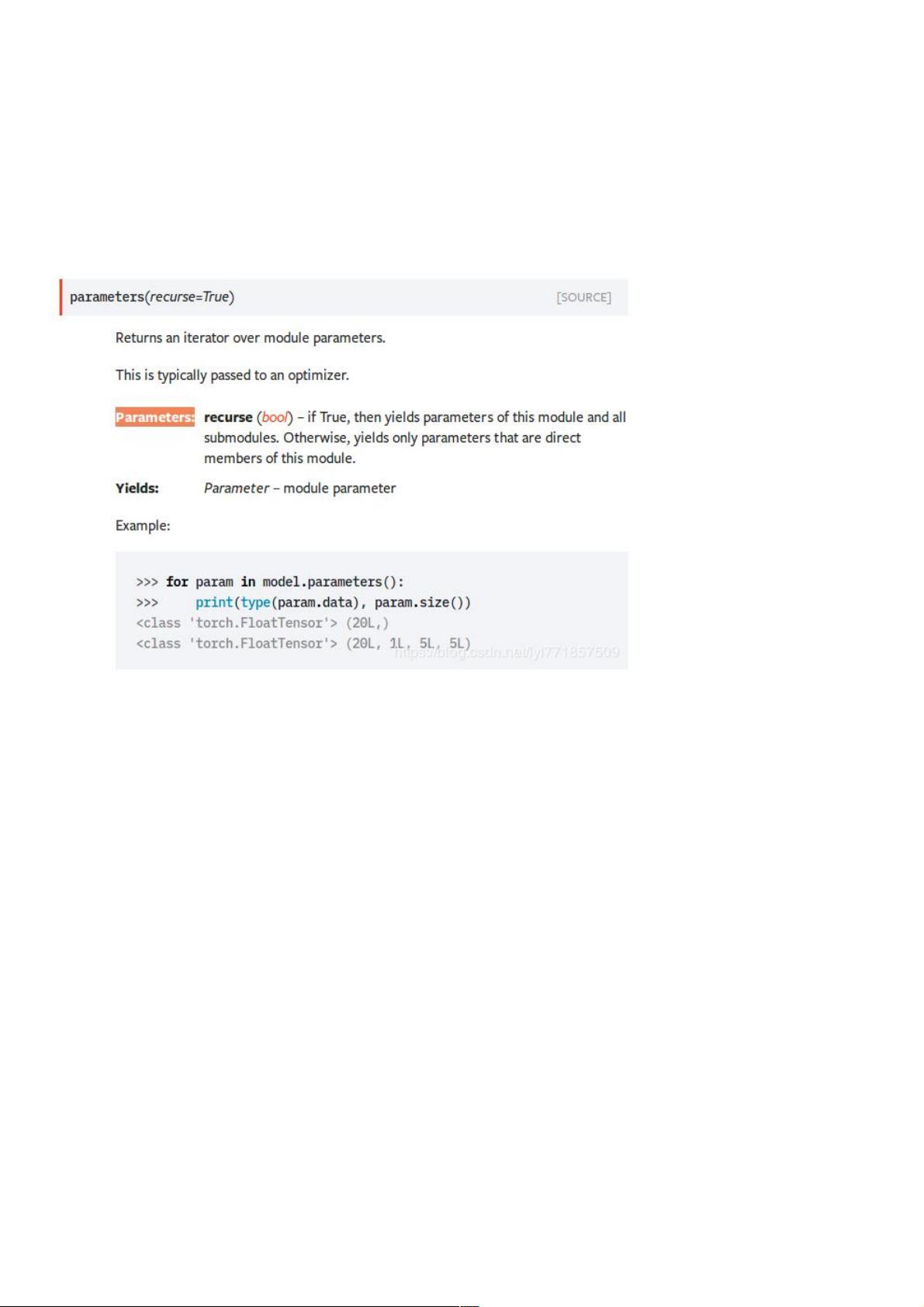

首先,创建一个神经网络模型,如`model=cliqueNet()`,这个模型内含了一组初始参数。接下来,通过调用`model.parameters()`来获取该模型的所有参数。这一操作常用于将参数列表传递给优化器,例如Adam优化器,示例代码为`optimizer = optim.Adam(model.parameters(), lr=opt.lr)`。

然后,作者介绍了一个名为`get_number_of_param()`的函数,它遍历模型中的每个参数(Variable),并计算其维度大小(`param.size()`)。对于每个参数,通过遍历其维度,计算出单个参数的元素数量(`count_of_one_param`)。函数依次累加每个参数的元素数,最后返回总参数数量。在提供的代码片段中,作者展示了针对不同层的参数计算示例:

1. 第一层参数:torch.Size([64,1,3,3]),对应于576个参数。

2. 第二层参数:torch.Size([64]),对应于64个参数。

3. 更复杂的卷积层参数:torch.Size([6,36,64,3,3]),共有124,416个参数。

4. 另一层卷积层参数:torch.Size([30,36,36,3,3]),有349,920个参数。

5. 全连接层参数:torch.Size([12,36]),有432个参数。

6. 又一个卷积层参数:torch.Size([6,36,216,3,3]),约为419,904个参数。

7. 最后一层重复的参数计算。

这些例子表明,通过逐层计算,我们可以准确地确定网络模型的总参数数量。这在调整学习率、监控模型复杂度或评估模型存储需求时都非常有用。理解网络参数结构和计算方法对于有效利用PyTorch进行深度学习至关重要。

2021-02-05 上传

点击了解资源详情

2020-09-18 上传

2020-09-18 上传

2020-09-18 上传

2020-09-18 上传

2020-09-18 上传

2020-09-18 上传

2020-09-18 上传

weixin_38665193

- 粉丝: 6

- 资源: 988

最新资源

- MATLAB实现小波阈值去噪:Visushrink硬软算法对比

- 易语言实现画板图像缩放功能教程

- 大模型推荐系统: 优化算法与模型压缩技术

- Stancy: 静态文件驱动的简单RESTful API与前端框架集成

- 掌握Java全文搜索:深入Apache Lucene开源系统

- 19计应19田超的Python7-1试题整理

- 易语言实现多线程网络时间同步源码解析

- 人工智能大模型学习与实践指南

- 掌握Markdown:从基础到高级技巧解析

- JS-PizzaStore: JS应用程序模拟披萨递送服务

- CAMV开源XML编辑器:编辑、验证、设计及架构工具集

- 医学免疫学情景化自动生成考题系统

- 易语言实现多语言界面编程教程

- MATLAB实现16种回归算法在数据挖掘中的应用

- ***内容构建指南:深入HTML与LaTeX

- Python实现维基百科“历史上的今天”数据抓取教程