BERT微调实践:命名实体识别任务

需积分: 5 179 浏览量

更新于2024-06-15

收藏 545KB PDF 举报

"使用BERT预训练模型微调实现命名实体识别任务"

BERT(Bidirectional Encoder Representations from Transformers)是Google于2018年推出的一种基于Transformer架构的预训练语言模型,它通过在大规模无标注文本数据上进行预训练,学习到丰富的语言表示。这个模型在多个自然语言处理(NLP)任务上表现出色,包括问答系统、情感分析、机器翻译等。本文将详细介绍如何使用BERT模型对预训练权重进行微调,以适应命名实体识别(NER)任务。

命名实体识别是NLP中的一个基础任务,目标是从文本中识别出具有特定意义的实体,如人名、地名、组织名等,并对其分类。在这个过程中,我们需要定义实体类别并为其分配唯一的标识符。

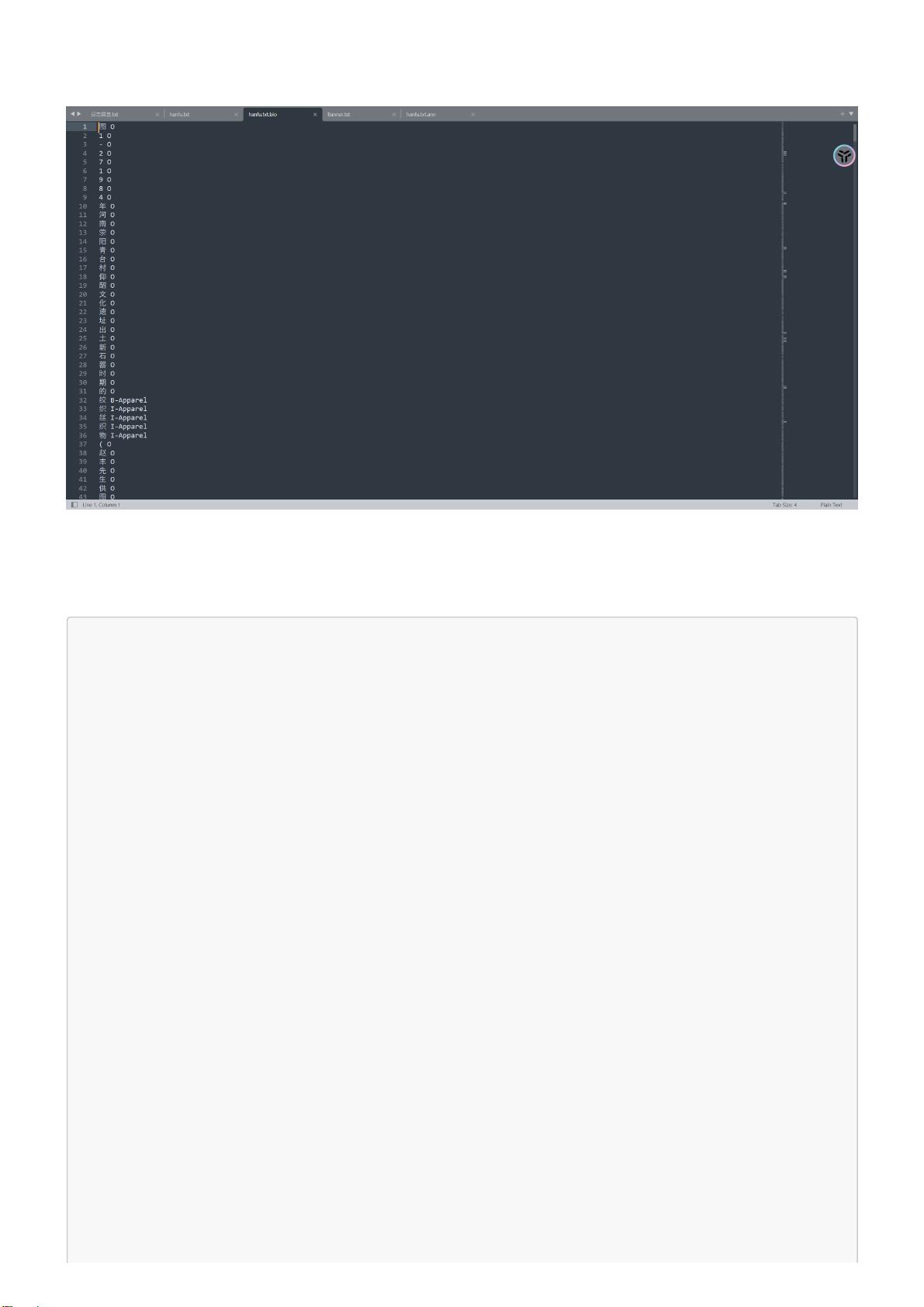

首先,定义实体类别是至关重要的一步。在示例中,我们有以下实体类别:address(地址)、book(书籍)、company(公司)、game(游戏)、government(政府)、movie(电影)、name(名字)、organization(组织)、position(职位)和scene(场景)。每个类别都包含“B-”和“I-”前缀的标签,其中“B-”表示实体的开始,而“I-”表示实体内部的部分。此外,“O”标签用于标记非实体的单词。

接下来,我们创建一个label_names列表,包含所有可能的实体标签,然后根据这个列表生成一个id2label字典,将标签名称映射到整数ID,以及一个label2id字典,将整数ID映射回标签名称。这些字典在模型训练和预测阶段用于将标签数据转换为模型可理解的格式。

微调BERT模型通常包括以下步骤:

1. **数据预处理**:将原始文本数据转化为模型输入所需的格式。对于BERT,这通常涉及将文本切分为固定长度的序列,添加特殊标记(如 `[CLS]` 和 `[SEP]`),并进行掩码词汇编码。

2. **加载预训练模型**:使用预训练的BERT模型,这可以从Hugging Face的Transformers库中获取。预训练模型已经学习了大量语言知识,我们可以在此基础上进行微调。

3. **构建模型架构**:在BERT模型的基础上添加一个或多个任务特定的层,如全连接层(FC layer)来处理NER任务。这些额外的层会在微调过程中学习捕捉特定任务的特征。

4. **定义损失函数**:对于NER,通常使用交叉熵损失函数,因为它可以衡量模型预测的标签与真实标签之间的差异。

5. **训练**:将预处理的数据送入模型,通过反向传播优化器更新模型参数,以最小化损失函数。训练过程可能包括多个epoch,每个epoch遍历整个训练数据集一次。

6. **评估与验证**:在验证集上定期评估模型性能,监控指标如F1分数、精确率、召回率等,以调整超参数并防止过拟合。

7. **测试**:最后,使用测试数据集评估模型在未见过的数据上的表现,确保泛化能力。

在微调过程中,可能需要调整的超参数包括学习率、批次大小、训练轮数等。此外,可以使用数据增强技术增加模型的泛化能力,或者采用分阶段训练策略,先训练模型的高层特征,再微调NER相关的层。

使用BERT预训练模型进行微调是NLP任务中一种常见的实践,它能够利用已有的语言知识高效地解决特定任务,如命名实体识别。通过适当地配置和调整,BERT模型可以有效地提升NER任务的性能。

2019-08-10 上传

2021-06-16 上传

2024-01-09 上传

2024-01-13 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

程序猿000001号

- 粉丝: 468

- 资源: 386

最新资源

- Chrome ESLint扩展:实时运行ESLint于网页脚本

- 基于 Webhook 的 redux 预处理器实现教程

- 探索国际CMS内容管理系统v1.1的新功能与应用

- 在Heroku上快速部署Directus平台的指南

- Folks Who Code官网:打造安全友好的开源环境

- React测试专用:上下文提供者组件实现指南

- RabbitMQ利用eLevelDB后端实现高效消息索引

- JavaScript双向对象引用的极简实现教程

- Bazel 0.18.1版本发布,Windows平台构建工具优化

- electron-notification-desktop:电子应用桌面通知解决方案

- 天津理工操作系统实验报告:进程与存储器管理

- 掌握webpack动态热模块替换的实现技巧

- 恶意软件ep_kaput: Etherpad插件系统破坏者

- Java实现Opus音频解码器jopus库的应用与介绍

- QString库:C语言中的高效动态字符串处理

- 微信小程序图像识别与AI功能实现源码