InfoSphere DataStage:确保数据传输的可靠性策略

107 浏览量

更新于2024-08-28

收藏 241KB PDF 举报

"使用InfoSphere DataStage执行有保障的传送"

InfoSphere DataStage是一款强大的ETL(Extract, Transform, Load)工具,它允许用户高效地从各种来源抽取数据,进行必要的转换,然后加载到目标系统中。对于那些需要确保数据在传输过程中不丢失的用户,DataStage提供了多种策略和组件来实现数据的有保障传送。

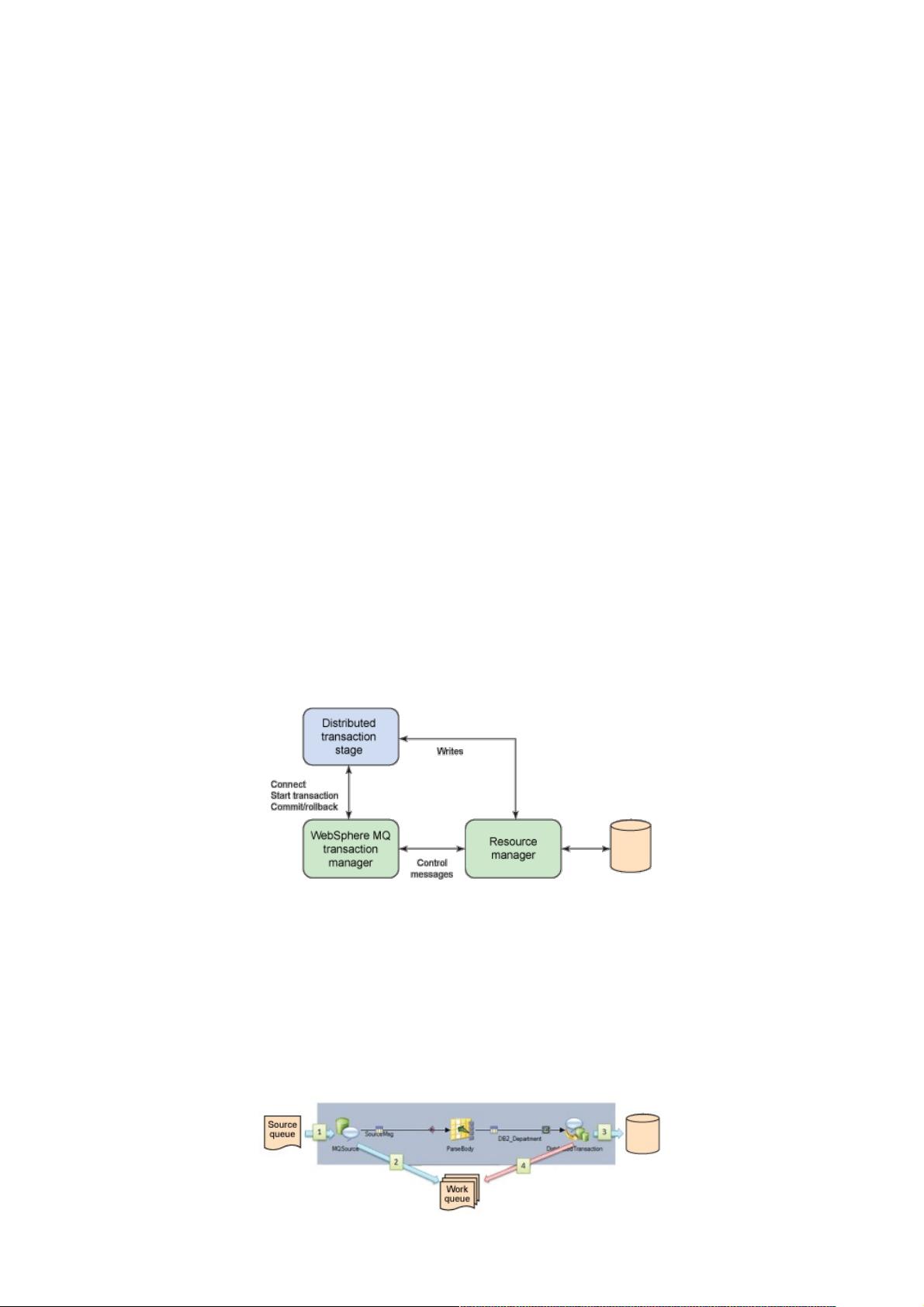

首先,Distributed Transaction Stage (DTS) 是DataStage中的一个重要组件,用于处理分布式XA事务。当需要在不同系统间协调事务时,DTS与事务管理器(如WebSphere MQ)协同工作,遵循X/Open Group的X/Open Architecture (XA) 标准。这个标准定义了如何在一个事务中跨多个资源进行操作,确保ACID(原子性、一致性、隔离性和持久性)属性得以维护。DTS参与2阶段提交协议,第一步是提交请求,事务管理器询问所有资源是否准备好提交,资源会反馈其状态;第二步是提交,只有在所有资源都反馈成功后,事务才会真正被提交。

其次,对于本地数据库事务,即便没有外部事务管理器,DataStage也能处理。这通常涉及到使用多个输入链接和单一数据库连接器在一个本地事务内执行一系列数据库操作,确保所有操作要么全部成功,要么全部回滚。

另外,InfoSphere DataReplication中的Change Data Capture Transaction阶段也可用于有保障的数据传送。这种情况下,DataStage捕获源系统的数据更改,然后在目标系统上应用这些更改,确保数据的一致性。

最后,结合使用消息队列和数据库阶段是提供高可靠性和容错性的最佳实践。例如,通过WebSphere MQ作为中间件,即使在系统间网络不稳定的情况下,也能确保数据的正确传输。消息队列负责缓存和重新传递消息,直到数据成功处理为止。

InfoSphere DataStage通过各种机制确保数据在ETL过程中的完整性。这些机制包括利用分布式事务处理、本地事务管理、变更数据捕获以及消息队列,为用户提供了多种方式来确保数据在复杂环境下的安全传输和准确加载。理解并熟练运用这些工具和技术,对于构建稳定、可靠的ETL流程至关重要。

2011-10-22 上传

2024-09-27 上传

2024-09-27 上传

2024-09-27 上传

2024-09-27 上传

2024-09-27 上传

2024-09-27 上传

weixin_38605133

- 粉丝: 3

- 资源: 916

最新资源

- 批量文件重命名神器:HaoZipRename使用技巧

- 简洁注册登录界面设计与代码实现

- 掌握Python字符串处理与正则表达式技巧

- YOLOv5模块改进 - C3与RFAConv融合增强空间特征

- 基于EasyX的C语言打字小游戏开发教程

- 前端项目作业资源包:完整可复现的开发经验分享

- 三菱PLC与组态王实现加热炉温度智能控制

- 使用Go语言通过Consul实现Prometheus监控服务自动注册

- 深入解析Python进程与线程的并发机制

- 小波神经网络均衡算法:MATLAB仿真及信道模型对比

- PHP 8.3 中文版官方手册(CHM格式)

- SSM框架+Layuimini的酒店管理系统开发教程

- 基于SpringBoot和Vue的招聘平台完整设计与实现教程

- 移动商品推荐系统:APP设计与实现

- JAVA代码生成器:一站式后台系统快速搭建解决方案

- JSP驾校预约管理系统设计与SSM框架结合案例解析