轻量级深度学习推理框架:性能优化与高效算法揭秘

需积分: 50 37 浏览量

更新于2024-07-18

2

收藏 11.4MB PDF 举报

本文档主要探讨了"轻量级深度学习推理框架"的概念及其在嵌入式端侧部署中的应用。轻量级深度学习推理框架旨在优化在资源有限的设备上运行的深度学习模型,以实现高效性能。以下是一些关键知识点:

1. **性能优化与部署策略**:

- 嵌入式AI性能优化是该框架的核心关注点,通过精细的算法调整和硬件利用,提高计算效率。

- 框架针对特定平台设计,如嵌入式设备,注重在有限的内存和处理能力下提升推理速度。

2. **卷积操作优化**:

- 文档提及了一些优化技术,如Thegemmalgorithm,它可能涉及卷积核(innerkernel)的设计,通过块-面板乘法和三个循环结构来减少计算复杂度。

- 这些算法可能涉及到像PackrowpanelofB和PackblockofA这样的低级别操作,通过数据重排或并行化来提高性能。

3. **专用优化库**:

- PerfBLAS针对深度学习进行了专门的优化,这是一个底层的高性能数学库,针对矩阵运算进行定制,以适应深度学习模型中的大量线性变换。

4. **代码实现**:

- Thegemmalgorithm被编码在汇编语言中,这表明作者对硬件底层的理解和对性能提升的追求。大约2000行的汇编代码显示出其对细节的把控。

5. **部署与效率指标**:

- 提到了诸如NC、KC、MR、NR等缩写,可能是特定硬件配置或性能指标,用于评估不同阶段的执行效率。

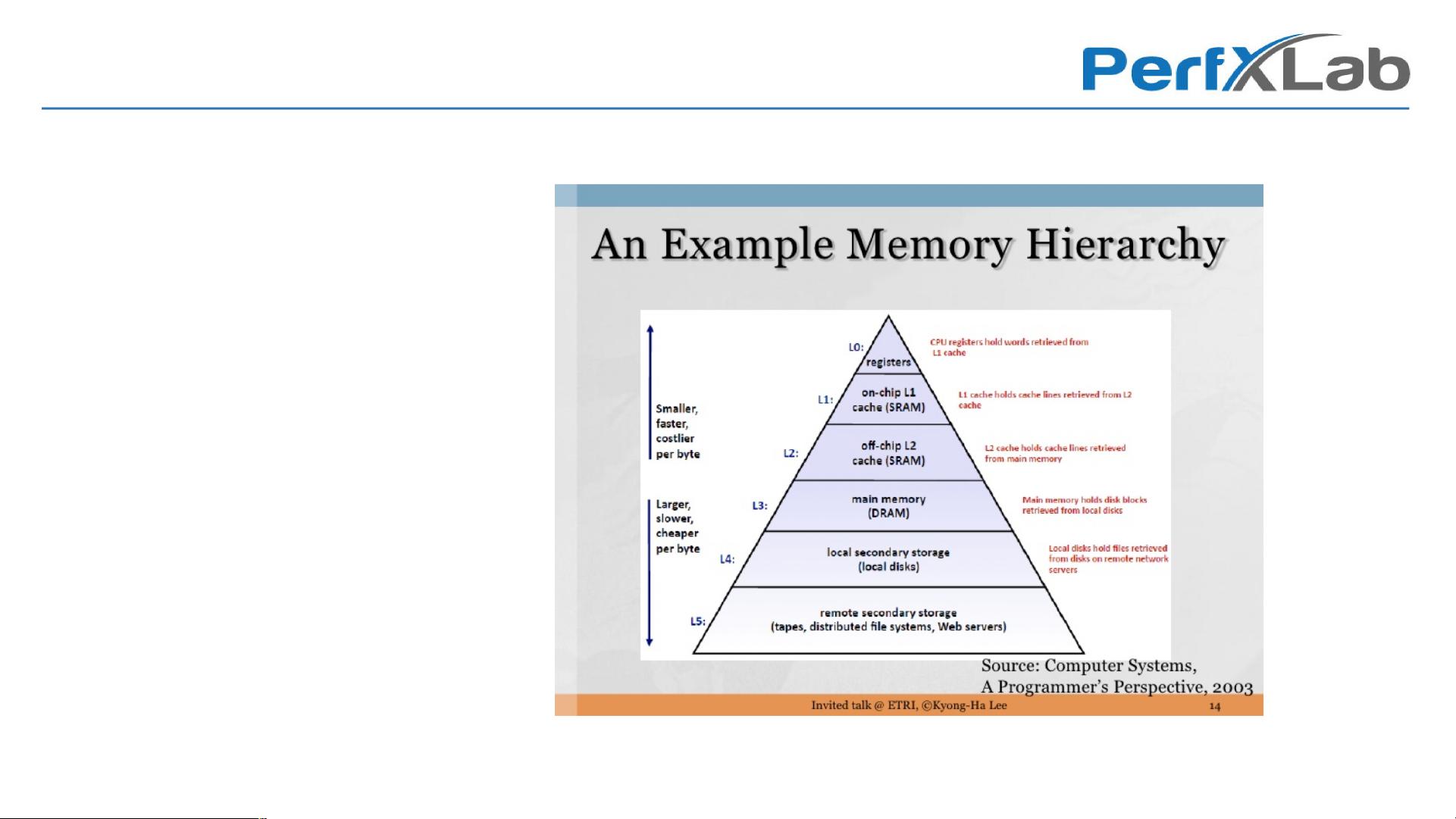

6. **资源管理和利用**:

- 充分利用局部性原则,通过合理的数据布局和缓存策略来减少内存访问时间和提高运算速度。

7. **硬件兼容性和扩展性**:

- 框架可能支持不同的硬件平台,如L.%NI和G0%N* 等,强调了跨设备的通用性和灵活性。

本文档深入探讨了轻量级深度学习推理框架如何通过优化算法、硬件利用和专用库来提升嵌入式设备上的深度学习推理性能。对于开发者来说,这是一个在资源受限环境中实现高效AI应用的重要工具。

2021-03-19 上传

2021-05-27 上传

2021-05-25 上传

2019-08-09 上传

2022-05-29 上传

2024-02-21 上传

2024-02-05 上传

2023-11-10 上传

2021-02-03 上传

打怪升级ing

- 粉丝: 2756

- 资源: 20

最新资源

- Aspose资源包:转PDF无水印学习工具

- Go语言控制台输入输出操作教程

- 红外遥控报警器原理及应用详解下载

- 控制卷筒纸侧面位置的先进装置技术解析

- 易语言加解密例程源码详解与实践

- SpringMVC客户管理系统:Hibernate与Bootstrap集成实践

- 深入理解JavaScript Set与WeakSet的使用

- 深入解析接收存储及发送装置的广播技术方法

- zyString模块1.0源码公开-易语言编程利器

- Android记分板UI设计:SimpleScoreboard的简洁与高效

- 量子网格列设置存储组件:开源解决方案

- 全面技术源码合集:CcVita Php Check v1.1

- 中军创易语言抢购软件:付款功能解析

- Python手动实现图像滤波教程

- MATLAB源代码实现基于DFT的量子传输分析

- 开源程序Hukoch.exe:简化食谱管理与导入功能