人工神经网络基础与历史

需积分: 3 49 浏览量

更新于2024-07-29

收藏 11.69MB DOC 举报

"人工神经网络导论"

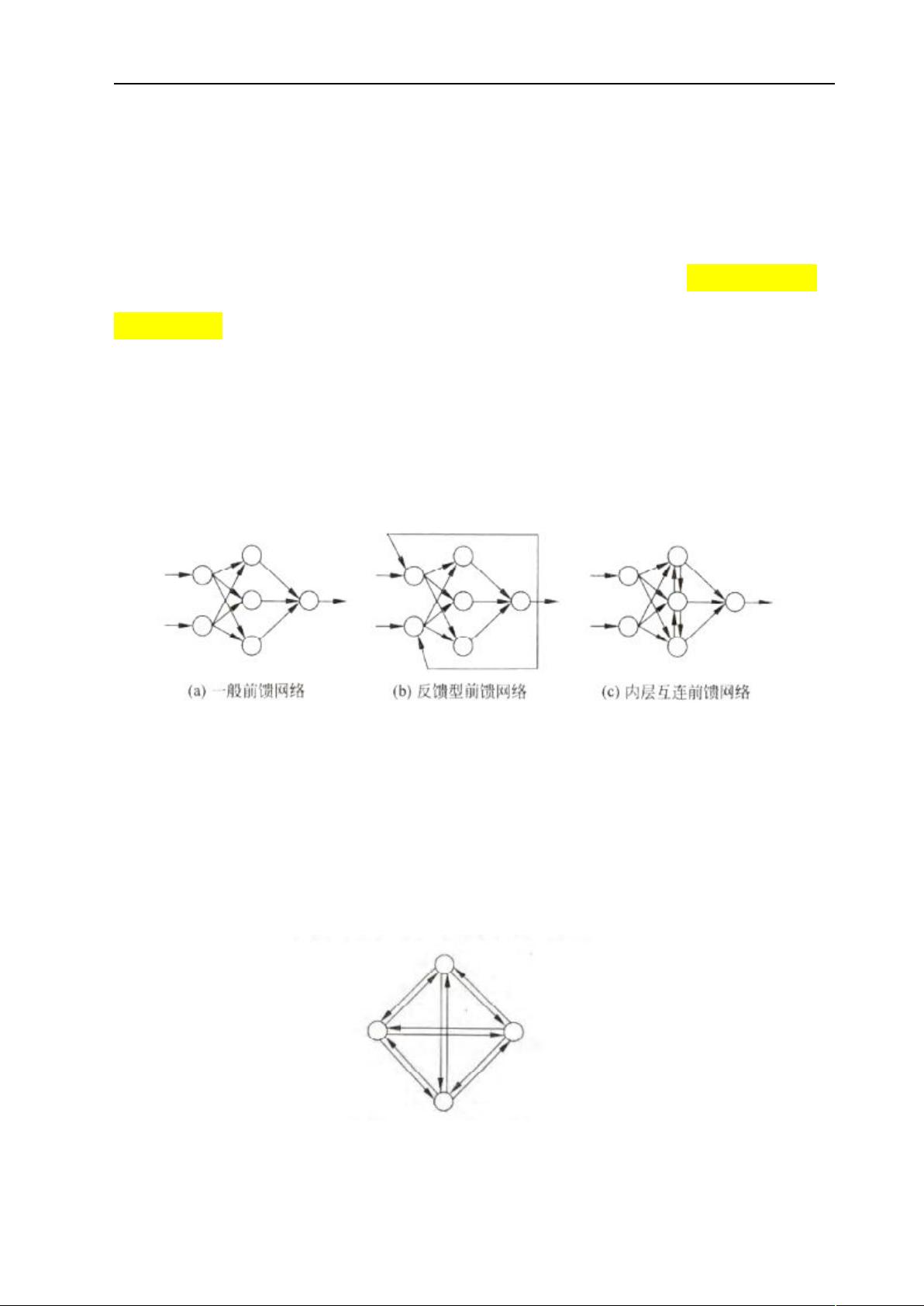

人工神经网络(ANN)是一种受到生物神经元结构启发的计算模型,它试图模仿大脑中神经元之间的交互来解决复杂问题。该领域的研究始于20世纪40年代,由心理学家W. McCulloch和数学家W. Pitts提出的MP模型奠定了基础,该模型将神经元简化为数学函数,描述了它们如何通过逻辑运算处理信息。

在1950年代末,F. Rosenblatt的感知器模型引入了学习和分类的能力,这使得神经网络的概念更加具体化。感知器由简单的神经元组成,能够进行基本的模式识别任务。随后,B. Widrow和M. Hoff的ADALINE(自适应线性元件)网络进一步发展了学习算法,采用LMS(最小均方误差)规则,提高了网络的适应性和准确性,标志着神经网络研究的第一个高峰。

然而,M. Minsky和S. Papert在1969年的《Perceptron》一书中指出单层感知器的局限性,认为多层网络的训练问题尚未解决,导致了神经网络研究的低潮。直到1970年代,随着T. Kohonen的自组织映射(Self-Organizing Maps, SOM)和J. Anderson的联想记忆模型的出现,神经网络的研究逐渐恢复活力。

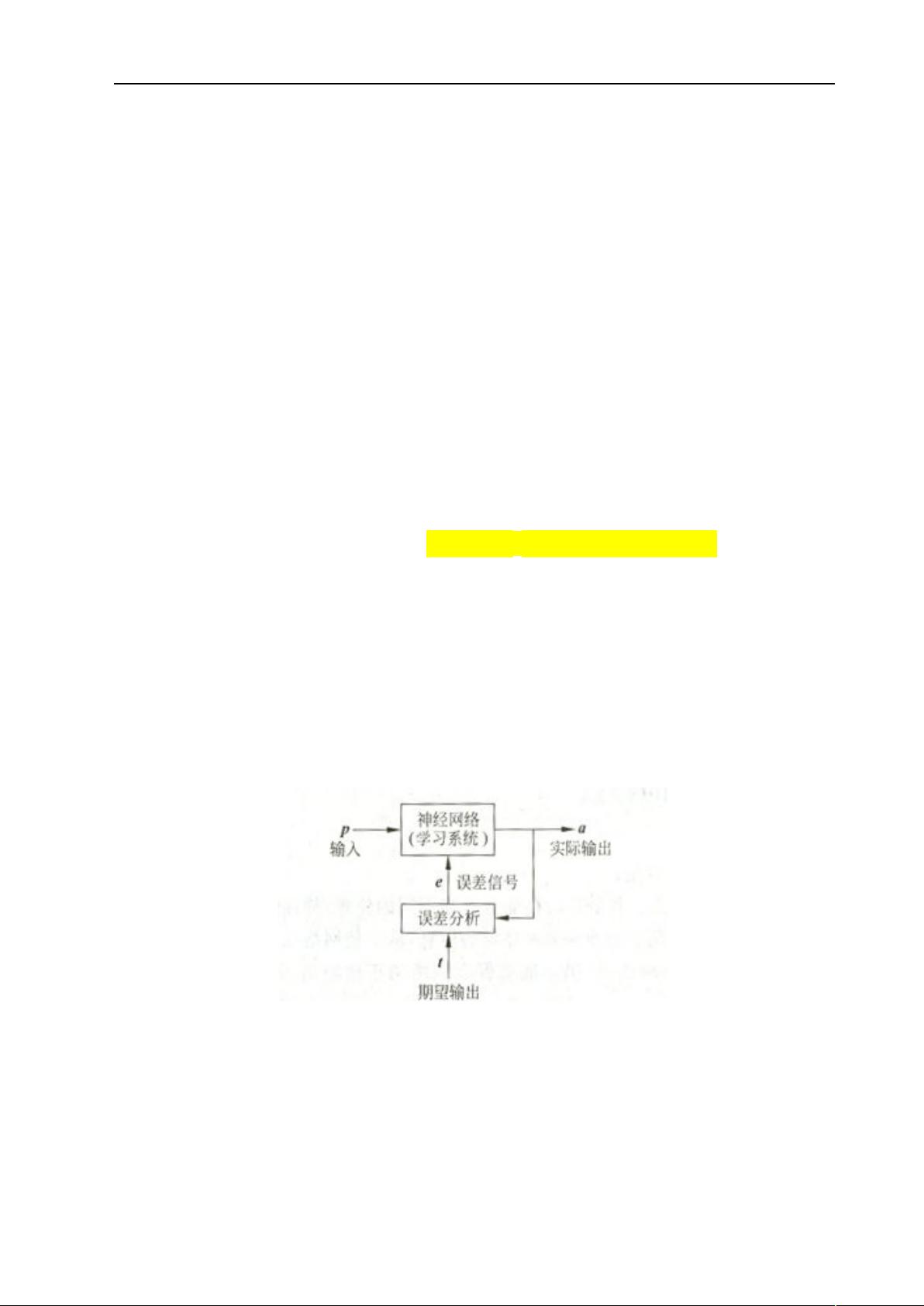

进入1980年代,反向传播(Backpropagation, BP)算法的提出解决了多层神经网络的训练难题,这成为现代神经网络的基石。BP算法允许通过梯度下降法优化权重,极大地扩展了神经网络的应用范围,包括图像识别、语音处理和自然语言处理等领域。

1990年代至21世纪初,随着计算能力的增强和大数据的出现,神经网络迎来了深度学习的时代。深度神经网络(Deep Neural Networks, DNN)拥有多个隐藏层,能学习到更为抽象的特征,显著提升了模型的性能。近年来,卷积神经网络(Convolutional Neural Networks, CNN)在图像处理中表现出色,循环神经网络(Recurrent Neural Networks, RNN)则在序列数据处理如自然语言处理中占据重要地位。

此外,变分自编码器(Variational Autoencoders, VAE)和生成对抗网络(Generative Adversarial Networks, GAN)等新型神经网络架构进一步推动了人工智能的创新,不仅在图像生成、文本生成等方面取得突破,也在强化学习、推荐系统和药物发现等领域得到应用。

人工神经网络从最初的理论构想到现在的广泛应用,历经了数十年的探索和发展。随着计算资源的不断增长和理论的深入理解,神经网络将继续在解决现实世界复杂问题中扮演关键角色。

134 浏览量

2022-07-01 上传

308 浏览量

2022-06-17 上传

Physlow

- 粉丝: 1

最新资源

- 网狐工具:核心DLL和程序文件解析

- PortfolioCVphp - 展示JavaScript技能的个人作品集

- 手机归属地查询网站完整项目:HTML+PHP源码及数据集

- 昆仑通态MCGS通用版S7400父设备驱动包下载

- 手机QQ登录工具的压缩包内容解析

- Git基础学习仓库:掌握版本控制要点

- 3322动态域名更新器使用教程与下载

- iOS源码开发:温度转换应用简易教程

- 定制化用户登录页面模板设计指南

- SMAC电机在包装生产线应用的技术案例分析

- Silverlight 5实现COM组件调用无需OOB技术

- C#实现多功能画图板:画直线、矩形、圆等

- 深入探讨C#语言在WPF项目开发中的应用

- 新版2012109通用权限系统源码发布:多角色用户支持

- 计算机科学与工程系网站开发技术源码合集

- Java实现简易导出Excel工具的开发教程