RNN与LSTM详解:深入解析循环神经网络

"深入理解RNN和LSTM的教程,由任飞亮整理,主要来源于多个在线平台的优质内容,旨在帮助深度学习研究者了解RNN和LSTM的基础知识,仅供学术交流,非商用。教程涵盖了RNNs的介绍,包括它们在NLP中的应用,以及如何处理序列数据,强调了RNNs区别于传统FNNs的定向循环结构。"

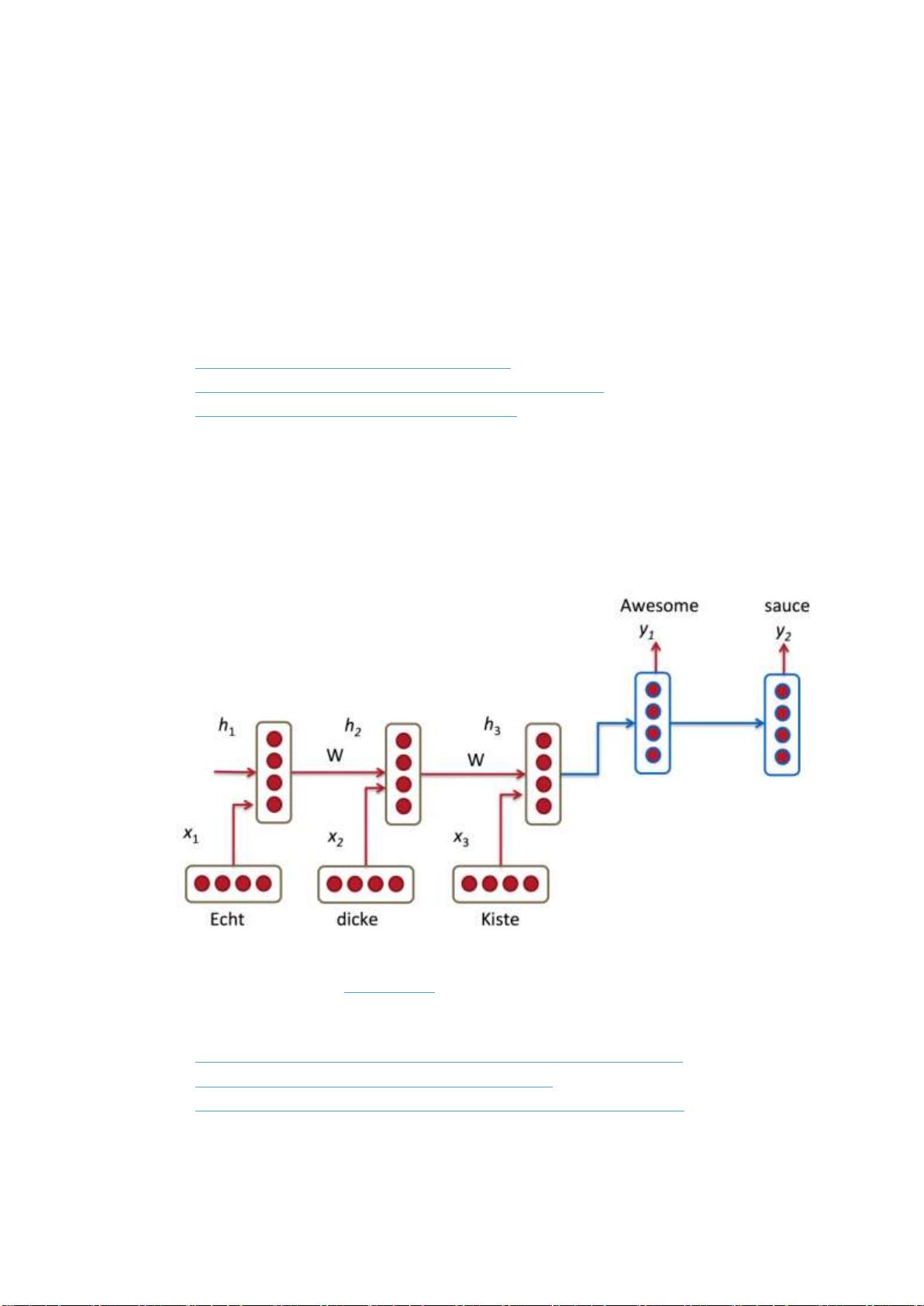

在深入理解RNN(循环神经网络)和LSTM(长短期记忆网络)之前,我们需要先了解RNN的基本概念。RNNs是专门设计用来处理序列数据的神经网络模型,因为它们能够捕捉输入序列中的时间依赖性。传统的前向神经网络(FNNs)在处理具有时间顺序的数据时存在局限,而RNNs通过引入循环结构,使得网络的隐藏状态可以在每个时间步中传递信息,从而记住之前的上下文。

1.1 RNNs的核心特征

RNNs的关键在于其循环结构,这使得同一个神经网络单元可以对时间序列上的不同位置进行运算。在RNN中,每个时间步的输入不仅依赖于当前的输入,还依赖于上一时间步的隐藏状态。这种设计使得RNN有能力处理变长的序列数据,并且在预测序列的下一个元素时,可以利用前面的上下文信息。

1.2 RNNs的问题:梯度消失和梯度爆炸

尽管RNNs理论上能够捕获长期依赖,但在实际应用中,由于反向传播过程中的梯度消失或梯度爆炸问题,它们往往难以学习到长期的依赖关系。这限制了RNN在处理长序列时的表现。

1.3 LSTM的引入

为了解决RNNs的长期依赖问题,LSTM应运而生。LSTM是一种特殊的RNN变体,它引入了“门”机制,包括输入门、遗忘门和输出门,以及称为细胞状态的额外存储单元。这些门控制信息如何进入、保留和离开单元,有效地解决了梯度消失问题,增强了网络的记忆能力。

1.4 LSTM的结构

- 输入门(Input Gate):控制新信息流入细胞状态的速率。

- 遗忘门(Forget Gate):决定哪些旧的细胞状态信息应该被丢弃。

- 细胞状态(Cell State):作为长期存储,允许信息在多个时间步中流动而不受梯度消失的影响。

- 输出门(Output Gate):决定细胞状态中的哪些信息应该传递到隐藏状态,进而影响当前时间步的输出。

通过这些门的控制,LSTM能够选择性地记住或遗忘信息,使其在处理长序列时表现更优。

2. GRU(门控循环单元)是另一种解决RNN梯度消失问题的方法,它的结构比LSTM简化,但仍然能够有效地学习长期依赖。GRU结合了输入门和遗忘门的功能,通过重置门和更新门来控制信息的流动。

总结,本教程旨在为读者提供RNN和LSTM的详细理解,包括它们的工作原理、优势和存在的问题,以及如何在实际应用中解决这些问题。通过学习,读者将能够掌握如何使用RNNs和LSTM进行序列数据的建模和预测,为NLP和其他相关领域的任务提供强大的工具。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2024-05-22 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

涯若

- 粉丝: 57

- 资源: 13

最新资源

- S7_PLCSIM_V54_SP3.rar

- 背包清单:我冒险中的背包装备清单

- quartz-boiler:Quartz Spring集成样板代码

- RestAssured_RahulShetty:udemy API自动化测试教程中的所有程序

- electronjs-todo-app:用ElectronJS制作的简单待办事项应用

- .dotfiles

- Pixelreka! -使用TogetherJS JavaScript库进行实时游戏

- MaxKMeans:解决k-means问题的算法

- Python库 | funkload-1.4.1-py2.4.egg

- 塞尔达测验应用

- future-robotics:未来机器人燃烧人营创建的项目集合

- moulalehero

- eslint-config-tron:具有TypeScript,Hooks和Prettier支持的Tron的ESLint配置

- Sluglords-Of-Thras(萨卢格洛德·斯格拉格斯):萨洛斯之怒(Glroy to Thras)和伟大的失落者

- 易语言绝地求生全套加速器源码

- gemini_bot_list:我尝试列出双子星机器人和代理的IP地址的github回购。 在Github上,可能比在Codeberg上能贡献更多的人