2015年CUDA统一内存与GPGPU高性能计算技术概览

PDF格式 | 10.83MB |

更新于2024-07-13

| 125 浏览量 | 举报

在2015年的GPGPU高性能计算研讨会上,Manuel Ujaldón教授介绍了CUDA统一内存技术,这是NVIDIA在GPU架构中的一项关键创新。该研讨会由南非开普敦大学主办,主题是"统一内存在GPGPU中的应用",旨在探讨如何利用CUDA进行高效并行计算。

讲座分为四个部分:1)技术现状(12张幻灯片),2)统一内存编程(4张幻灯片),3)实际案例研究(8张幻灯片),以及4)总结与结论(4张幻灯片)。在技术现状部分,Ujaldón教授提到了一款2015年的图形处理器,它采用的是Kepler/Maxwell架构,带有GDDR5内存,这展示了当时GPU内存性能的里程碑。GDDR5内存提供了更快的数据传输速度,对于大规模并行计算任务至关重要。

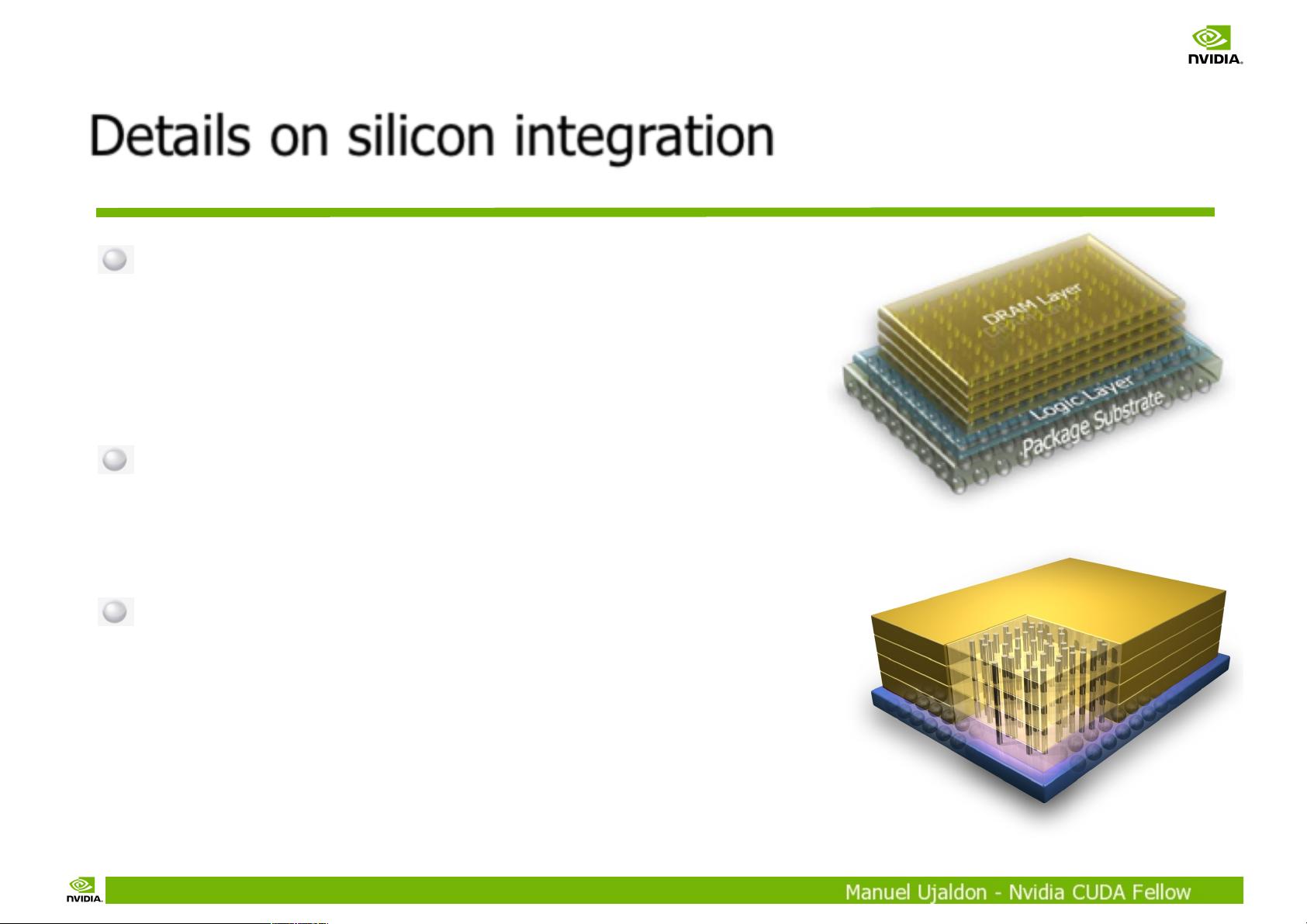

随后,在2017年的图形卡中,NVIDIA引入了Pascal架构,这一代产品引入了3D堆叠DRAM技术(SXM2.0标准),即通过将多个DRAM层垂直堆叠来增加内存带宽和容量。这种设计采用了DRAM芯片中的交错内存阵列,逻辑控制器位于DRAM层底部,数据矩阵位于顶部,通过贯穿硅的微通道(TSV)连接各个层,实现每20层仅12皮秒的垂直延迟,显著提高了存储器的性能密度。

Pascal GPU的SXM2.0封装形式(非最终命名)进一步提升了GPU的散热效率和扩展性,其尺寸达到了140mm x 78mm。这些改进不仅体现在硬件层面,也影响了软件开发者对统一内存的利用,使得程序可以更有效地共享内存空间,从而提高整体计算性能。

统一内存技术的关键在于允许CPU和GPU共享同一块物理内存,消除了传统上GPU内存与主存之间的数据拷贝开销。这对于处理大量数据密集型任务,如机器学习、深度学习、科学计算等场景,具有显著的优势。通过编程接口,开发者可以充分利用这一点,优化内存访问模式,提升计算性能。

Ujaldón教授的讲座展示了CUDA统一内存技术如何推动GPGPU计算的演进,以及它如何通过硬件升级和编程模型的优化,实现了更高的计算效能和更低的延迟,为现代高性能计算提供了强大的支持。理解并掌握统一内存技术是现代GPU程序员和研究人员必备的技能。

相关推荐

16 浏览量

weixin_38571544

- 粉丝: 3

最新资源

- 五笔学习必备:打字通2002精简版功能介绍

- 2019年实习指南:掌握Git操作与代码提交

- threadpool 1.1版本发布,修复bug,优化通用框架支持

- 深入解析Android Intent与Intent-Filters机制

- Vista Aero窗体技术解析与应用

- 网上书店关系数据库设计与系统分析

- 英展电子秤数据采集程序详解

- phpMyAdmin: Web-Based MySQL数据库管理工具

- JUDE专业版许可证使用指南

- 使用Servlet/JSP开发全注解员工管理系统

- erwin7.2.5注册机下载 - 生成CA产品全系列注册码

- LED显示代码查询工具:自定义与标准接法段码快速查询

- 深入解析Android Intent与Intent-Filters机制

- 探索cosmecodeSite背后的HTML技术

- Android PDF生成教程:100多种PDF样式的实现

- Android SlidingPaneLayout 实现新版QQ侧滑效果