BootMAE:提升视觉BERT预训练的自举掩蔽自编码器

91 浏览量

更新于2024-06-19

收藏 868KB PDF 举报

"自举掩蔽自编码器:视觉BERT预训练方法改进"

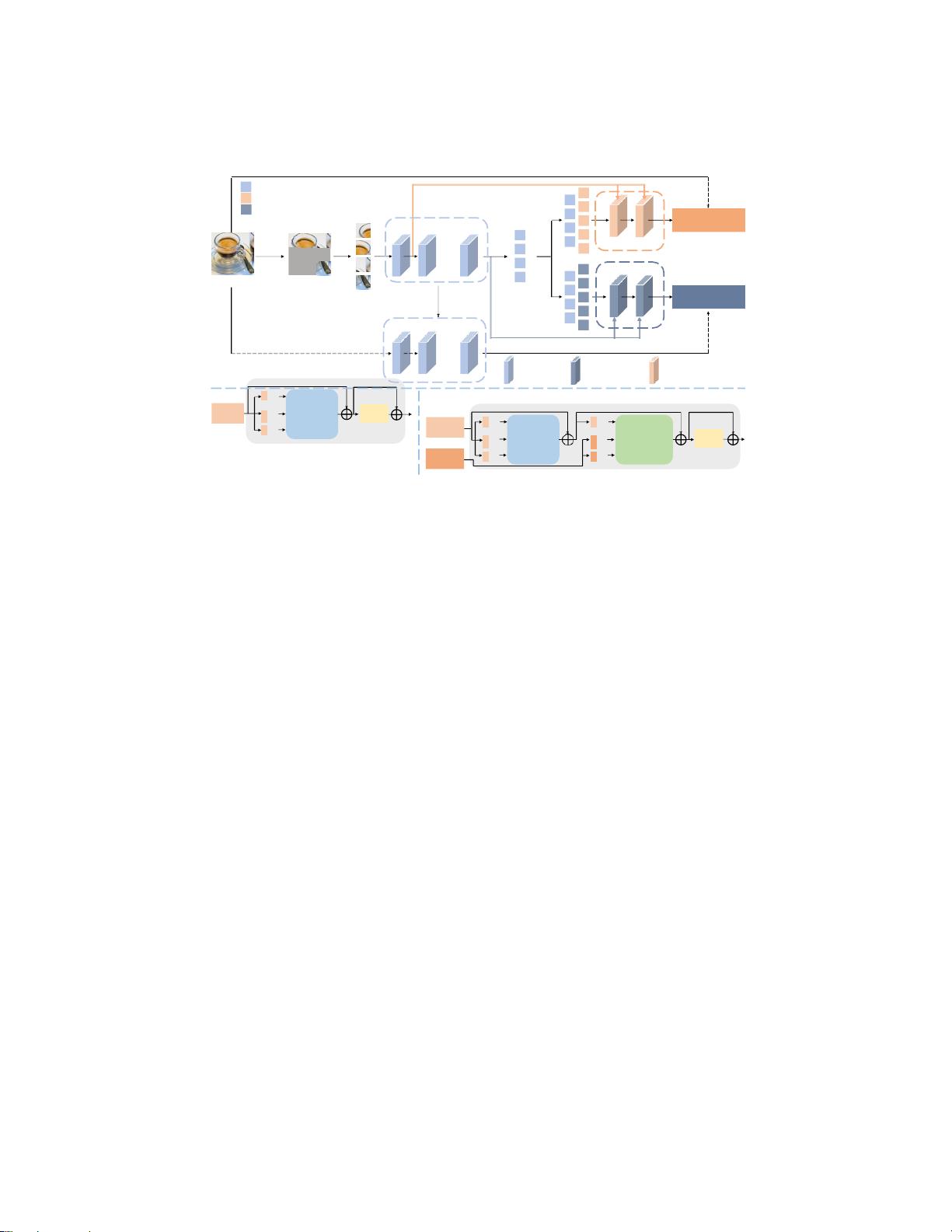

本文提出了一种新的视觉BERT预训练方法——自举掩蔽自编码器(BootMAE),它针对原始的掩码自编码器(MAE)进行了两项关键改进,以优化视觉Transformer模型的预训练效果。视觉BERT预训练的主要目标是学习能够捕捉图像语义信息的表示,这在后续的下游任务如图像分类、语义分割和目标检测中至关重要。

首先,BootMAE引入了动量编码器(Momentum Encoder)。这个设计是基于一个观察,即使用预训练的MAE提取的特征作为BERT预测目标能提高预训练性能。动量编码器与原始的MAE编码器并行运行,通过持续更新其表示并将其用作预测目标,进一步增强模型的学习能力。

其次,为了减轻编码器在记忆目标特定信息上的负担,BootMAE采用了目标感知解码器(Target-Aware Decoder)。在传统的MAE中,编码器可能需要存储未掩蔽区域的信息,这可能会分散其对语义建模的注意力。目标感知解码器则直接将这些目标特定信息(如未掩蔽像素的值)传递给解码器,使得编码器可以更加专注于捕获图像的全局语义,而无需保留细节信息。

实验证明,BootMAE在多个视觉任务上都表现出了显著的提升。使用ViT-B作为基础架构,在ImageNet-1K图像分类任务上,BootMAE的Top-1准确率比MAE提高了2%。在ADE20K语义分割任务上,BootMAE实现了+1.0 mIoU的提升,而在COCO数据集的目标检测和分割任务中,分别提高了1.3 box AP和1.4 mask AP。

自监督学习是机器学习领域的一个重要研究方向,尤其是对于视觉Transformer模型,预训练阶段的表现直接影响到模型在无标注数据上的学习效果和在各种下游任务中的应用性能。BootMAE通过巧妙的机制优化了这一过程,展示了其在提升模型泛化能力和学习效率方面的潜力。此研究的代码已经开源,可供研究人员和开发者进一步探索和使用。

281 浏览量

8431 浏览量

215 浏览量

2024-11-05 上传

2024-11-05 上传

2024-11-05 上传

254 浏览量

137 浏览量

109 浏览量

cpongm

- 粉丝: 5

最新资源

- Java编码规范详解:提升代码质量

- Struts实战指南:构建高效Web应用

- 技术管理20年:从启蒙到感悟

- 串口通信实验:理解MFC下的Windows串口编程

- C++编程基础与学习笔记

- 嵌入式Linux开发全攻略:从入门到精通

- 互联网搜索引擎:工作原理与系统构建深度解析

- iBATIS SQL Maps开发详解:快速上手与优化策略

- Spring源代码深度解析:IoC容器与关键模块详解

- 24小时速成Visual C# 2008编程全指南

- 精通Symbian OS C++智能手机开发实战指南

- Windows CE编程疑难解答与资源分享

- DataGuard学习教程:从基础到高级

- 三层楼企业网络组建:VLAN划分与通信实现

- 安全入门:挑选示波器测试探头的全面指南

- 贪婪算法与最优化问题:从货箱装船到最短路径