优化技巧:BERT微调的Epoch、BatchSize与LearningRate调整

192 浏览量

更新于2024-08-30

1

收藏 353KB PDF 举报

"这篇文章除了回顾BERT的原理、应用和与其他预训练模型的比较,还重点关注了在实际项目中BERT模型的调参技巧,特别是针对2019BDCI互联网金融新实体发现任务的实践案例。作者提供了相关的GitHub代码链接,以帮助读者深入理解BERT模型的优化过程。文章探讨了三个关键参数:Epoch、BatchSize和LearningRate,并给出了具体的调整建议。"

详细说明:

1. **Epoch**

Epoch是指模型在完整数据集上进行的完整训练次数。在训练BERT模型时,合适的Epoch数量取决于模型是否能收敛到一个稳定的损失值。通常,BERT的微调Epoch范围是2到4。观察损失函数的变化是确定最佳Epoch数的关键。

2. **BatchSize**

BatchSize决定了每次更新模型参数时所使用的样本数量。在调优过程中,应考虑GPU的利用率。较大的BatchSize可能导致更高的GPU利用率,但过大会影响内存效率。BERT模型由于其复杂性,通常BatchSize不会设置得很大,应尽量使其填满GPU内存,但不超过其容量。有观点认为使用2的幂次可能会提高性能,这可以作为进一步的实验方向。

3. **LearningRate**

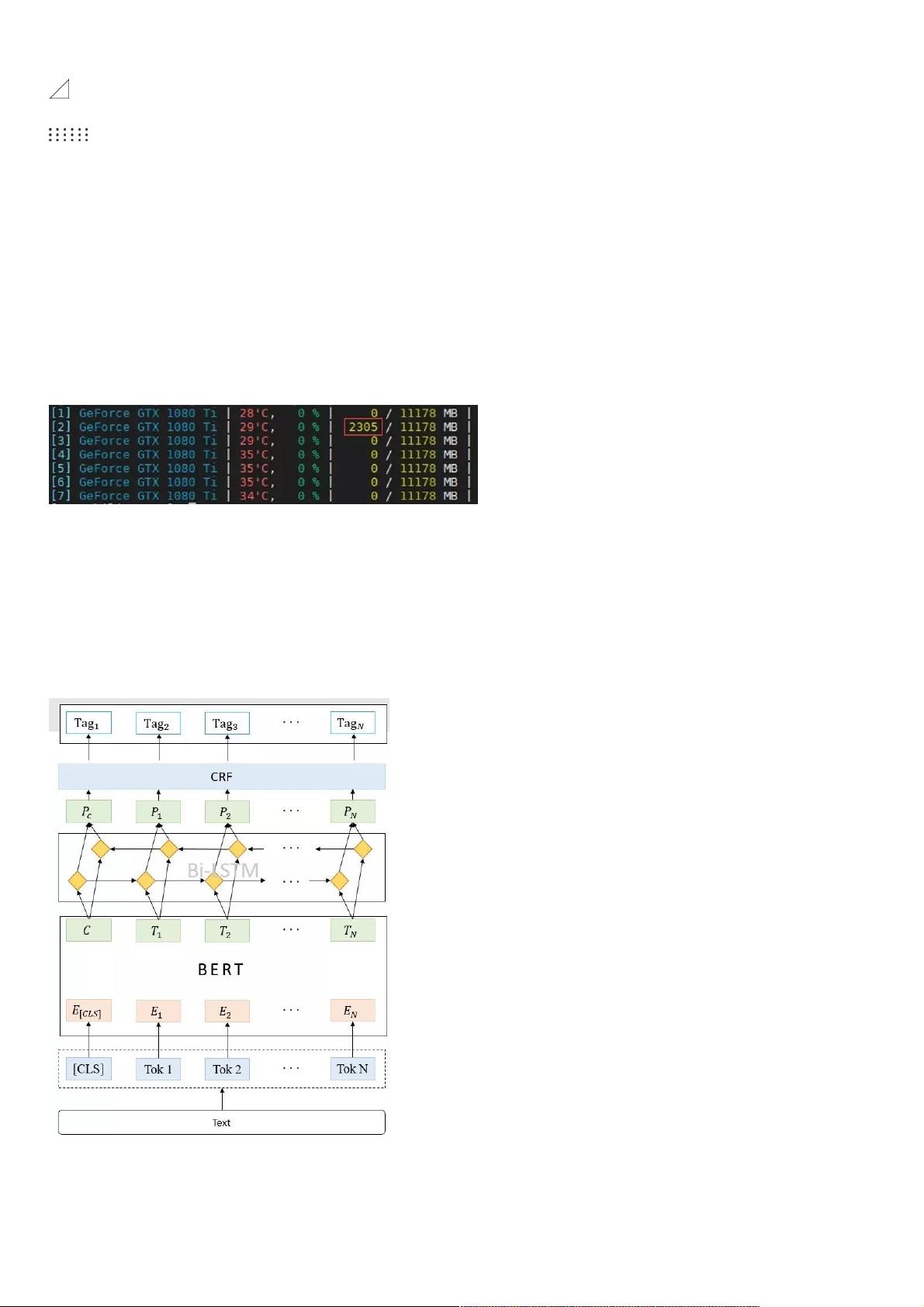

LearningRate控制模型参数更新的速度。BERT原始论文建议的LearningRate范围是[5e-5, 3e-5, 2e-5]。当添加下接结构,如在NER任务中的BERT+BiLSTM+CRF模型,需要为不同的部分设置不同的LearningRate。BERT的微调LearningRate应保持在推荐范围内,因为其权重已经在预训练阶段得到优化。而BiLSTM和CRF等下接结构由于是从零开始训练,所以可以使用较大的LearningRate,如1e-4,以便更快地探索参数空间。

在实际应用中,这些参数的选择并非固定不变,而是需要根据具体任务、数据量和计算资源进行调整。例如,更大的数据集可能需要更多的Epoch,更复杂的模型可能需要更小的BatchSize以避免过拟合,而不同的任务可能对LearningRate有不同的敏感性。因此,调参是一个迭代的过程,通常需要通过交叉验证和网格搜索等方法找到最佳参数组合。

2021-01-06 上传

2022-02-15 上传

2022-05-12 上传

2022-03-01 上传

2022-05-12 上传

2022-04-06 上传

2022-01-09 上传

2022-05-12 上传

2022-01-31 上传

weixin_38536397

- 粉丝: 7

- 资源: 961

最新资源

- 正整数数组验证库:确保值符合正整数规则

- 系统移植工具集:镜像、工具链及其他必备软件包

- 掌握JavaScript加密技术:客户端加密核心要点

- AWS环境下Java应用的构建与优化指南

- Grav插件动态调整上传图像大小提高性能

- InversifyJS示例应用:演示OOP与依赖注入

- Laravel与Workerman构建PHP WebSocket即时通讯解决方案

- 前端开发利器:SPRjs快速粘合JavaScript文件脚本

- Windows平台RNNoise演示及编译方法说明

- GitHub Action实现站点自动化部署到网格环境

- Delphi实现磁盘容量检测与柱状图展示

- 亲测可用的简易微信抽奖小程序源码分享

- 如何利用JD抢单助手提升秒杀成功率

- 快速部署WordPress:使用Docker和generator-docker-wordpress

- 探索多功能计算器:日志记录与数据转换能力

- WearableSensing: 使用Java连接Zephyr Bioharness数据到服务器