离线安装指南:CDH5.14.x on Centos7.4(含Spark2和Kafka)

需积分: 50 59 浏览量

更新于2024-07-14

收藏 9.68MB DOC 举报

"CDH5.14安装文档包含在Centos7.4上离线安装CDH5.14.x的步骤,以及Spark2和Kafka的安装指南。提供了所有必要的软件下载链接,包括JDK、MySQL驱动、Cloudera Manager安装包、CDH parcel及相关校验文件,以及角色分配的参考链接。"

CDH(Cloudera Distribution Including Apache Hadoop)是Cloudera公司提供的一个开源大数据平台,包含了多种大数据处理组件,如Hadoop、HBase、Hive等。在这个安装文档中,主要关注的是CDH5.14版本,这是一个支持Spark2和Kafka的发行版。

首先,安装CDH5.14.x前需要准备的软件有:

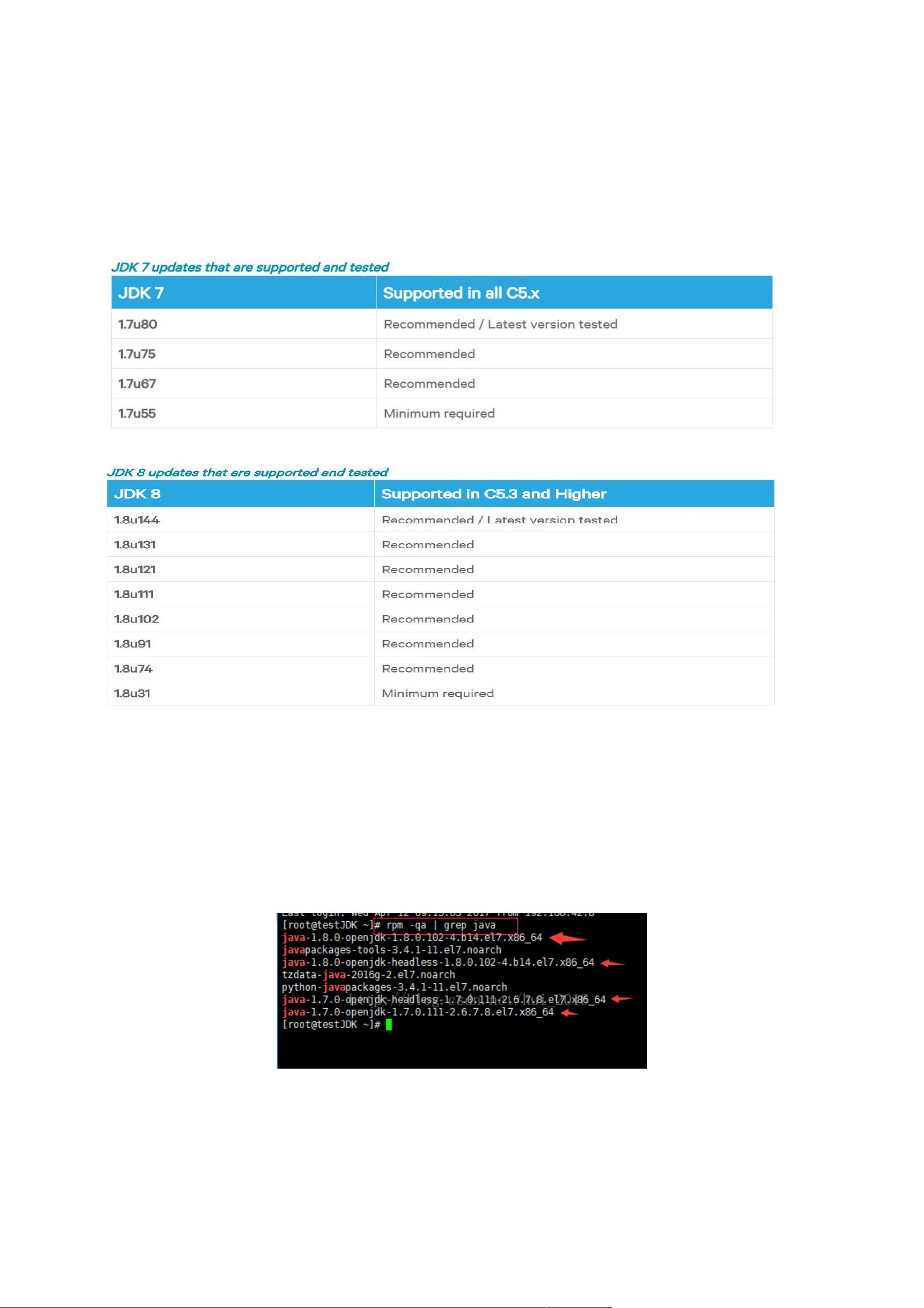

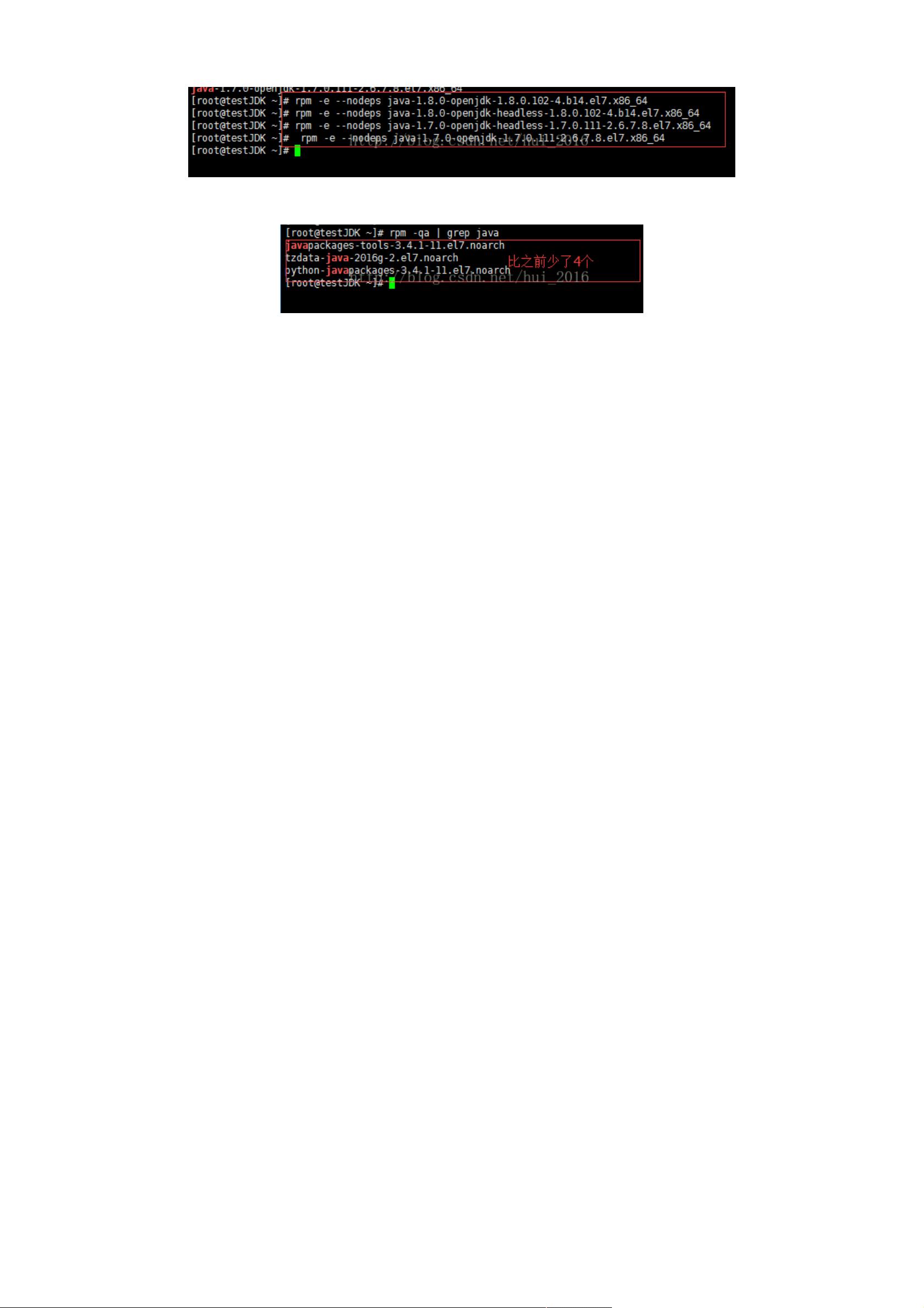

1. JDK 8u144 的Linux x64版本,这是运行CDH组件的基础,因为许多组件依赖于Java运行环境。

2. MySQL Connector/J,这是一个驱动包,用于Java应用程序连接到MySQL数据库,可能在CDH中用于配置元数据存储。

3. Cloudera Manager安装包,这是管理CDH集群的核心工具,提供监控、配置和部署等功能。

4. CDH5.14.4的parcel文件,这是CDH的二进制分发形式,用于在集群中安装和管理组件。

5. SHA1校验文件,用于验证下载的parcel文件完整性。

6. Manifest文件,包含了parcel的元数据信息。

在安装过程中,需要注意操作系统版本的匹配,比如这里要求是CentOS7.4,因此下载的parcel必须是对应el7的版本。错误的版本会导致安装失败。

角色分配对于CDH集群的高效运行至关重要。在这个场景中,推荐的分配方案可能包括以下角色:

- Cloudera Manager Server:通常部署在一个单独的节点上,负责集群的管理和监控。

- DataNode:存储HDFS数据的节点。

- NodeManager:YARN框架中处理应用任务的节点。

- TaskTracker:Hadoop MapReduce1中的任务调度和执行组件,但在CDH5中已被YARN取代。

- JobTracker:Hadoop MapReduce1中的作业调度和资源管理组件,已被ResourceManager取代。

- HBase RegionServer:HBase数据存储和服务的节点。

- HiveServer2:处理Hive查询的服务器。

- Spark Worker:Spark计算任务的执行者。

- Kafka Broker:Kafka消息队列的服务节点。

根据官方文档和博客文章的建议,可以创建4台虚拟机来模拟这个环境,每台虚拟机的配置如:

- cdh-cm:2核3G,作为Cloudera Manager Server。

- 其他三台作为工作节点,具体角色分配可以根据实际需求进行。

安装流程通常包括以下几个步骤:

1. 安装JDK并配置环境变量。

2. 安装Cloudera Manager Server,并在各节点上安装Agent。

3. 下载并上传CDH parcel到Cloudera Manager,进行 parcels的分布和激活。

4. 配置和启动相关服务,如HDFS、YARN、HBase和Spark。

5. 部署和配置Kafka,包括创建主题、设置副本和分区等。

6. 根据业务需求调整和优化集群参数。

安装完成后,通过Cloudera Manager界面可以进行监控、维护和升级操作,确保整个CDH集群的稳定和高效运行。同时,对于Spark2和Kafka的使用,还需要进一步学习它们的API、配置选项以及最佳实践,以便更好地利用这些组件处理大数据任务。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2019-11-28 上传

2019-03-22 上传

2019-04-18 上传

2019-05-26 上传

2024-07-14 上传

没有合适的昵称

- 粉丝: 146

- 资源: 2

最新资源

- Dcd_Analysis

- half:C ++库用于半精度浮点运算。-开源

- Windows版YOLOv4目标检测:原理与源码解析

- am-ripper:转换为WAV(回送记录)

- Package tracker-crx插件

- fiches_med

- scieng:scieng 是一个用 Java 编写的机器学习框架

- 翻译工具 Crow Translate 2.8.1 x64 中.zip

- 你好,世界

- sonarqube

- boot-microservices:Spring Boot 示例项目

- 网购淘实惠 - 神价屋-crx插件

- -Feb16-23-Mar9-Project1_Resume

- SlidingUpPanelIssue

- 詹戈

- uView-UI_1.8.3.zip