Python与Selenium:模拟浏览器操作,轻松应对反爬策略

版权申诉

86 浏览量

更新于2024-09-14

1

收藏 248KB PDF 举报

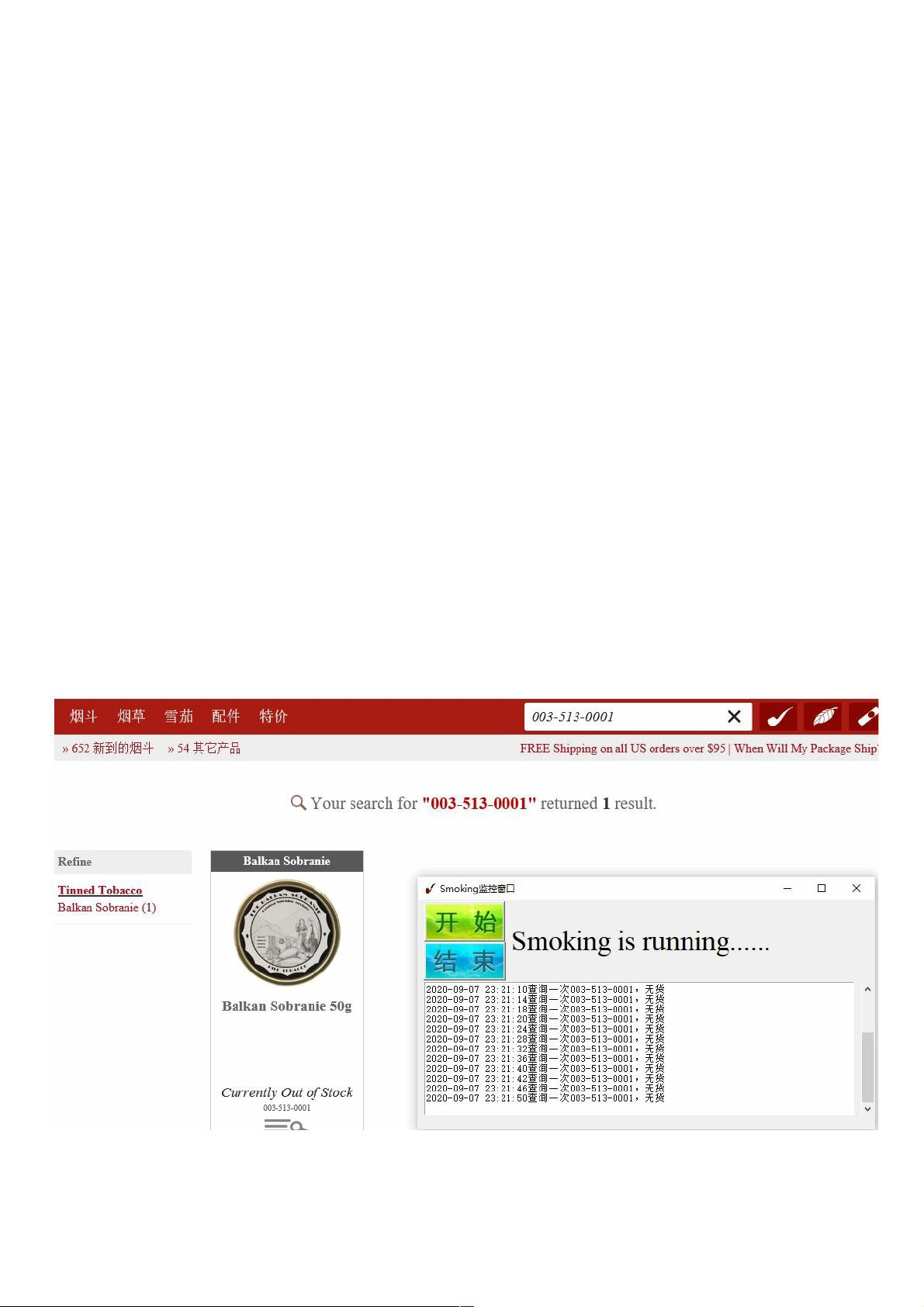

在Python中,Selenium是一个强大的工具,用于模拟浏览器自动化操作,特别适用于处理那些采用复杂动态加载或实施了反爬虫策略的网站数据抓取。Selenium作为Web应用程序测试的基础框架,它的核心理念是提供与真实用户行为一致的浏览器环境,支持多种浏览器(如IE、Firefox、Chrome等)和操作系统。

在进行网站数据采集时,遇到的挑战可能包括JavaScript加密、Ajax请求以及反调试技术。这时,利用Selenium可以编写Python脚本来模拟用户的交互动作,例如点击按钮、填写表单,从而获取隐藏或动态加载的数据。例如,可以通过find_element_by_xpath或find_elements_by_xpath方法定位页面上的特定元素,进而实现元素的查找、赋值和事件触发。

Python编程中的关键知识点在这一过程中得以体现,比如:

1. **元素定位**:Selenium提供了多种定位元素的方式,包括ID、Name、ClassName、CssSelector、PartialLinkText、LinkText、XPath和TagName等,这有助于根据不同的网页结构灵活选择定位策略。

2. **数据操作**:定位到元素后,可以读取元素的值(get_attribute)、设置属性(send_keys)或触发事件(click),执行模拟用户的实际操作。

3. **并发控制**:为了提高效率和避免阻塞用户界面,使用Python的线程(threading)机制进行后台任务处理。通过创建继承自threading.Thread的类,重写run方法来定义新线程,并通过线程锁(threading.Lock)确保线程间的同步。

4. **队列(Queue)应用**:将Selenium执行过程中的信息存储在Queue中,便于管理和异步处理。这样可以确保主线程不被阻塞,同时保持代码的可扩展性。

5. **跨平台支持**:由于Selenium支持多种浏览器和操作系统,因此可以适应不同的开发环境和应用场景。

学习和使用Python与Selenium进行浏览器模拟操作,不仅能够提升爬虫的适应性和灵活性,还能锻炼开发者对HTML、JavaScript、CSS以及并发编程的理解和实践能力。然而,要注意尊重网站的robots.txt协议和使用规则,确保合法和合规的数据抓取。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2020-09-20 上传

点击了解资源详情

2024-11-05 上传

weixin_38670297

- 粉丝: 7

- 资源: 927