深度学习:CNN网络结构演变历程详解

版权申诉

10 浏览量

更新于2024-06-26

收藏 3.31MB DOCX 举报

"CNN基本网络结构发展简史超全总结"

本文主要概述了卷积神经网络(CNN)的发展历程,从基本组件到经典的网络结构,包括LeNet5、AlexNet、VGG、GoogLeNet以及Inception系列的演变。

1. CNN基本部件

- 局部感受野:CNN中的每个神经元只对图像的一部分区域敏感,通过卷积操作实现,降低了参数数量。

- 卷积层:使用共享权重的滤波器对输入图像进行扫描,提取特征。

- 池化层:通常使用最大池化或均值池化,降低维度,减少计算量,保持重要信息。

- 激活函数:如sigmoid、tanh、ReLU,引入非线性,ReLU在卷积层中广泛使用。

- 全连接层:作为分类器,将前面的卷积和池化层输出展平后连接。

2. 经典网络结构

- LeNet5:早期的CNN模型,由两层卷积、两层池化和两层全连接构成,使用5×5卷积核和maxpooling。

- AlexNet:引入ReLU激活函数、dropout和数据增强,使用双GPU,首次在ILSVRC比赛中取得显著成绩。

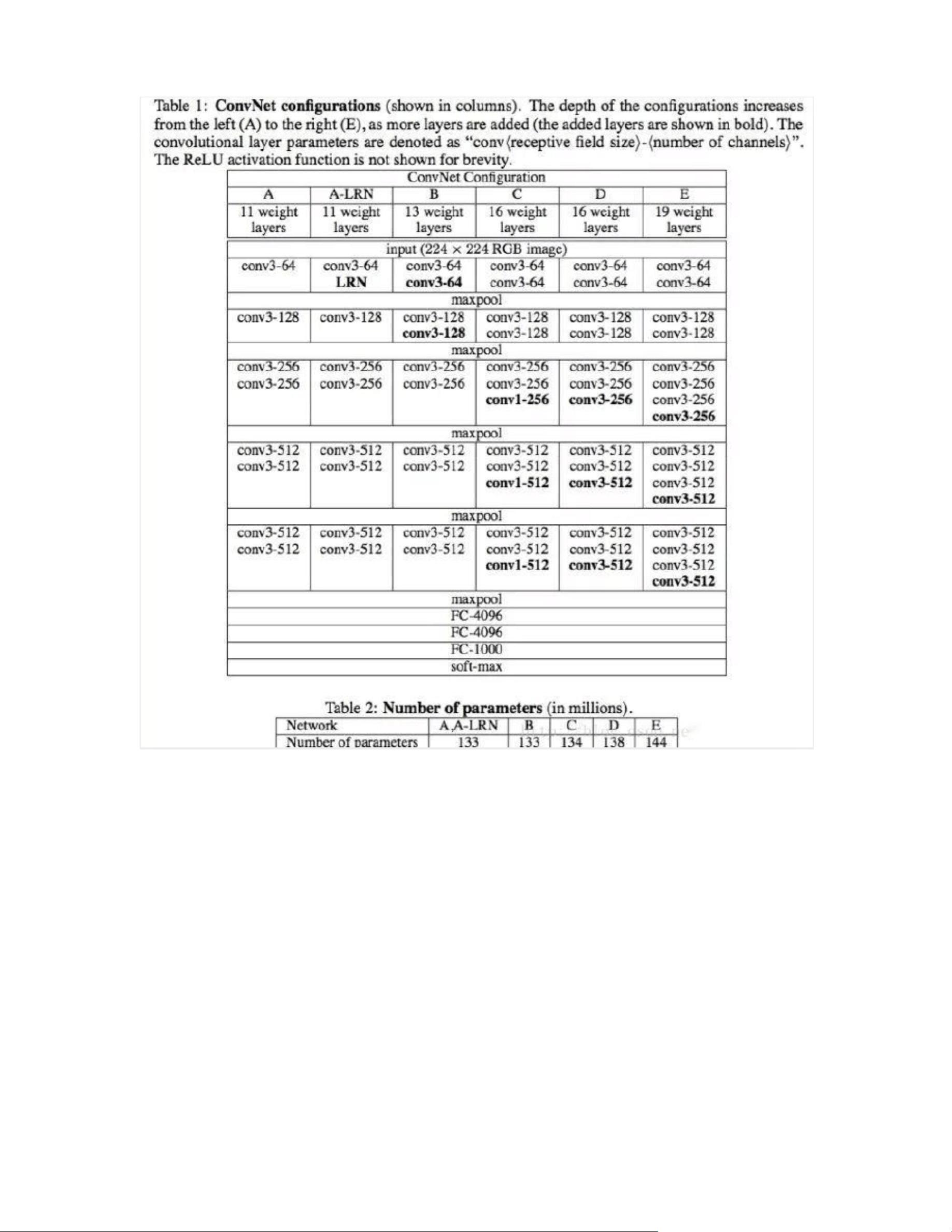

- VGG网:以深度著称,多段连续的3×3卷积叠加,最后接最大池化,参数数量较多。

- GoogLeNet(Inception):为解决深度与参数量问题,提出Inception模块,利用1×1卷积减少参数并增加网络宽度,提高对不同尺度的适应性。

- Inception-v2:引入批量归一化(Batch Normalization),提高训练速度和性能,优化5×5卷积为两个3×3卷积。

- Inception-v3:进一步改进,采用更精细的设计,例如使用步长为2的卷积替代池化,以及更复杂的Inception模块布局。

这些经典网络结构的发展展示了CNN如何从简单的架构逐渐演变为复杂而高效的模型,以适应更复杂的视觉任务和更大规模的数据集。通过调整网络深度、宽度、滤波器尺寸以及引入新的技术如批量归一化、残差连接等,CNN在图像识别、目标检测等领域取得了巨大的进步。随着研究的深入,未来CNN架构可能会继续进化,以应对更高效、更准确的计算机视觉挑战。

2018-10-30 上传

apple_51426592

- 粉丝: 9838

- 资源: 9652

最新资源

- HYActivityView(iPhone源代码)

- Nacos oracle专用

- rjmco-tfc-gcp-experiments:Terraform Cloud w GCP集成实验

- fontpath-renderer:字体路径字形的通用渲染器

- drl-trainers:深度强化模型训练师

- 手机APP控制,蓝牙LED彩灯制作+ARDUINO源码-电路方案

- Shoply-App-React-Redux

- JoliTypo:Web微型打字机修复程序

- FitnessTracker

- Android文字动画效果源代码

- GLSL-live-editor:基于 Codemirror 的 GLSL 实时编辑器

- 电子功用-大功率中频电源电子平波电抗器

- 基于AT89S52单片机的电子万年历(原理图+汇编程序)-电路方案

- SpeechMatics:简称语音自动识别(ASR),是一种技术,它可以使人们使用自己的声音通过计算机界面以一种最复杂的方式类似于普通人类对话的方式来讲话

- IVEngine(iPhone源代码)

- MATLAB神经网络优化算法.zip