GPU编程:CUDA线程与架构解析

17 浏览量

更新于2024-07-14

收藏 955KB PDF 举报

"CUDA线程——GPU架构与编程——NYU CSCI-GA.3033-012(2012)课程讲义——计算机科学"

在计算机科学领域,特别是在高性能计算和图形处理中,GPU(Graphics Processing Unit,图形处理器)已经成为了重要的计算平台。CUDA(Compute Unified Device Architecture,统一计算设备架构)是由NVIDIA推出的一种编程模型,它允许程序员直接利用GPU的强大并行计算能力。本课程的第五讲主要探讨了CUDA线程的概念及其在GPU架构中的实现。

CUDA线程是GPU编程的基础,它涉及到以下几个关键概念:

1. **软件与硬件交互**:CUDA编程模型将GPU视为一组可编程的资源,程序员通过编写内核函数来定义线程的行为。线程、内核、块和网格是这个模型中的核心概念。

2. **块(Blocks)**:线程块是线程的集合,它们在硬件中被一起调度执行。每个块可以包含多个线程,并且可以以三维数组的形式组织(blockDim.x, blockDim.y, blockDim.z)。每个线程块在一个特定的Streaming Multiprocessor(SM,流式多处理器)上执行。

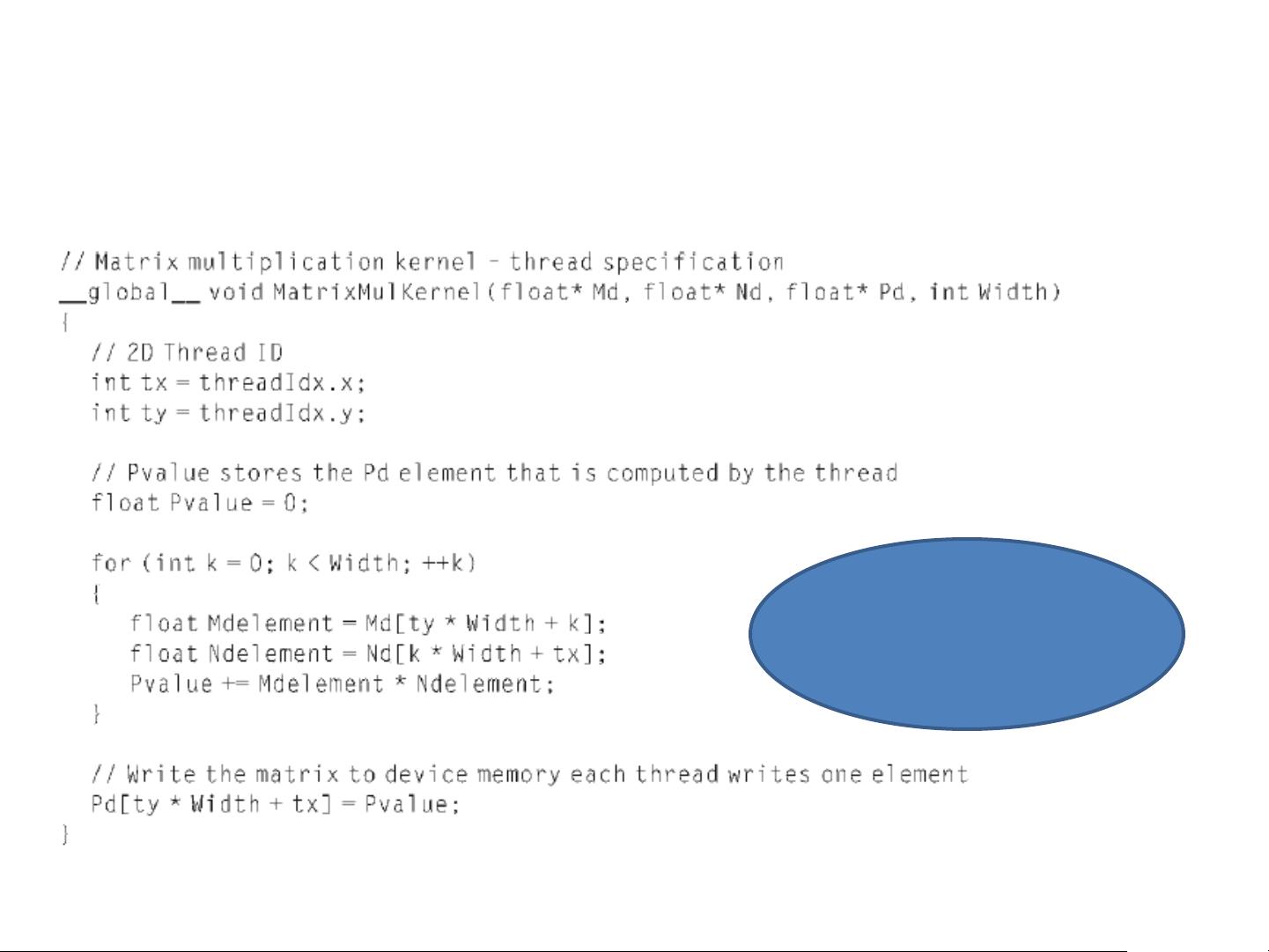

3. **内核(Kernel)**:内核函数是运行在GPU上的并行代码,所有线程在一个网格中执行相同的内核函数。这意味着每个线程会根据其各自的索引执行不同的部分任务。

4. **线程(Threads)**:线程是GPU上执行的基本单位,它们并行运行,共同完成任务。在每个块内,线程也可以按照三维数组组织。

5. **网格(Grid)**:网格是线程块的二维数组,用gridDim.x和gridDim.y定义其大小。所有线程块在同一网格中执行相同的功能,但可以分配到不同的计算资源。

6. **硬件实现**:GPU内部由多个SM组成,每个SM包含多个Streaming Processors(SP,流处理器)。SP是实际执行计算的单元。线程块被映射到SM上,SM调度和执行其内的线程。

7. **限制条件**:为了确保有效执行,有一些重要的限制需要注意。比如,所有线程必须执行相同的内核函数;网格是二维数组,线程块也是三维数组;一旦内核启动,其尺寸不可更改;所有线程块的尺寸必须一致;每个块的总线程数量不能超过512个;一旦线程块被分配给一个SM,该SM必须完整执行该块的所有线程。

通过这样的线程组织方式,CUDA能够实现高效的并行计算。图32展示了一个CUDA线程组织的示例,显示了网格、块以及块内的线程如何在GPU上分布和执行。

理解并掌握这些基本概念对于深入学习CUDA编程至关重要,能够帮助开发者充分利用GPU的并行计算能力,解决复杂的计算问题,如物理模拟、图像处理、机器学习等领域的计算密集型任务。

2022-05-09 上传

2024-04-24 上传

2021-04-22 上传

2021-04-22 上传

2021-04-22 上传

2021-04-22 上传

2021-04-22 上传

2021-05-10 上传

2022-09-19 上传

weixin_38599712

- 粉丝: 8

- 资源: 860

最新资源

- IEEE 14总线系统Simulink模型开发指南与案例研究

- STLinkV2.J16.S4固件更新与应用指南

- Java并发处理的实用示例分析

- Linux下简化部署与日志查看的Shell脚本工具

- Maven增量编译技术详解及应用示例

- MyEclipse 2021.5.24a最新版本发布

- Indore探索前端代码库使用指南与开发环境搭建

- 电子技术基础数字部分PPT课件第六版康华光

- MySQL 8.0.25版本可视化安装包详细介绍

- 易语言实现主流搜索引擎快速集成

- 使用asyncio-sse包装器实现服务器事件推送简易指南

- Java高级开发工程师面试要点总结

- R语言项目ClearningData-Proj1的数据处理

- VFP成本费用计算系统源码及论文全面解析

- Qt5与C++打造书籍管理系统教程

- React 应用入门:开发、测试及生产部署教程