CUDA编程进阶:线程束与分支分歧

需积分: 3 152 浏览量

更新于2024-07-30

收藏 667KB PPTX 举报

"CUDA编程教程第二部分,涵盖了线程、 warp执行、共享内存以及银行冲突的概念,适合GPGPU编程学习者"

CUDA是NVIDIA公司推出的一种并行计算平台和编程模型,它允许程序员利用图形处理器(GPU)的计算能力进行高性能计算。在这个CUDA教程的第二部分中,我们将深入理解CUDA编程的核心概念。

首先,WARP是CUDA中的基本执行单位,由连续的32个线程组成。每个warp在同一时间执行一条共同的指令。如果线程分支(即条件判断导致不同的线程执行不同的路径),则warp会串行地执行每条分支路径,这可能导致效率降低,因为GPU需要为每个可能的分支路径执行额外的指令。

其次,共享内存是一种高速缓存内存,用于存储频繁访问的数据。它可以被同一个线程块内的线程访问,但不同线程块间的线程无法共享。每个线程块最多可以有48KB的共享内存,在计算能力为2.x的GPU上。在内核(kernel)中静态分配共享内存,可以指定每个线程块所需的共享内存大小,并且这个内存对块内的所有线程可见。

然后,使用共享内存有两种主要方式:一是直接在内核配置中声明;二是通过内核代码动态管理。这两种方法都需要考虑如何有效地利用共享内存以提高访问速度和减少银行冲突。

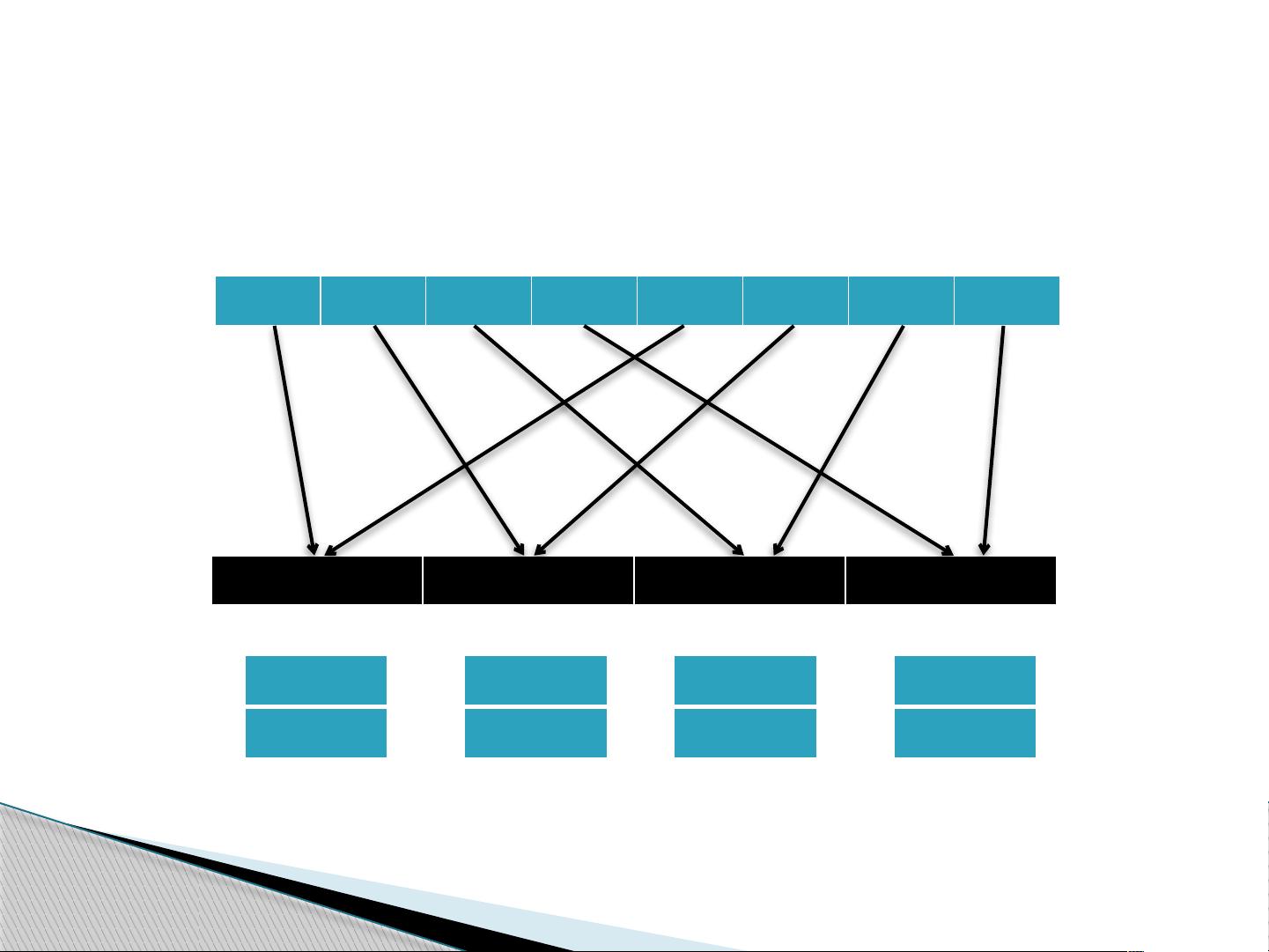

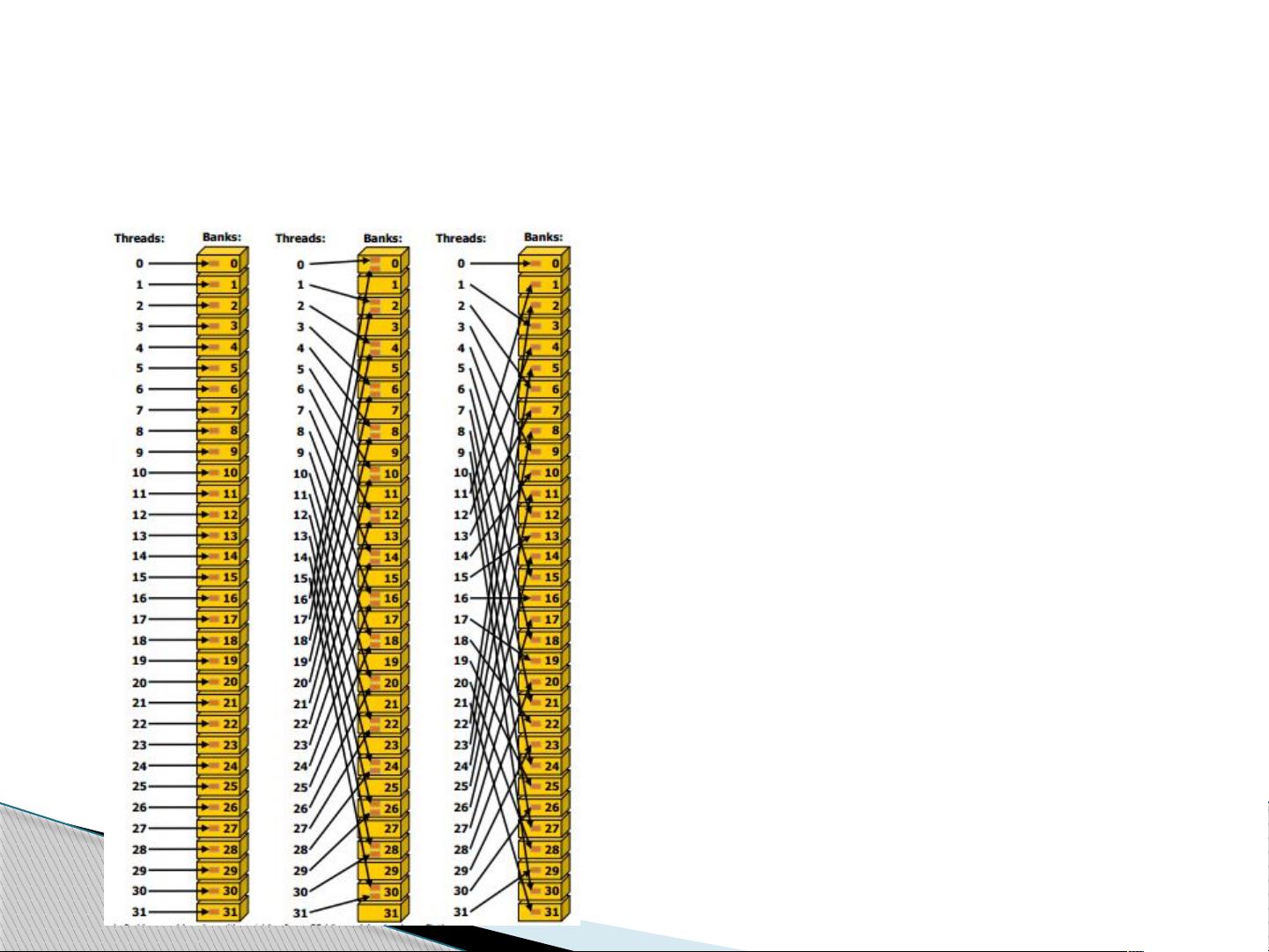

说到银行冲突,CUDA的共享内存被划分为32个内存银行,每个银行有32位的带宽。为了优化性能,连续的32位字会交错分配到不同的银行中。这样,来自不同银行的内存访问可以同时被服务。然而,如果多个线程尝试访问同一银行中的不同位置,就会发生银行冲突,这会导致访问延迟,降低内存访问效率。因此,良好的数据对齐和内存访问模式设计是避免或减少银行冲突的关键。

在开发CUDA程序时,理解和优化warp执行、共享内存的使用以及避免银行冲突是提升程序性能的关键因素。了解这些基础概念后,开发者可以进一步探索CUDA的更高级特性,如纹理内存、常量内存、同步机制以及流式多处理器(SM)的调度策略,以实现更高效、更优化的GPGPU计算。

2021-05-18 上传

2012-03-13 上传

2011-12-02 上传

2009-12-21 上传

2021-03-14 上传

2012-10-25 上传

2021-05-26 上传

2021-04-17 上传

lumianph

- 粉丝: 0

- 资源: 2

最新资源

- Elasticsearch核心改进:实现Translog与索引线程分离

- 分享个人Vim与Git配置文件管理经验

- 文本动画新体验:textillate插件功能介绍

- Python图像处理库Pillow 2.5.2版本发布

- DeepClassifier:简化文本分类任务的深度学习库

- Java领域恩舒技术深度解析

- 渲染jquery-mentions的markdown-it-jquery-mention插件

- CompbuildREDUX:探索Minecraft的现实主义纹理包

- Nest框架的入门教程与部署指南

- Slack黑暗主题脚本教程:简易安装指南

- JavaScript开发进阶:探索develop-it-master项目

- SafeStbImageSharp:提升安全性与代码重构的图像处理库

- Python图像处理库Pillow 2.5.0版本发布

- mytest仓库功能测试与HTML实践

- MATLAB与Python对比分析——cw-09-jareod源代码探究

- KeyGenerator工具:自动化部署节点密钥生成