GPU排序算法:利用图形处理器的高效优势

"Gpusort.ppt" 是一份关于利用图形处理器(GPUs)进行高效排序算法的演示文稿,由 Daniel Cederman 和 Philippas Tsigas 在 Chalmers University of Technology 的 Distributed Computing and Systems 课程中介绍。相较于传统的正常处理器(Normal processors),GPU 具有显著的不同特性:

1. **多核心架构**:GPUs 通常拥有大量的多核心设计,每个核心负责处理一部分任务,这种并行性是其高效性能的关键。

2. **大缓存容量**:尽管单个核心的缓存可能较小,但整体上,GPU 的缓存设计旨在通过减少内存访问延迟来提升性能。

3. **低线程密度**:传统处理器每个核心处理相对较少的线程,而GPU 可能包含数千个并发执行的线程,这有助于数据并行处理。

4. **推测执行**:GPU 使用推测执行技术,试图预测下一步操作以加速计算过程,但在某些情况下可能导致效率降低。

5. **内存带宽优势**:由于GPU的内存结构,它们通常配备有宽且高速的内存接口,这对于大量数据的快速传输至关重要。

6. **共享内存**:GPU 内部的共享内存设计允许相邻的线程块(Thread Block)进行高效的局部通信,减少了全局内存访问的开销。

7. **手动缓存管理**:GPU 缺乏自动缓存机制,程序员需要手动管理数据的存储位置以优化性能。

8. **SIMD指令集**:GPU 提供了32字节的SIMD(Single Instruction Multiple Data)指令,可以同时处理多个数据元素,进一步提升并行计算能力。

9. **协调内存访问**:为了提高效率,GPU鼓励线程在内存中以块(Block)的形式进行coalesced(连续的)访问,避免无序或非对齐的读写操作。

10. **同步限制**:GPU倾向于简化同步机制,避免频繁的阻塞,但这也意味着程序员需要精心设计代码以防止数据竞争。

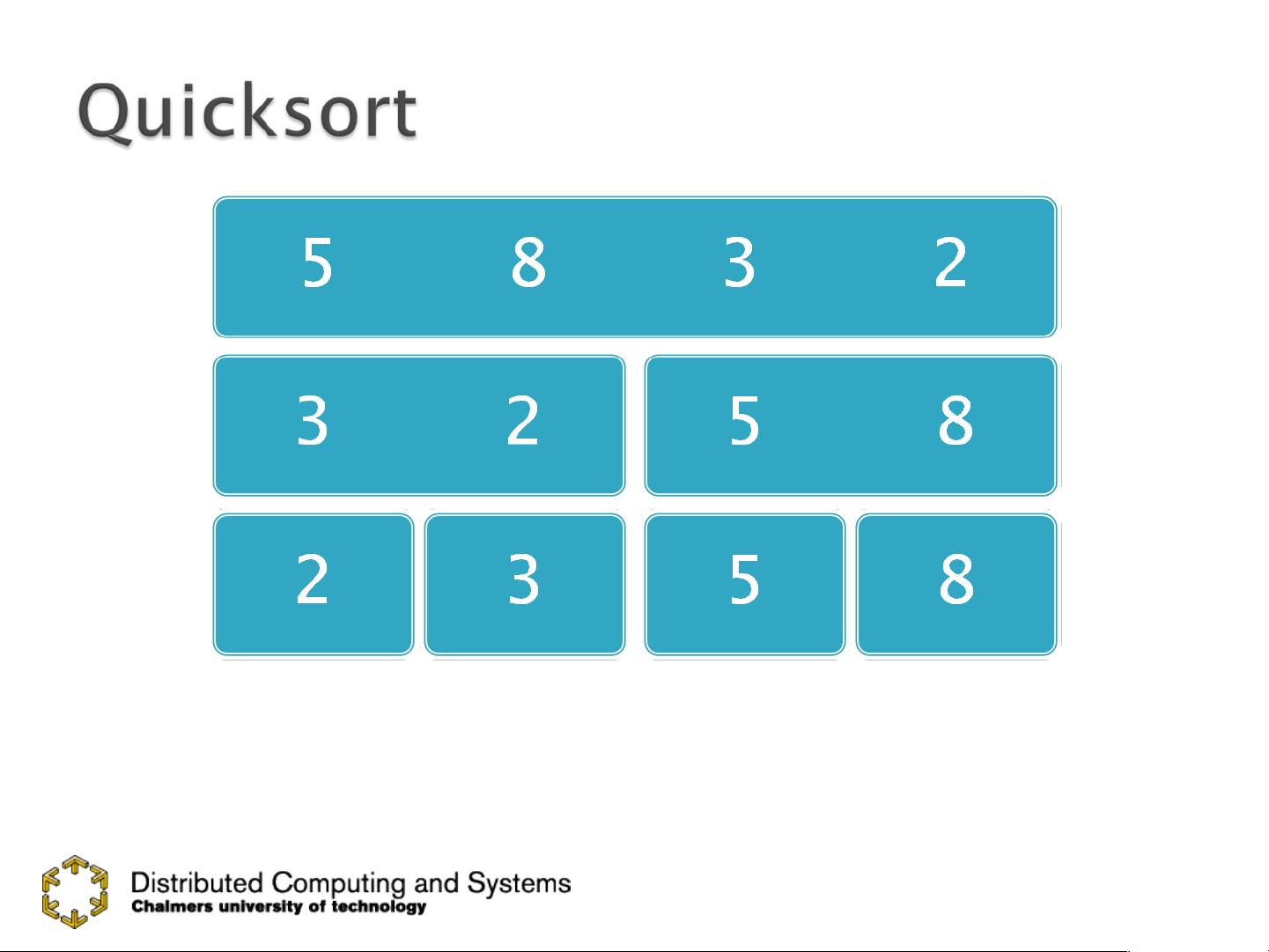

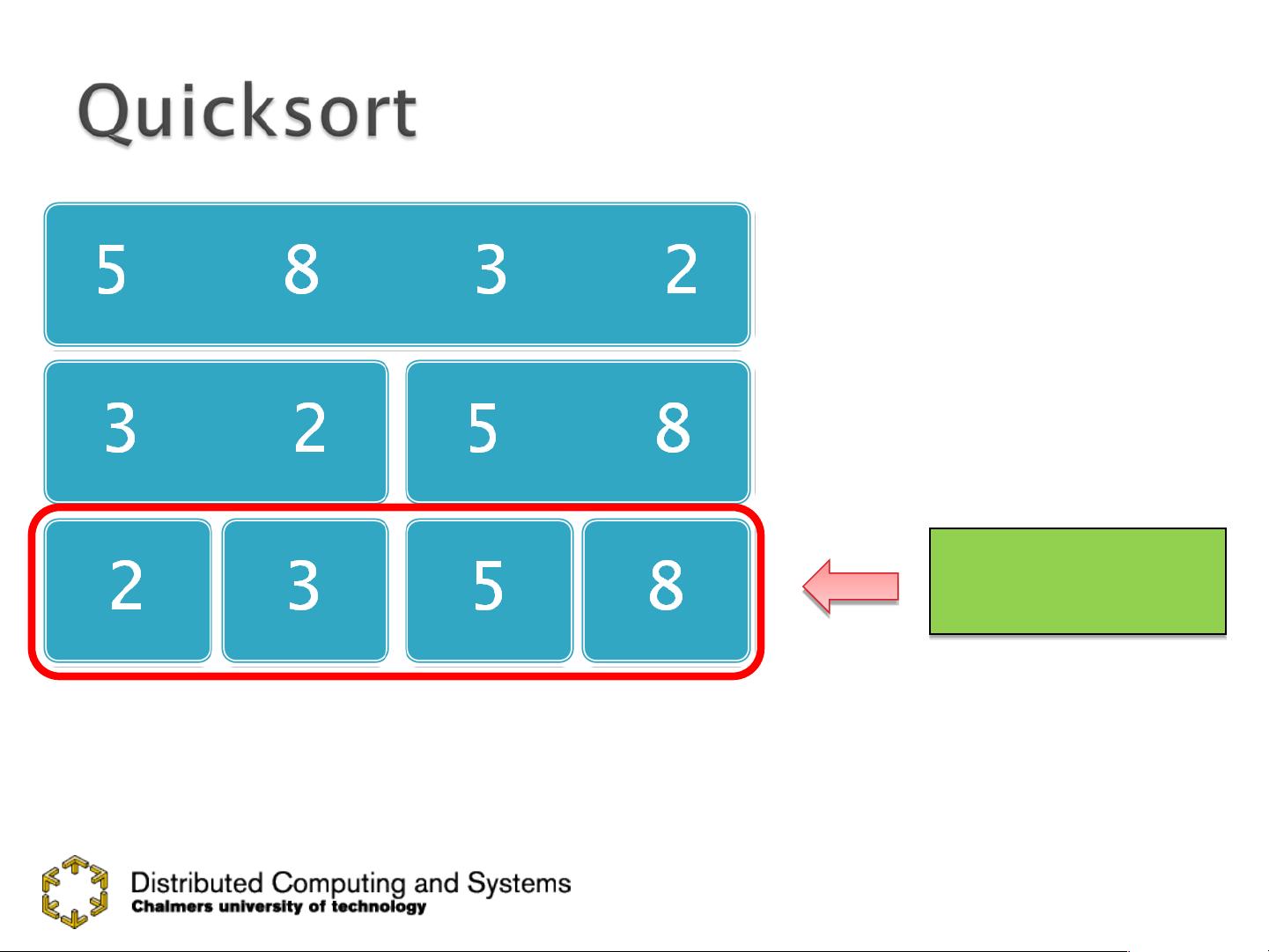

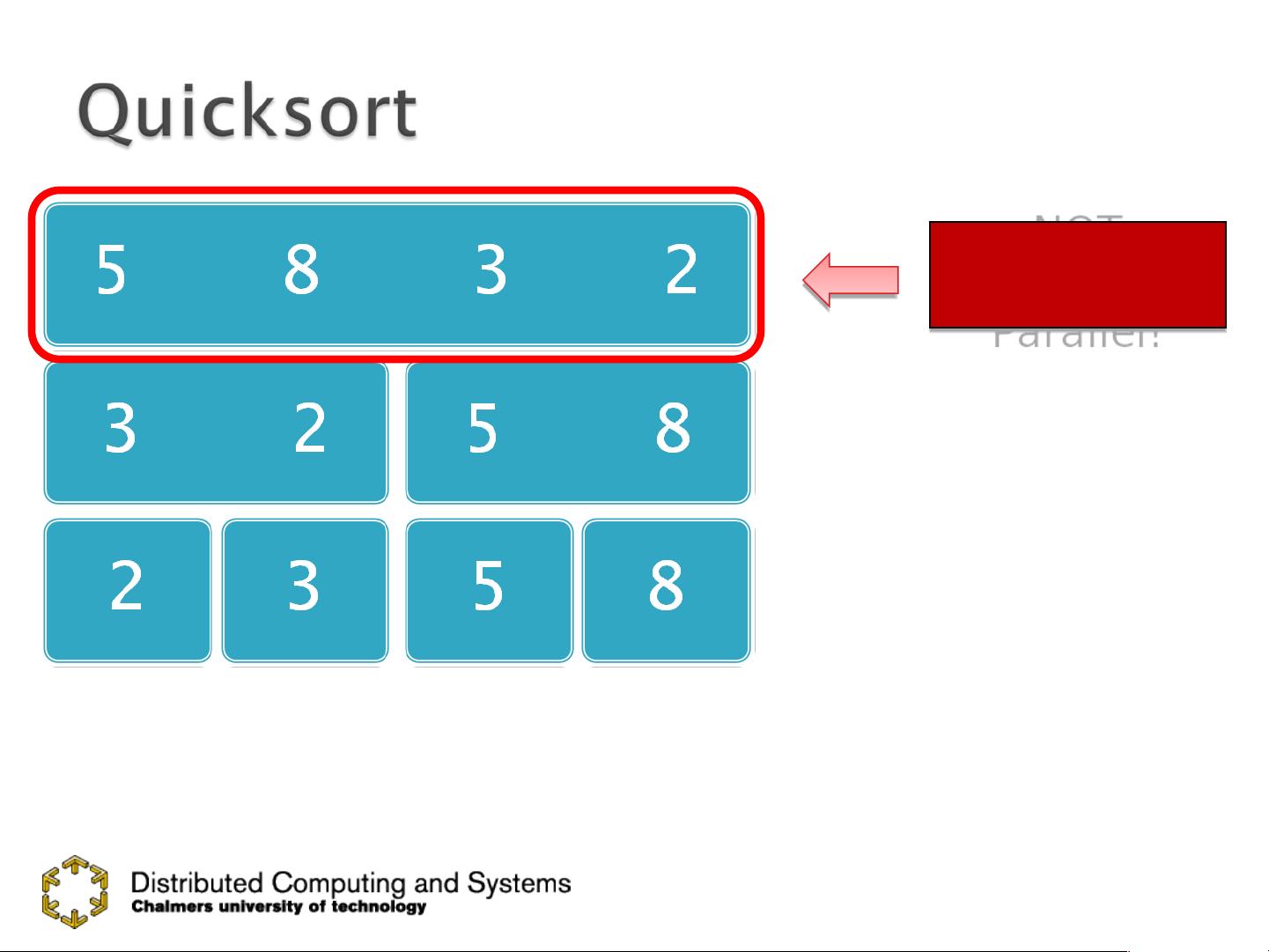

11. **数据并行编程模型**:Gpusort算法主要基于数据并行原则,这意味着任务分解成小的数据单元,由多个线程同时处理,而不是顺序执行。

Gpusort.ppt展示了如何利用GPU的硬件特性(如并行处理、高速内存和手动缓存控制)以及特定的编程模型(如数据并行性和内存优化),来实现高效率的排序算法。这对于那些需要大规模数据处理和高性能计算的应用场景具有重要的参考价值。学习和理解这些概念对于编写适用于GPU的高效代码至关重要。

点击了解资源详情

点击了解资源详情

点击了解资源详情

leonhd

- 粉丝: 11

- 资源: 51

最新资源

- NotATokenLogger

- capture_react

- ac:YML放置区

- 学生成绩管理系统.rar

- 【Java毕业设计】Java 网上商城系统-毕业设计.zip

- 电子功用-按键识别方法、键盘和电子设备

- AT91SAM7X256开发板(工程文件+程序),可直接制板加工-电路方案

- kbd_check:键盘检查器

- python实例-13 截图工具.zip源码python项目实例源码打包下载

- DA_project-

- Bot-S-ries-SITE-TOP-FLIX:阿尔法玛意甲上的Bot para passar osepisódios现场,Top Flix,testei unicamente nasérie宣言。

- django_sso:Django框架实现OAuth2

- 【Java毕业设计】c++,毕业设计,因为网络专业不能写java。冥思苦想了这么个玩意儿,本来想借此机会学习http.zip

- 电子功用-可充电锂硫电池的正极活性物质及其制备方法

- PackCC:用于C的packrat解析器生成器-开源

- 卡片式插入列表(iPhone源代码)