深度学习教程:RNN详解与应用

版权申诉

99 浏览量

更新于2024-06-21

收藏 6.08MB PDF 举报

深度学习教程的第六章深入探讨了循环神经网络(RNN)这一重要主题。RNN在深度学习领域中占据核心地位,尤其在自然语言处理(NLP)和序列数据处理任务中表现出色。本章首先阐述了RNN的需求背景,强调了它们在处理具有时间依赖性的信息,如文本、音频或视频时的优势。

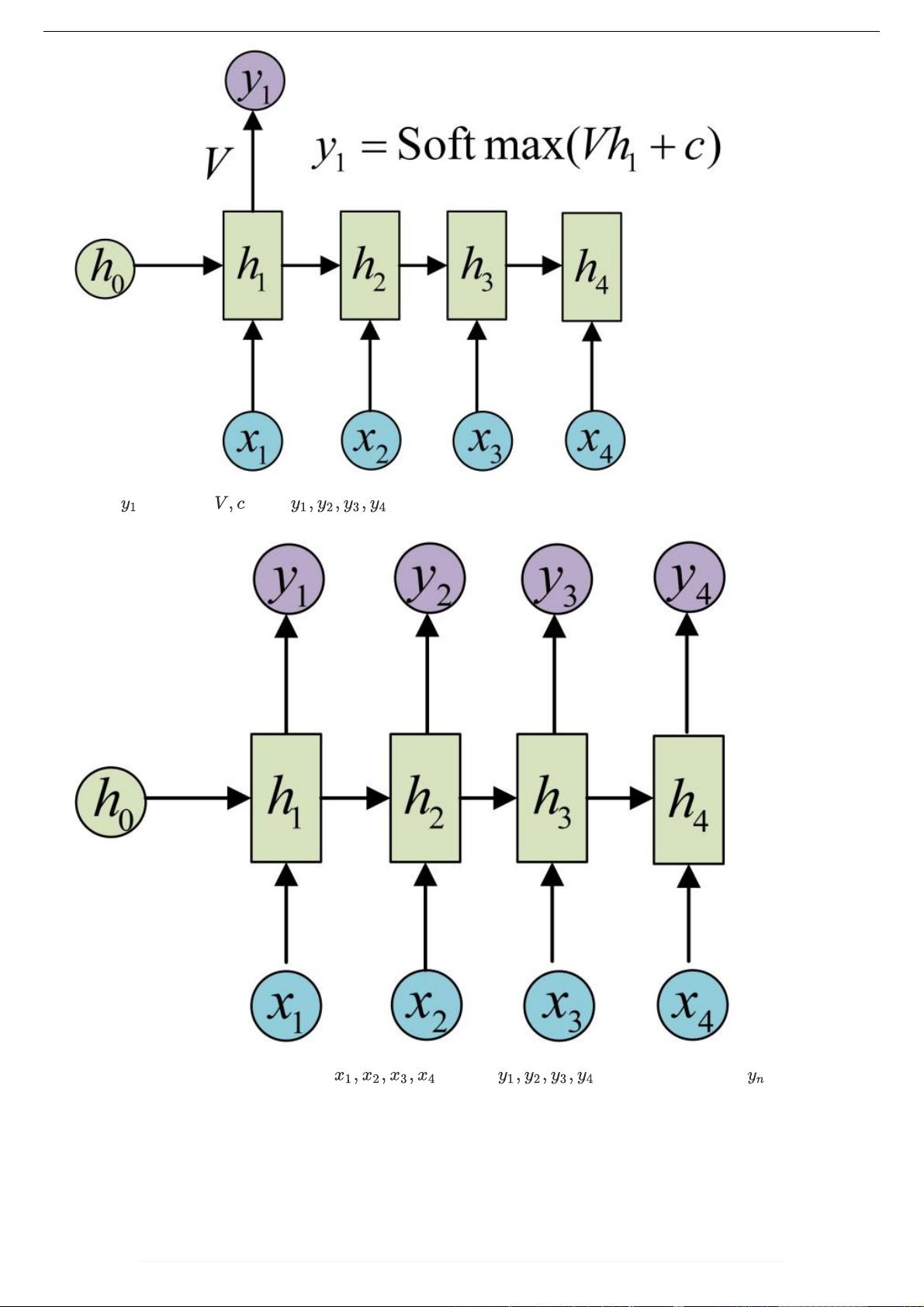

章节内容涵盖了RNN的基本结构,包括经典的单层网络架构,如Elman RNN,以及其变种,如vector-to-sequence和sequence-to-vector结构,用于将输入或输出转化为序列形式。Encoder-Decoder结构在此处也得到了介绍,这种模式常用于机器翻译和对话系统中。

Attention机制是RNN中的关键组件,它帮助模型关注输入序列的不同部分,增强了模型的全局理解和处理能力。RNN的特点,如能够处理变长输入和具有记忆功能,与传统的前馈神经网络(FNNs)和卷积神经网络(CNNs)进行了对比,突出了它们在处理动态序列数据的独特优势。

训练RNN时,遇到的主要挑战之一是梯度消失或梯度爆炸的问题。这章节解释了为何这些现象会发生,并讨论了长期短期记忆(LSTM)模型的诞生,以解决梯度消失问题。LSTM通过引入门控机制来控制信息流动,有效缓解了这个问题。

除了LSTM,还介绍了其他RNN的改进版本,如门控循环单元(GRUs),它们同样在保持长期依赖性方面表现出色。在NLP应用中,RNN的扩展模型如双向RNN(BiRNN)、深度RNN、Echo State Networks(ESNs)以及Gated Recurrent Unit (GRU) RNNs和双向LSTM等都被详细讲解。

章节最后列举了一些常见的RNN模型变体,如Stacked LSTMs(多层LSTM)、Clockwork RNNs(CW-RNNs)和结合CNN的模型(如CNN-LSTMs)。这些模型不仅展示了RNN技术的多样性,也展现了在实际应用中的灵活性和不断进化。

第六章深度学习教程中的RNN部分提供了全面而深入的理论基础和实践经验,有助于理解RNN在深度学习框架中的关键角色及其在解决序列数据问题上的优越性能。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2023-05-22 上传

2021-09-13 上传

2017-07-29 上传

2020-12-13 上传

2019-09-16 上传

2018-10-19 上传

安全方案

- 粉丝: 2538

- 资源: 3960

最新资源

- N10SG模块opencpu固件.zip

- 回收站变变变.zip易语言项目例子源码下载

- ARLAS-wui-builder:ARLAS-Wui的制造商

- ys-park-2

- electronic-ftrouter:用于运行电子的模板存储库,其中有运行路径的routex

- KottuRoti:Ant214项目游戏文件

- 前端开发css+html灯笼动画插件源代码

- pyg_lib-0.2.0+pt20-cp38-cp38-macosx_10_15_x86_64whl.zip

- tele_sign:Node.js库通过http发送消息

- CMPE:CMPE 安卓

- check-api-playground

- 判决matlab代码-self_other_moral:自我和他人道德判断的神经/行为基础项目

- 094. 2019年中国洗碗机市场年度总结报告.rar

- cornflux:用于React应用程序的调度库,可促进数据封装

- AndroidVision:在您的手机上学习图像处理

- forten:Monorepo for Overmind模块