掌握Boosting集成学习:AdaBoost在决策树上的多分类实验

158 浏览量

更新于2024-08-03

收藏 77KB DOCX 举报

本实验是西南交通大学机器学习课程中的一个实践项目,旨在让学生深入理解并掌握集成学习中的Boosting策略,特别是AdaBoost算法。实验的主要目的是通过编程实现AdaBoost方法,将其应用到多分类任务中,具体使用决策树作为基模型,划分属性指标采用信息熵,且限制决策树的最大深度为1。学生需要完成以下步骤:

1. **实验环境**:实验需要用到Python编程语言,以及numpy和matplotlib库,前者用于数值计算,后者用于数据可视化。

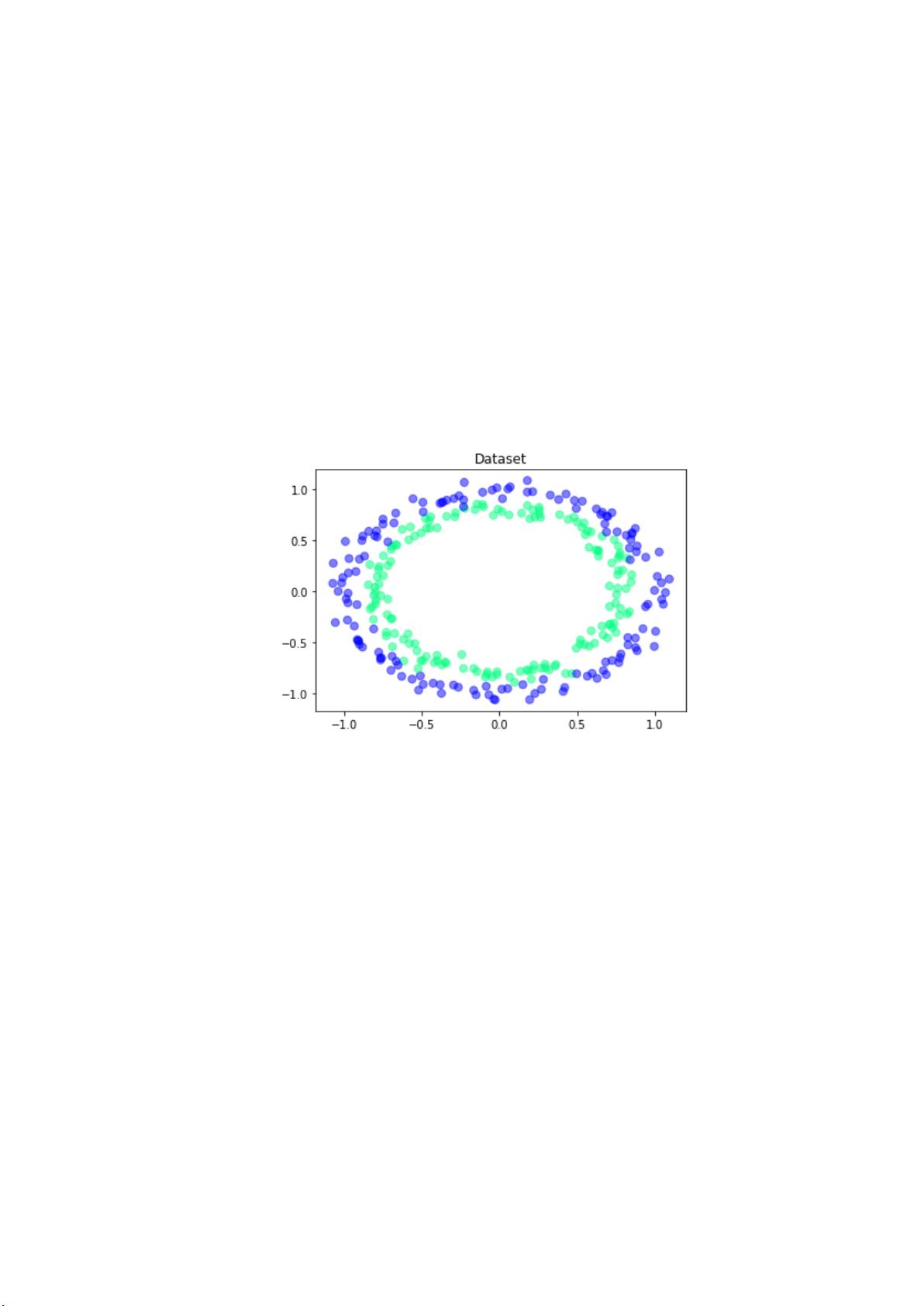

2. **数据处理**:实验数据分别存储在'experiment_08_training_set.csv'和'experiment_08_testing_set.csv'文件中,通过numpy的loadtxt函数读取数据,提取特征(train_x)和标签(train_y)以及测试数据(test_x, test_y)。

3. **AdaBoost核心算法**:

- 初始化所有样本权重w为均等分配。

- 对于每个基模型(DecisionTreeClassifier):

- 训练模型,使用信息熵作为划分属性的标准,且决策树的最大深度设为1。

- 计算模型预测结果与真实标签的差异,得到分类误差率。

- 根据误差率计算当前模型的权重α,公式涉及对分类错误的惩罚。

- 更新样本权重,根据预测值和真实标签调整,然后归一化权重。

- 将训练好的模型和其权重添加到列表中。

4. **实验要求**:学生需要设置不同的基模型数量T,对每个模型数量执行上述过程,然后计算集成模型在测试集上的精度。最后,绘制集成模型精度随基模型数量增加的变化曲线,观察如何随着更多弱分类器的加入,整体性能是否提升。

5. **实验报告提交**:学生需要提交包含关键代码(如上面的AdaBoost函数,带有中文注释)、必要的说明以及最终的精度变化曲线图作为实验报告的一部分。

通过这个实验,学生不仅可以了解Boosting方法的原理,还能锻炼编程技能,以及数据处理和分析的能力,同时加深对机器学习中集成学习的理解。

2023-07-17 上传

2023-07-17 上传

2023-07-17 上传

2023-07-17 上传

2023-07-17 上传

2023-07-17 上传

2023-07-17 上传

2023-07-17 上传

2023-07-17 上传

老学长~

- 粉丝: 6

- 资源: 25

最新资源

- Material Design 示例:展示Android材料设计的应用

- 农产品供销服务系统设计与实现

- Java实现两个数字相加的基本代码示例

- Delphi代码生成器:模板引擎与数据库实体类

- 三菱PLC控制四台电机启动程序解析

- SSM+Vue智能停车场管理系统的实现与源码分析

- Java帮助系统代码实现与解析

- 开发台:自由职业者专用的MEAN堆栈客户端管理工具

- SSM+Vue房屋租赁系统开发实战(含源码与教程)

- Java实现最大公约数与最小公倍数算法

- 构建模块化AngularJS应用的四边形工具

- SSM+Vue抗疫医疗销售平台源码教程

- 掌握Spring Expression Language及其应用

- 20页可爱卡通手绘儿童旅游相册PPT模板

- JavaWebWidget框架:简化Web应用开发

- 深入探讨Spring Boot框架与其他组件的集成应用