Spark大规模灰度发布与CI/CD实践解析

181 浏览量

更新于2024-08-28

收藏 1.13MB PDF 举报

"Spark在大规模集群上的灰度发布实践,结合了持续集成(CI)和持续部署(CD),确保在十万级节点上稳定运行。文章介绍了Spark如何利用Gitlab和Jenkins实现CI/CD流程,以高效管理和测试代码,防止错误积累并促进快速迭代。"

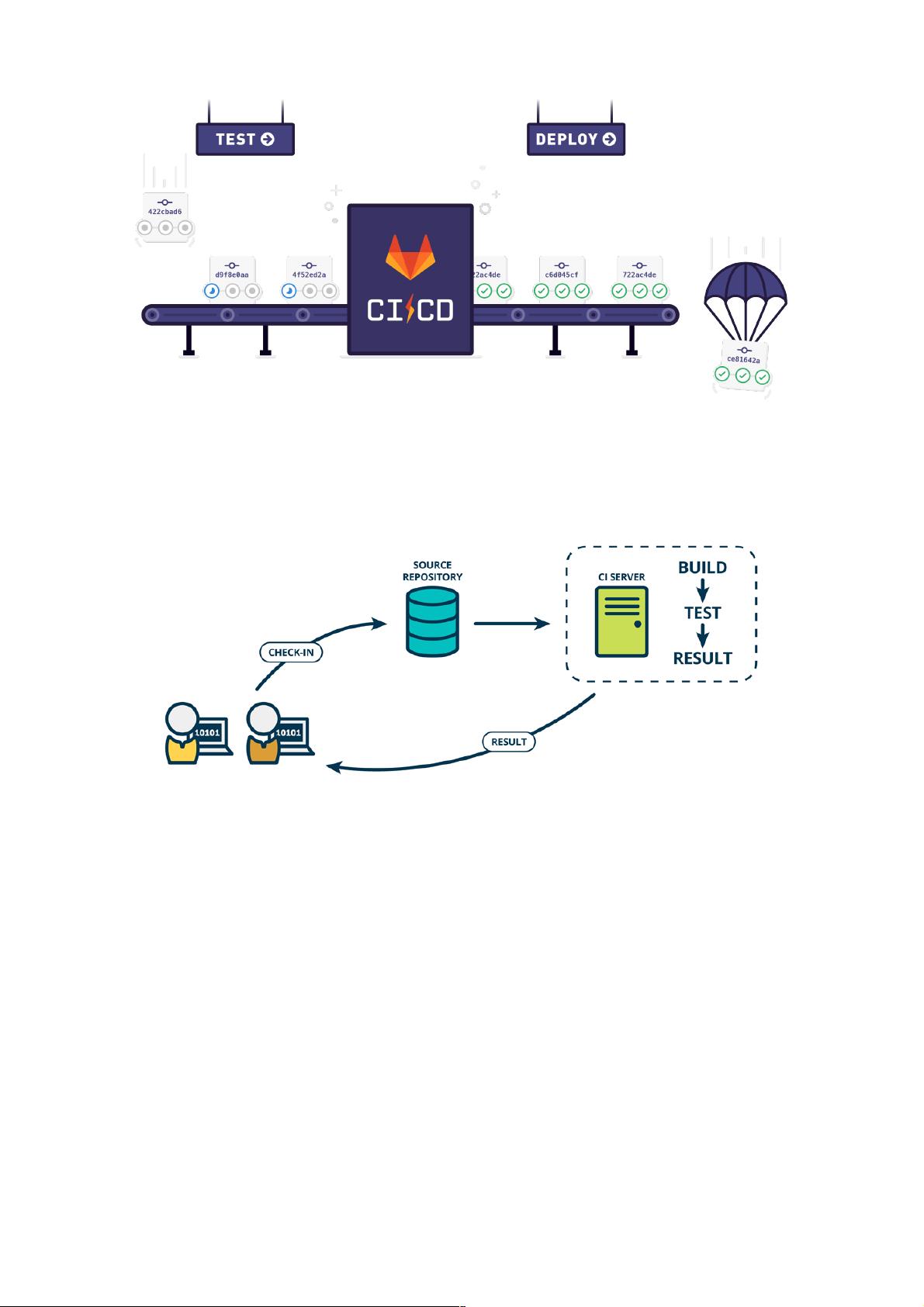

在Spark的灰度发布实践中,持续集成(CI)扮演了关键角色。CI的基本理念是频繁地将开发人员的代码变更合并到主分支,通常每次合并前都会进行自动化测试,以尽早发现并修复问题。这种方式有三个主要优点:

1. **快速发现错误**:每次提交后立即集成和测试,有助于快速定位并解决问题,减少了调试时间。

2. **避免分支偏离**:频繁集成可以防止子分支与主分支之间产生大的差异,减少集成时的冲突,避免重复工作。

3. **支持快速迭代**:持续集成为持续发布和部署奠定了基础,使得新功能或改进能迅速进入生产环境。

在Spark的具体实践中,使用Gitlab作为代码仓库,而Jenkins作为CI工具。当开发人员提交代码并发起Merge Request(MR)时,Gitlab通过Webhook通知Jenkins进行构建。这个构建过程包括:

1. **编译所有模块**:确保代码能够正确构建。

2. **运行单元测试**:验证每个模块的功能正确性。

3. **执行性能测试**:评估改动对系统性能的影响。

4. **检查测试结果**:任何失败的测试或性能下降都将导致构建失败。

Jenkins的结果会反馈给Gitlab,只有当构建成功,MR才能被合并。此外,还需要人工进行代码审查,确保代码质量。所有测试通过且审查同意后,代码会通过Gitlab的Merge功能自动合并到目标分支,确保了所有合并的代码都经过了严格的测试。

接下来,文章提到的持续交付(CD)是CI的延伸,它强调的是代码更改能够快速、可靠地部署到生产环境。在Spark的CD流程中,新版本的软件能够被及时交付,这进一步保证了系统能够快速响应需求变化,同时确保了在大规模节点上的稳定运行。

总结来说,Spark通过采用Gitlab和Jenkins的CI/CD流程,在十万级节点的环境中实现了高效的代码管理和测试,确保了软件的高质量和快速迭代,为灰度发布提供了坚实的基础。这种实践对于其他大型分布式系统也具有很高的参考价值。

weixin_38742409

- 粉丝: 14

- 资源: 954

最新资源

- C#窗体编程-----------.doc

- linux 内存寻址

- 计算机的常用网络命令

- 计算机组成原理与系统结构实验教程

- Liunx文件系统基本目录介绍说明

- Linux必学60个命令文件处理

- 8101E 安装说明

- SQL2008 Upgrade Technical Reference Guide

- DIV+CSS布局大全

- BTS3900WCDMA硬件安装指南

- C#教程(PDF格式)

- 高等代数各章节课件多项式.行列式.线性方程等等

- GPU_Programming_基于GPU编程的中文文档

- 海量数据访问——示例(C++)

- flexflexflexflexflexflex

- 长波授时系统相位跟踪点检测的数字化研究