Prompt安全:窃取与防护技术综述

157 浏览量

更新于2024-06-18

收藏 12.86MB PDF 举报

"Prompt窃取与保护相关文献介绍"

在当前的AI领域,特别是预训练语言模型(LLM)的应用中,Prompt技术已经成为一种有效的方法,用于引导模型进行特定任务的处理。然而,随着Prompt技术的发展,其安全性问题也日益突出,主要体现在Prompt窃取和保护两个方面。本摘要涵盖了多篇关于Prompt窃取与保护的研究文献,这些研究旨在理解和解决这一新兴领域的挑战。

首先,Prompt被分为两种类型:HardPrompt和SoftPrompt。HardPrompt是离散的,以自然语言的形式存在,而SoftPrompt则是连续的,表现为Embedding形式。HardPrompt通常更直观,易于理解,但可能更容易被复制或窃取。SoftPrompt则通过微调模型参数来实现,可能更难以直接窃取,但可能存在被逆向工程解析的风险。

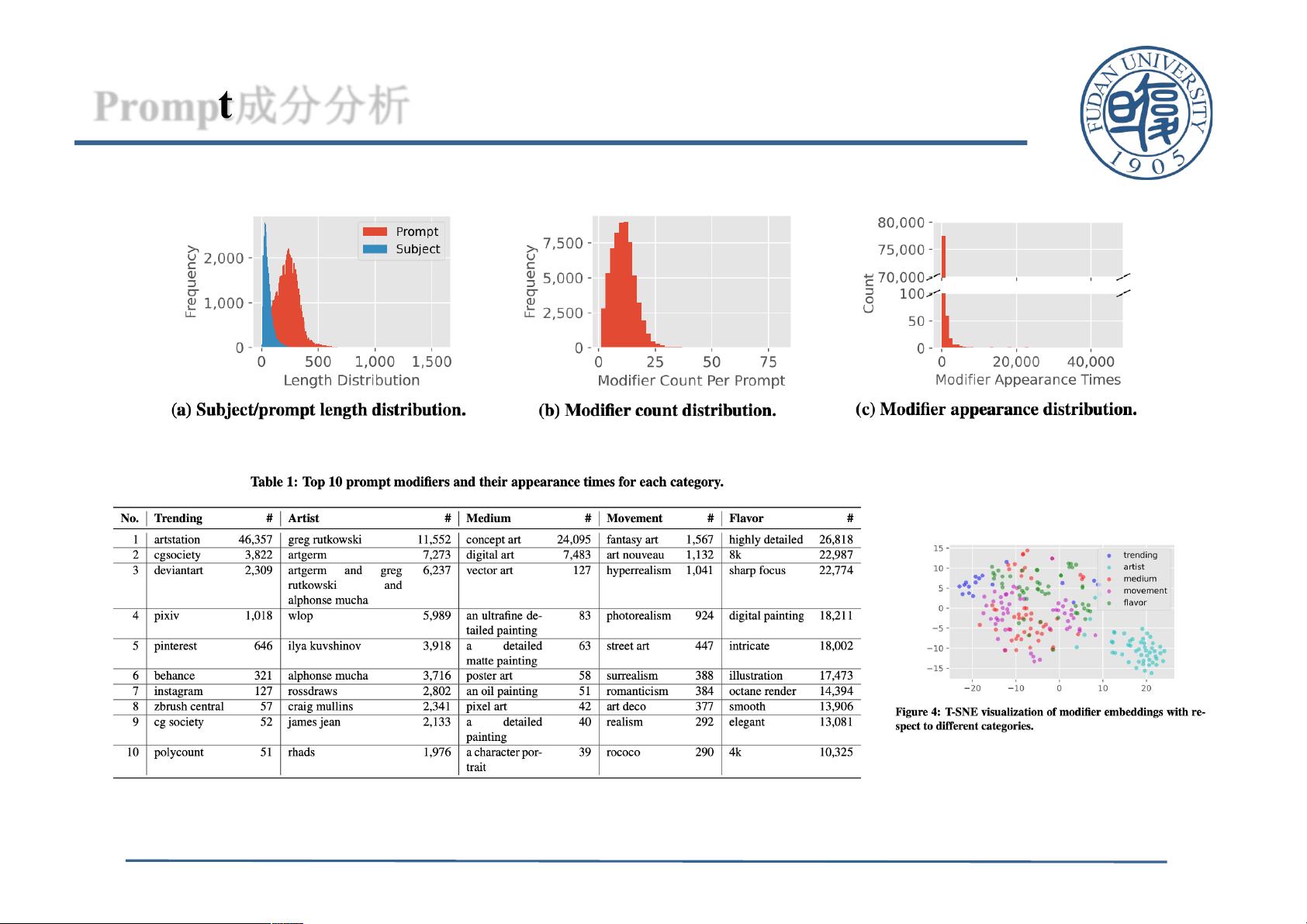

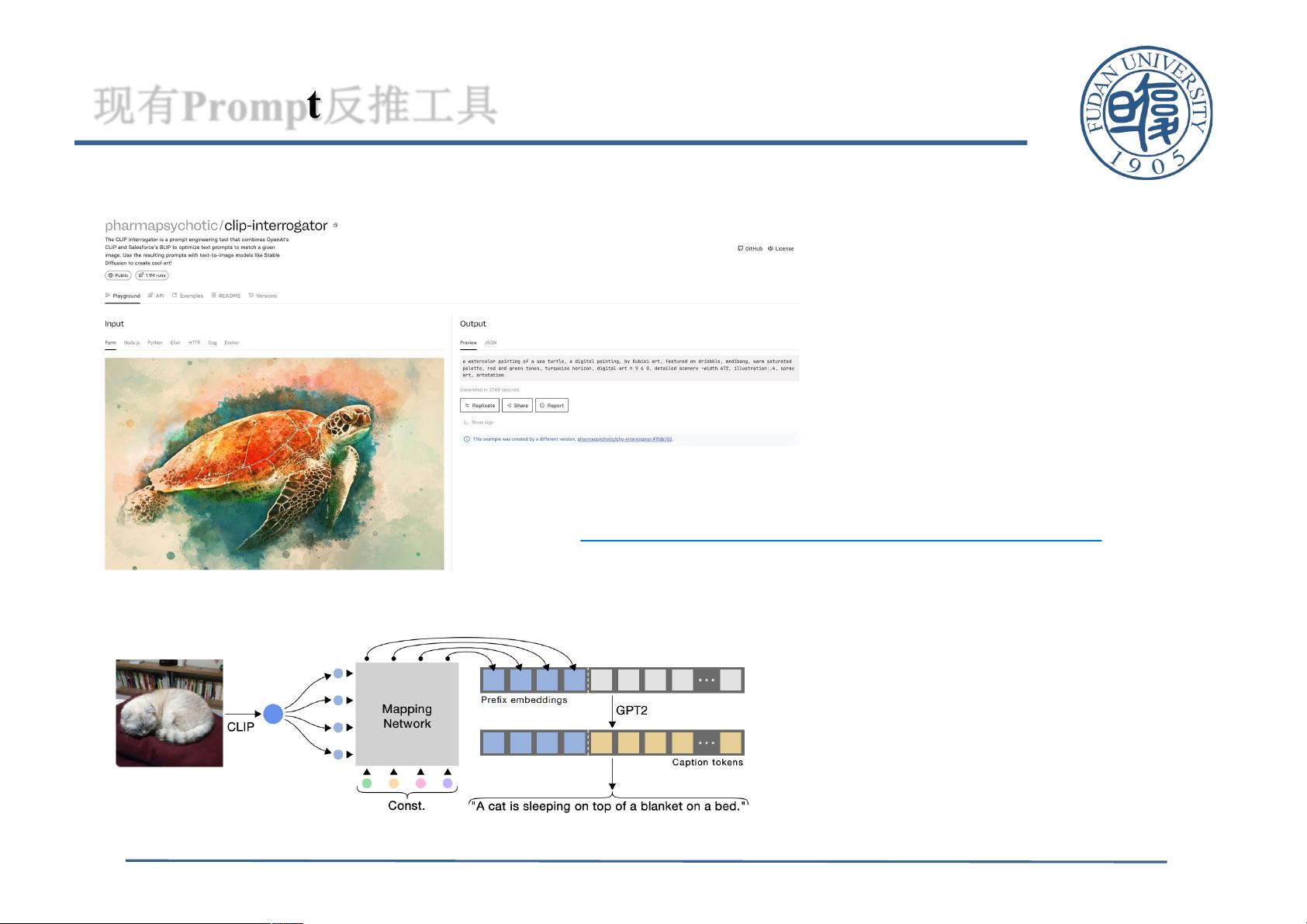

文献“PromptStealingAttacksAgainstText-to-ImageGenerationModels”探讨了针对文本到图像生成模型的Prompt窃取攻击,同时提出了Prompt保护策略。该研究强调了Prompt窃取的威胁,并展示了如何利用优化技术进行防御。

“HardPromptsMadeEasy”关注的是基于梯度的离散优化在Prompt调优和发现中的应用,该工作揭示了如何有效地窃取HardPrompt,并提供了防止此类攻击的方法。其开源代码库在GitHub上可供进一步研究和实践。

“PROPANE:Prompt设计作为一个逆问题”从逆向工程的角度探讨了Prompt的设计,提出了新的方法来理解并可能复制LLM的Prompt行为,这同样对Prompt的安全性提出了挑战。

“PromptsShouldnotbeSeenasSecrets”系统地测量了Prompt提取攻击的成功率,这项工作不仅揭示了Prompt窃取的可能性,还提出了评估和增强Prompt保护的框架。

最后,“PromptCARE-PromptCopyrightProtectionbyWatermarkInjectionandVerification”是关于Prompt版权保护的,通过水印注入和验证技术,为Prompt提供了一种防御机制。该研究的开源代码库提供了一个实际的Prompt保护解决方案。

这些文献共同构成了一个全面的视角,从攻击和防御两方面揭示了Prompt窃取的问题,并提出了相应的保护策略。随着AI技术的广泛应用,对于Prompt安全性的研究将成为未来的重要方向,以确保模型的隐私和知识产权得到保护。

2023-09-21 上传

2024-10-22 上传

2009-09-04 上传

2023-10-18 上传

2024-03-08 上传

2023-09-14 上传

2024-05-17 上传

2023-05-01 上传

_Meilinger_

- 粉丝: 855

- 资源: 21