Q-Learning算法在路径学习中的缺陷与优化

需积分: 0 41 浏览量

更新于2024-07-01

收藏 729KB PDF 举报

在本篇笔记中,作者深入探讨了Agent智能体算法中的Q-Learning算法在路径自主学习过程中的应用和挑战。Q-Learning作为一种强化学习的基础算法,其核心在于通过学习每个状态下采取不同动作的价值,以最大化长期回报。然而,算法存在一个关键缺陷,即“过高估计”问题,即在估计状态-动作对的价值时,可能会过分偏向于已经被采样过的状态和动作,而对未采样过的则可能低估。

作者使用Python编程语言,特别是TensorFlow和NumPy库,来实现Q-Learning的模拟,包括构建三维迷宫环境,以观察算法在实际路径规划中的表现。在模拟中,他们发现算法在处理动态变化的环境时,由于采样偏差导致的策略波动较为明显。为了解决这个问题,他们引入了ε-greedy策略,起初随机性较强,随着训练的进行逐渐降低,确保了在探索和利用策略之间的平衡。

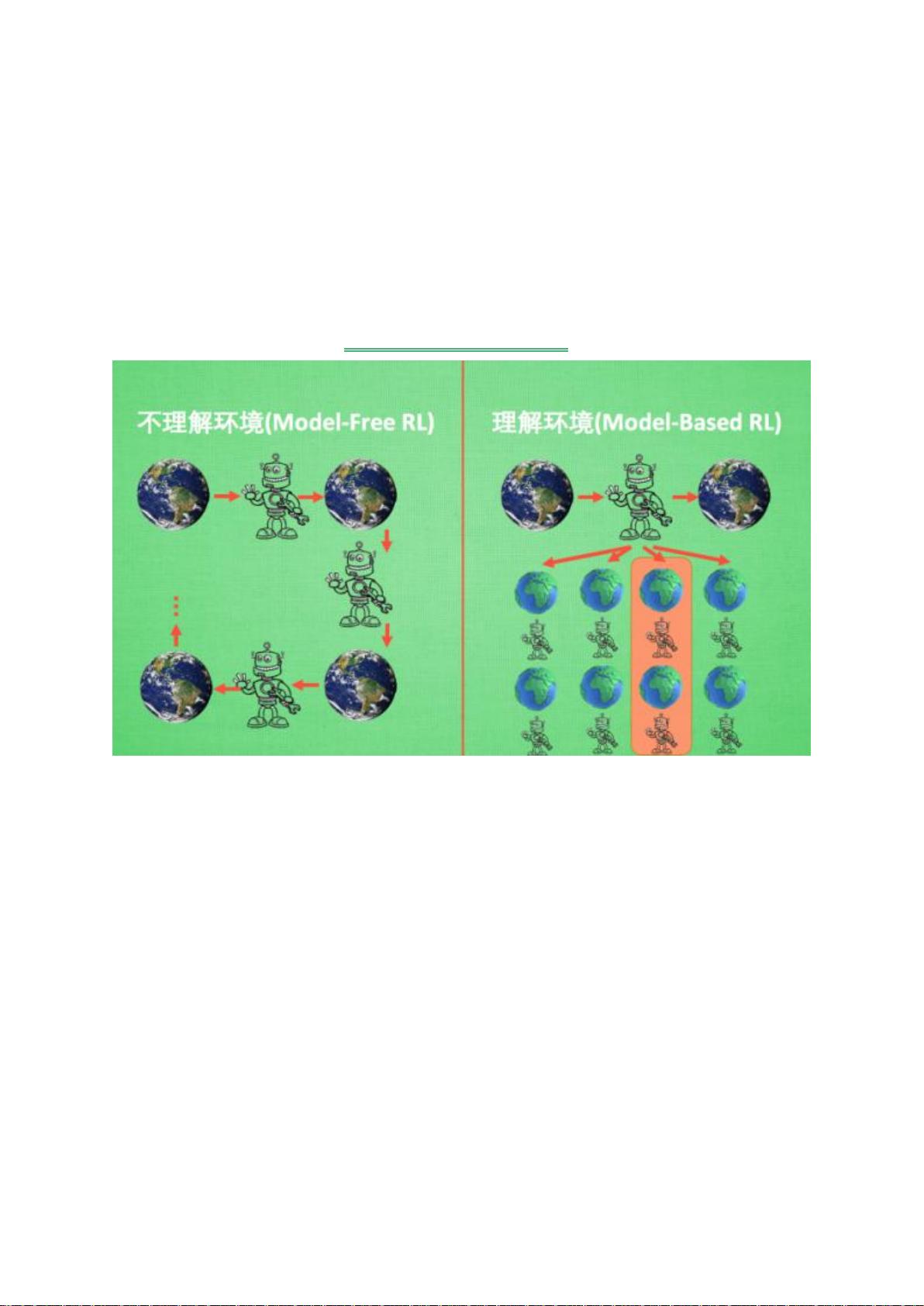

Q-Learning算法基于最优价值思想,依赖于交互序列中的信息来更新价值模型,这与价值迭代法有着相似之处。随着深度学习的发展,Q-Learning在某些领域取得了专家级的性能,但同时也暴露了其局限性,尤其是在环境复杂或部分信息不透明的情况下。

本研究的目标是通过调整参数,优化Q-Learning在特定场景下的表现,解决智能体如何在不能完全感知环境状态时做出有效决策的问题。作者关注的是智能体如何从环境变化中学习,并通过调整算法参数,使环境与动作选择之间的映射更加精确,以实现最佳的环境-动作迁移。

此外,作者还提到了SARSA算法与Q-Learning算法的区别,虽然两者都是基于Q表的算法,但在细节上可能存在不同的学习和更新策略。通过比较和分析,可以进一步提升算法的性能和稳定性。这篇笔记深入剖析了Q-Learning算法的内在机制,挑战,以及在路径自主学习中的应用优化策略,为相关领域的研究者提供了有价值的参考。

2023-11-07 上传

2021-05-24 上传

2021-03-22 上传

2015-07-16 上传

2021-04-26 上传

2021-03-14 上传

已收录资源合集

已收录资源合集