服务器日志数据分析:初步探索与清理

需积分: 0 188 浏览量

更新于2024-08-05

收藏 587KB PDF 举报

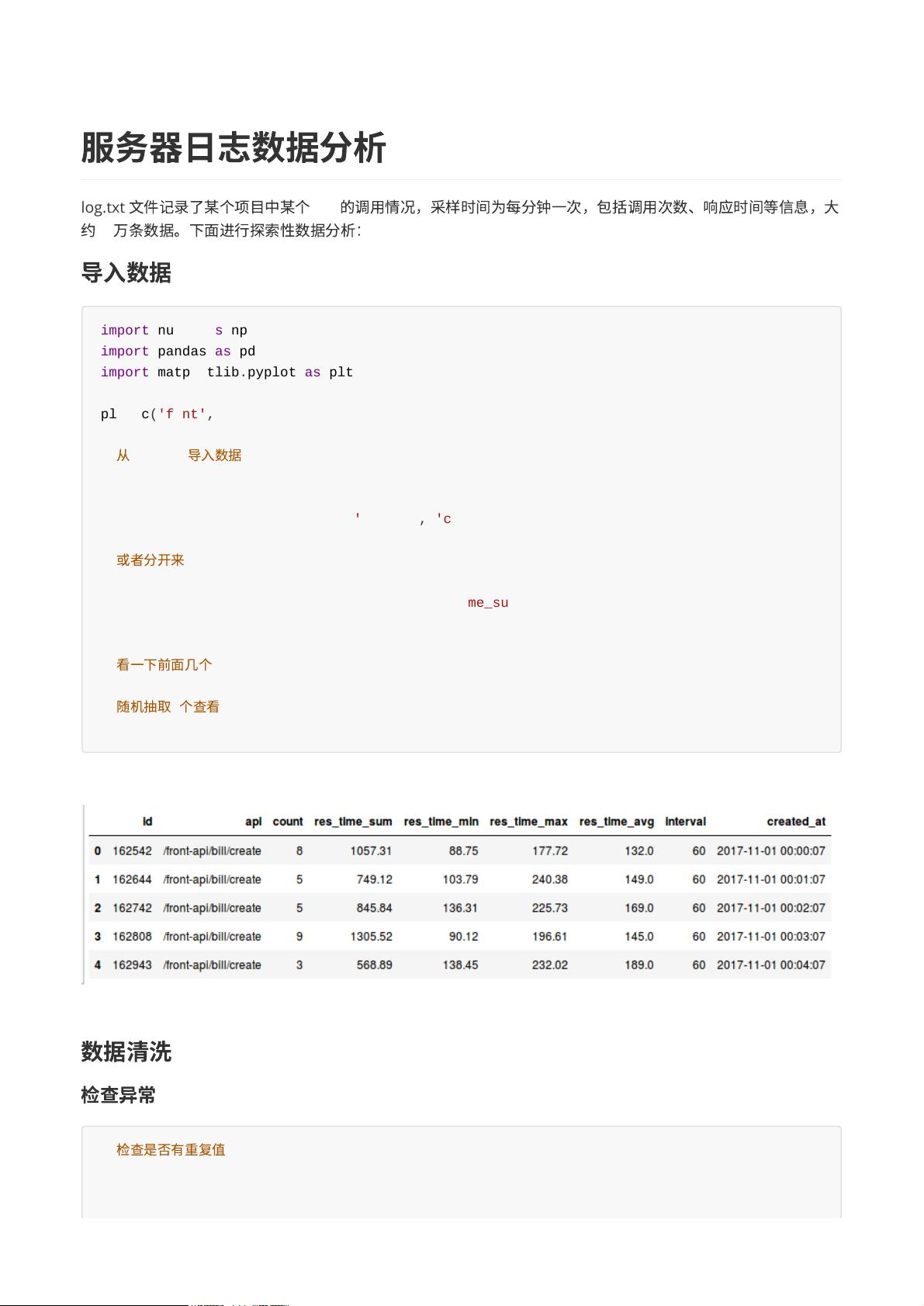

"这篇文档是关于如何对一个包含服务器API调用信息的日志文件`log.txt`进行初步的数据分析。日志文件记录了特定API在每分钟内的调用次数、响应时间等相关数据,总计约18万条记录。文档主要使用Python的数据分析库Pandas和可视化库Matplotlib进行分析,并涉及数据清洗、异常检测、时间序列处理以及无用列的删除等步骤。"

在服务器日志数据分析中,有几个关键的知识点值得深入探讨:

1. **数据导入与预处理**:首先,使用`pd.read_table()`函数从`log.txt`文件中读取数据,通过设置`header=None`和`names`参数来指定列名。在导入数据后,可以使用`data.head()`查看数据的前几行,`data.sample(5)`随机抽取样例,以了解数据的基本结构。

2. **数据清洗**:通过`data.duplicated().sum()`检查数据中的重复行,确保数据的唯一性。此外,使用`data.isnull().sum()`检查缺失值,确保数据的完整性。

3. **时间序列分析**:将`created_at`列作为时间索引,便于后续的时间序列分析。这可以通过设置`pd.to_datetime()`函数将该列转换为日期时间类型,然后将其设为DataFrame的索引。

4. **列选择与分析**:分析`api`和`interval`列的有效性。发现在本数据集中,`api`列只有一个唯一值,这意味着它对分析没有贡献,可以使用`drop()`函数将其删除。同样,`interval`列的值全部为60,可能表示每分钟的采样间隔,但在这种情况下,这个信息对于当前分析并无额外价值,也可以一并删除。

5. **数据探索**:使用`describe()`函数可以快速获取`api`列的基本统计信息,如唯一值的数量,从而确定其是否具有分析价值。对于其他数值型列,例如`count`、`res_time_sum`、`res_time_min`、`res_time_max`、`res_time_avg`,可以使用类似的方法进行描述性统计分析,了解数据的分布、中心趋势和波动范围。

6. **可视化**:使用`matplotlib.pyplot`库进行数据可视化,例如绘制直方图、箱线图或折线图,可以帮助我们更好地理解数据的分布和趋势,例如调用次数随时间的变化、响应时间的分布等。

7. **异常检测**:对于响应时间和调用次数等可能存在的异常值,可以使用统计方法(如Z-score或IQR方法)进行识别,并决定是否剔除这些异常值,以保证分析结果的准确性。

8. **数据建模与预测**:在完成以上基础分析后,可以进一步对数据进行建模,例如使用时间序列模型(如ARIMA、State Space Models等)预测未来的API调用量或响应时间,以便于优化服务器性能或提前预测可能出现的问题。

9. **效率优化**:对于大量数据,考虑使用数据分块或并行处理技术,提高分析效率。例如,可以使用Pandas的`chunksize`参数分批读取大文件,或者利用Dask等分布式计算库进行大规模数据处理。

通过上述步骤,我们可以对服务器日志数据进行深度分析,提取有价值的信息,以支持系统优化、性能监控和故障排查等工作。

378 浏览量

2008-09-29 上传

2019-01-09 上传

2023-02-06 上传

2023-05-16 上传

2024-04-23 上传

2023-06-09 上传

2024-05-06 上传

2023-05-24 上传

UEgood雪姐姐

- 粉丝: 43

- 资源: 319

最新资源

- 深入浅出:自定义 Grunt 任务的实践指南

- 网络物理突变工具的多点路径规划实现与分析

- multifeed: 实现多作者间的超核心共享与同步技术

- C++商品交易系统实习项目详细要求

- macOS系统Python模块whl包安装教程

- 掌握fullstackJS:构建React框架与快速开发应用

- React-Purify: 实现React组件纯净方法的工具介绍

- deck.js:构建现代HTML演示的JavaScript库

- nunn:现代C++17实现的机器学习库开源项目

- Python安装包 Acquisition-4.12-cp35-cp35m-win_amd64.whl.zip 使用说明

- Amaranthus-tuberculatus基因组分析脚本集

- Ubuntu 12.04下Realtek RTL8821AE驱动的向后移植指南

- 掌握Jest环境下的最新jsdom功能

- CAGI Toolkit:开源Asterisk PBX的AGI应用开发

- MyDropDemo: 体验QGraphicsView的拖放功能

- 远程FPGA平台上的Quartus II17.1 LCD色块闪烁现象解析