Python爬虫基础:requests模块与HTTP请求详解

101 浏览量

更新于2024-08-31

收藏 225KB PDF 举报

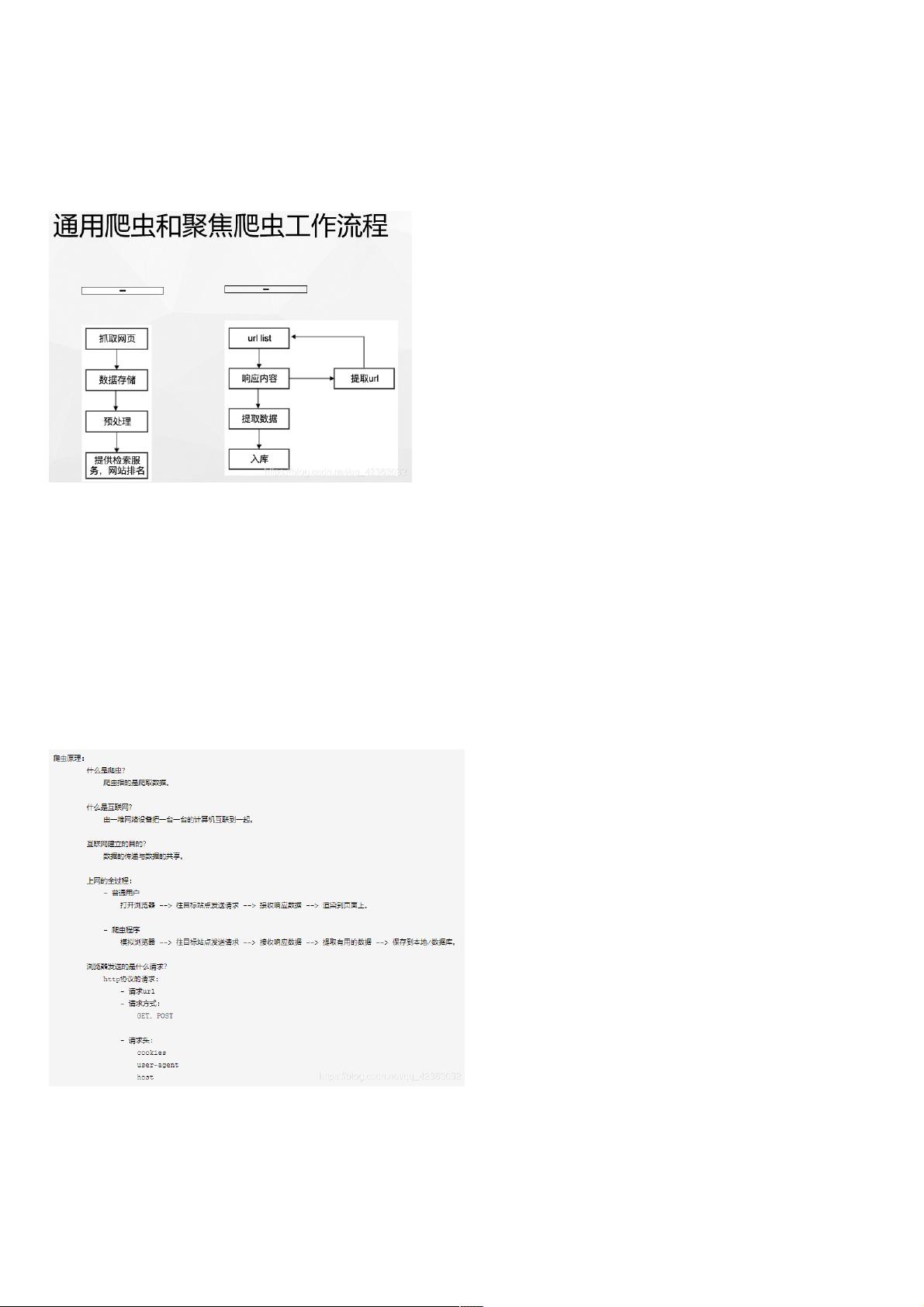

本文主要介绍了Python爬虫中的requests库的使用,探讨了爬虫的基本概念,包括通用爬虫和聚焦爬虫的区别,并提到了通用爬虫的局限性以及robots协议。此外,还讲解了HTTP与HTTPS协议的区别以及GET请求的实现。

在Python爬虫领域,requests是一个非常重要的库,它允许我们模拟浏览器发送网络请求并接收响应。文章首先介绍了爬虫的基本定义,即爬虫是一种自动抓取互联网信息的程序,它可以模拟客户端的行为。通用爬虫广泛用于搜索引擎,如百度、谷歌等,它们抓取大量网页并保存本地以构建互联网内容的镜像。而聚焦爬虫则针对特定需求,只抓取与目标相关的信息。

通用爬虫存在一些局限性,比如大部分搜索结果可能对用户无用,且无法处理多媒体内容,如图片、音频和视频。同时,通用搜索引擎无法根据每个用户的个性化需求提供定制化的搜索结果。此外,robots协议是网站用来指示搜索引擎哪些页面可以抓取、哪些禁止抓取的规则,尽管不具备法律效力,但它在业界被广泛接受和遵循。

接着,文章介绍了HTTP和HTTPS协议。HTTP是超文本传输协议,主要用于网页传输,而HTTPS是在HTTP基础上增加了SSL/TLS加密,增强了数据传输的安全性。它们默认使用的端口号分别为80和443。

然后,通过一个简单的示例展示了如何使用requests库发送GET请求。通过设置User-Agent头来模拟浏览器,向指定URL(例如百度首页)发送请求,并获取响应。响应内容可以是文本或二进制,如下载百度首页的logo,可以通过获取响应的content属性,进一步处理或保存为文件。

Python爬虫之requests的使用涵盖了爬虫的基础知识、HTTP协议的理解以及requests库的实战应用,对于初学者来说是很好的入门教程。通过学习这部分内容,开发者能够理解爬虫的基本原理,并具备使用requests进行简单网络爬虫开发的能力。

120 浏览量

2401 浏览量

364 浏览量

732 浏览量

803 浏览量

1424 浏览量

1610 浏览量

1339 浏览量

944 浏览量

weixin_38576229

- 粉丝: 5

- 资源: 901

最新资源

- ShopXO免费开源商城 v2.2.0稳定版本

- 易语言学习-SWF制作支持库1.1(静态版).zip

- RangeBlack

- barcode-pda.rar

- It-s-Nothing:我什么都没告诉你

- 消息app相关图标 .fig素材下载

- boostrap-alerts:简单的Meteor JS boostrap警报-在https上查看

- analyzer-ik-7.4.0.zip

- 行业文档-设计装置-一种剑杆上轴轴盘固定装置.zip

- PixetlHard

- 易语言学习-超级加解密支持库1.0#3(08.11.1).zip

- 剧集:使用django,bootstrap4构建的自托管电视节目剧集跟踪器和推荐器

- calculator:这是一个简单的计算器

- tailwind-cinema:使用NEXT.js和Tailwind CSS设计的影片选择器界面

- login_demo_gin.rar

- ballReflection