Windows IIS6+PHP5+MySQL5+Zend_Optimizer+phpMyAdmin 完整配置教程

需积分: 10 12 浏览量

更新于2024-07-31

收藏 3.3MB DOC 举报

本教程详细介绍了如何在Windows Server 2003 R2 Enterprise Edition SP2 x86版本系统上安装和配置一个功能强大的Web开发环境,包括IIS6(Internet Information Services 6)、PHP5、MySQL5、Zend_Optimizer以及phpMyAdmin。以下是关键步骤和所需软件的概述:

1. **准备工作**:

- 操作系统:确保使用的是Windows x86版本,如Windows Server 2003 R2 Enterprise Edition SP2。

- 软件版本:选择最新的PHP版本,这里推荐PHP5.2.8,可以从官方网站下载ZIP压缩包,MD5校验码为71511834881753ea0906f2bca91632b9;MySQL推荐的是5.0.67的Windows版本,MD5校验码为ed76e5ad8b251ca643766c70926854d7。

2. **下载与安装**:

- PHP:访问http://www.php.net/downloads.php获取最新版本的PHP5.2.8 ZIP包,或直接从指定链接下载。安装时需使用管理员权限。

- MySQL:访问http://dev.mysql.com/downloads/mysql/5.0.html#win32 获取MySQL5.0.67的Windows ZIP版本,同样推荐使用管理员权限安装。

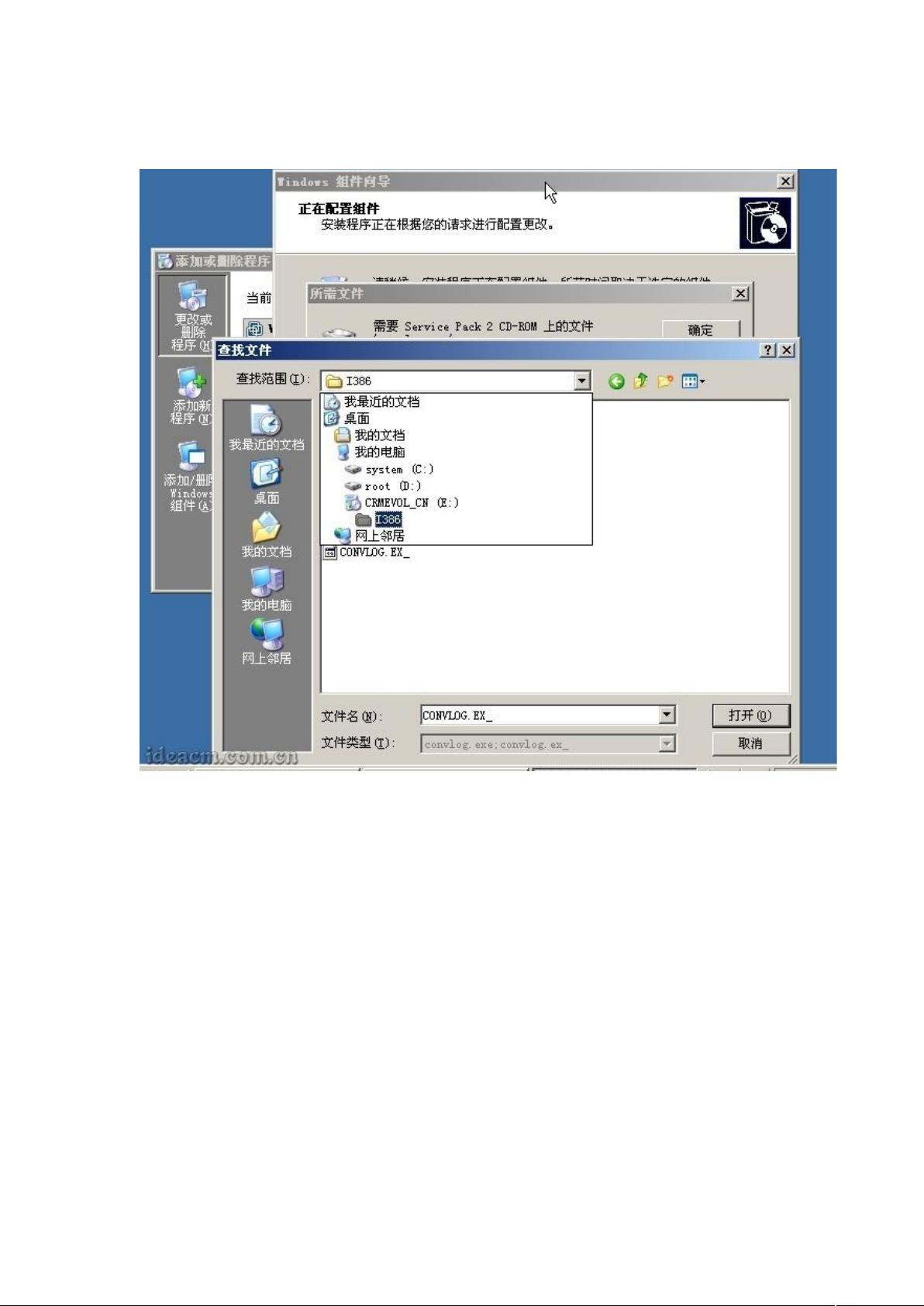

3. **安装配置**:

- 安装PHP:将下载的PHP压缩包解压后,根据安装向导进行安装,确保设置好PHP的执行路径和环境变量。

- 安装MySQL:下载的MySQL安装程序会自动配置环境变量,并提供图形界面安装,按照提示完成安装。

- Zend_Optimizer:虽然没有直接提及,但通常情况下,为了提升PHP性能,会在PHP安装过程中或之后安装Zend Optimizer,这是一个PHP扩展,用于代码优化。

- phpMyAdmin:作为数据库管理工具,可以去官方网站或其他可信来源下载phpMyAdmin的Windows版本,然后将其集成到IIS中或者单独部署。

4. **集成与配置**:

- 将phpMyAdmin集成到IIS6:将phpMyAdmin文件夹放置在合适的Web目录下,配置IIS中的虚拟主机,设置相应的PHP处理程序映射。

- 配置IIS:在IIS管理器中,可能需要创建新的网站或应用程序池,并调整其属性以支持PHP运行,包括添加PHP模块和设置路径等。

5. **验证与备份**:

- 在配置完成后,通过浏览器访问测试网站或phpMyAdmin,确认所有组件是否正常工作。

- 为了保障数据安全,建议定期备份MySQL数据库和重要配置文件。

由于篇幅有限,本文只概述了安装和配置的基本流程,实际操作中可能需要根据具体情况进行更详细的设置和调整。在整个过程中,确保使用管理员权限以充分授权,同时注意检查每个步骤的细节,以确保环境的稳定和高效运行。

2011-02-16 上传

2023-03-11 上传

2023-03-11 上传

点击了解资源详情

2011-11-05 上传

2009-09-04 上传

2020-09-30 上传

2014-03-18 上传

点击了解资源详情

2024-12-25 上传

zys6024

- 粉丝: 0

- 资源: 3

最新资源

- PIEROutil:PIERO的AR客户端库(http

- terraform-courses

- bender:JIRA微管理助手

- phywcri,c语言曲线拟合源码下载,c语言

- PersonAttributeExt:人物属性提取

- 基于JAVA图书馆座位预约管理系统计算机毕业设计源码+数据库+lw文档+系统+部署

- poordub:可怜的人的PyDub

- system-simulation:使用 networkx python 库在图上模拟医院位置

- 4411513,socket源码c语言,c语言

- 52挂Q v1.3

- app-status

- srpagotest

- kettle的web版本,自己编译的war包,直接放到tomcat下运行,然后http://localhost:8080/web

- Ksdacllp-Backend:Ksdacllp后端

- chromedriver-linux64-V124.0.6367.91 稳定版

- php-pdf-filler