循环神经网络与门控机制在序列模型中的应用

需积分: 0 83 浏览量

更新于2024-08-05

收藏 2.34MB PDF 举报

"本资源为第五课的序列模型1,主要介绍了循环神经网络(RNN)及其应用领域,包括门控循环单元(GRU)和长短期记忆网络(LSTM)。课程强调了RNN在处理序列数据时的重要性,特别是在解决梯度消失或梯度爆炸问题上的局限性,以及GRU和LSTM如何通过门控机制改善这一问题。"

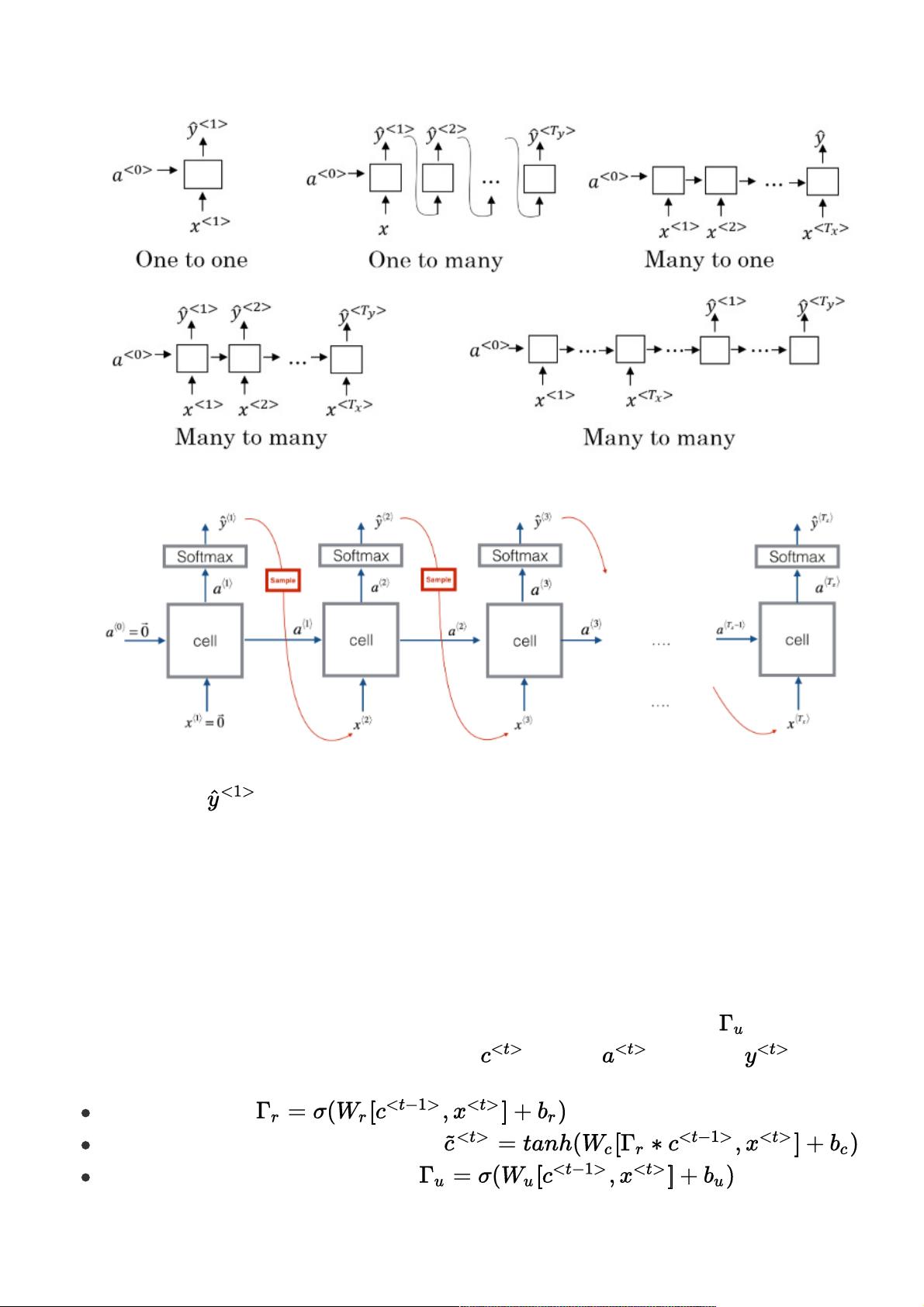

在深度学习领域,序列模型是处理时间序列数据或具有顺序依赖性的数据的关键工具。循环神经网络(RNN)作为一种特殊的神经网络结构,广泛应用于诸如语音识别、音乐生成、文本情感分析、DNA序列分析、机器翻译、视频动作识别和命名实体识别等任务。RNN的特点在于其循环结构,允许信息在时间维度上传播,每个时间节点的隐藏状态不仅取决于当前输入,还依赖于前一时刻的隐藏状态。

时间序列的表示在RNN中至关重要。给定一个特征序列x或标签序列y,每个元素表示为xt或yt,且每个样本数据的第t个元素用xt(i)表示。RNN的前向传播过程中,隐藏层在每个时间节点接收当前输入和上一时刻的激活结果,并可能产生输出。权重矩阵如Wxh、Whh和Wy在所有时间节点上共享,简化了模型并允许参数的有效利用。

然而,标准RNN在处理长距离依赖时存在困难,这通常归因于梯度消失或梯度爆炸的问题。为了解决这一挑战,出现了门控循环单元(GRU)。GRU通过更新门和重置门来控制信息的流动,从而更好地捕获长期依赖。记忆细胞c的计算结合了旧的记忆和新的输入,而更新门和重置门则分别控制记忆的保留和遗忘。

LSTM(长短时记忆网络)是另一种流行的序列模型,它进一步扩展了门控概念,包括输入门、遗忘门和输出门。这些门独立控制信息的添加、删除和传递,增强了网络处理长期依赖的能力,使得LSTM在许多序列任务中表现出色。

RNN、GRU和LSTM是深度学习中处理序列数据的强大工具,它们通过不同的门控机制解决了传统RNN的局限性,从而在自然语言处理、音频处理和生物信息学等领域发挥了重要作用。理解并掌握这些模型的原理和应用,对于任何从事相关工作的AI专家来说都是至关重要的。

2022-08-04 上传

2022-08-04 上传

2020-01-30 上传

2018-10-19 上传

2019-04-21 上传

2018-04-12 上传

白小俗

- 粉丝: 37

- 资源: 302

最新资源

- 网络常用net命令小全

- 10个verilog学习设计实践.pdf

- Modeling the Internet and the Web

- 基于DSP的PWM型开关电源的设计

- PCI9054笔记 PCI9054笔记 PCI9054笔记 PCI9054笔记

- Linux内核情景分析(清晰版)

- VISUAL C++MFC编程实例part 04

- PPT使用技巧(动作设置、超链接)

- 程序开发代码规范手册

- VISUAL C++MFC编程实例part 03

- VISUAL C++MFC编程实例part 02

- VHDL入门 VHDL入门 VHDL入门 VHDL入门

- VISUAL C++MFC编程实例part 01

- C案例分析-开发综合程序~~

- Request对象和乱码解决.doc

- 让你不再害怕指针!!!!!