Ceph数据流详解:从客户端到存储层的深度剖析

需积分: 0 75 浏览量

更新于2024-08-04

收藏 509KB PPTX 举报

"Ceph数据流分析知识"

Ceph是一个开源的分布式存储系统,它提供了对象存储、块存储和文件系统的功能。在Ceph中,数据流的处理涉及到多个组件和层次,从客户端到集群,再到 OSD (Object Storage Daemon) 和 BlueStore。下面我们将详细解析这些流程。

1. **客户端到Ceph集群**:

客户端通过RadosGW(对象存储接口)、RBD(块设备接口)或CephFS(文件系统接口)与Ceph集群交互。请求首先被路由到集群的MDS(Metadata Server)进行元数据操作,然后根据数据的位置定位到相应的OSD。

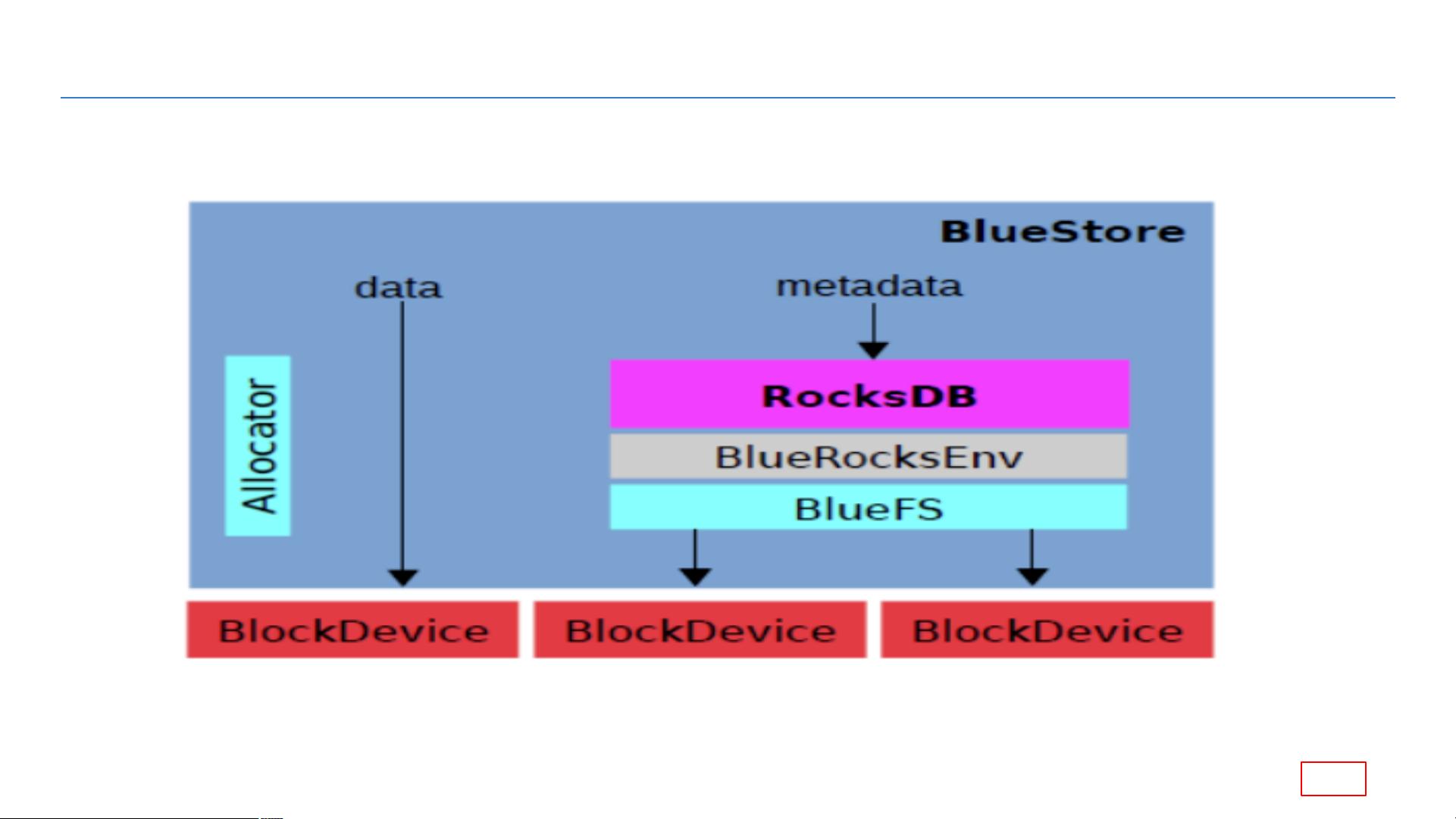

2. **BlueStore到Block Device**:

BlueStore是Ceph的一种存储后端,它直接将数据写入底层的Block Device,如硬盘或SSD。在BlueStore中,数据流的处理始于`queue_transactions`,它负责将读写任务放入事务队列。接着,`_txc_add_transaction`将事务添加到待处理列表。当事务准备好执行时,`_write`函数会被调用,进一步分为 `_do_write`,此阶段会根据数据大小选择`_do_write_small`或`_do_write_big`进行写入操作。`_do_alloc_write`负责实际的数据分配和写入,调用`BlockDevice::aio_write`异步地将数据写入底层存储设备。

3. **OSD到BlueStore**:

OSD是Ceph存储集群的核心组件,它负责数据的存储和管理。当数据从集群流向OSD时,`ms_fast_dispatch`函数首先接收并分发操作。`dispatch_session_waiting`调度等待处理的会话,然后`enqueue_op`将操作放入队列。接下来,`dequeue_op`取出操作,交由`PrimaryLogPG`处理。`PrimaryLogPG`一系列的方法,如`do_request`、`do_op`、`find_object_context`、`get_object_context`、`execute_ctx`等,确保数据的正确性和一致性。在`prepare_transaction`和`OpContext::start_async_reads`中,OSD开始准备交易并启动异步读取。当读取完成,`complete_read_ctx`和后续方法完成读取上下文的处理。

4. **OSD之间的通信**:

Ceph使用CRUSH(Controlled Replication Under Scalable Hashing)算法来决定数据的分布和复制策略。当数据写入OSD时,副本可能会被同步到其他OSD,这涉及到OSD之间的通信和数据流。

5. **数据流优化**:

Ceph使用了各种优化技术,如AIO(Asynchronous I/O)以提高性能,以及多线程和并发处理,以确保数据的高效流动。

通过理解Ceph数据流的这些层面,我们可以更好地优化存储性能、监控系统状态,并在出现问题时进行有效的故障排查。Ceph的这种设计使得它成为一个强大且灵活的存储解决方案,能够处理大规模的分布式数据存储需求。

2021-10-13 上传

2021-10-12 上传

2016-11-09 上传

2024-04-25 上传

2024-05-19 上传

2024-05-22 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

slhywll

- 粉丝: 307

- 资源: 6

最新资源

- JavaScript实现的高效pomodoro时钟教程

- CMake 3.25.3版本发布:程序员必备构建工具

- 直流无刷电机控制技术项目源码集合

- Ak Kamal电子安全客户端加载器-CRX插件介绍

- 揭露流氓软件:月息背后的秘密

- 京东自动抢购茅台脚本指南:如何设置eid与fp参数

- 动态格式化Matlab轴刻度标签 - ticklabelformat实用教程

- DSTUHack2021后端接口与Go语言实现解析

- CMake 3.25.2版本Linux软件包发布

- Node.js网络数据抓取技术深入解析

- QRSorteios-crx扩展:优化税务文件扫描流程

- 掌握JavaScript中的算法技巧

- Rails+React打造MF员工租房解决方案

- Utsanjan:自学成才的UI/UX设计师与技术博客作者

- CMake 3.25.2版本发布,支持Windows x86_64架构

- AR_RENTAL平台:HTML技术在增强现实领域的应用