南京大学MapReduce实验:大数据join操作与Hive应用

需积分: 0 52 浏览量

更新于2024-08-05

收藏 609KB PDF 举报

本资源是一份关于大数据处理的综合实验——MapReduce在南京大学计算机科学与技术系的课程实践中介绍。实验名称为"实验31:MyJoin",其目标是让学生掌握如何利用MapReduce并行计算框架对两个文本文件(order.txt和product.txt)进行join操作,然后将结果存储到Hadoop分布式文件系统(HDFS)上,并进一步通过Hive进行数据处理。

实验内容及要求:

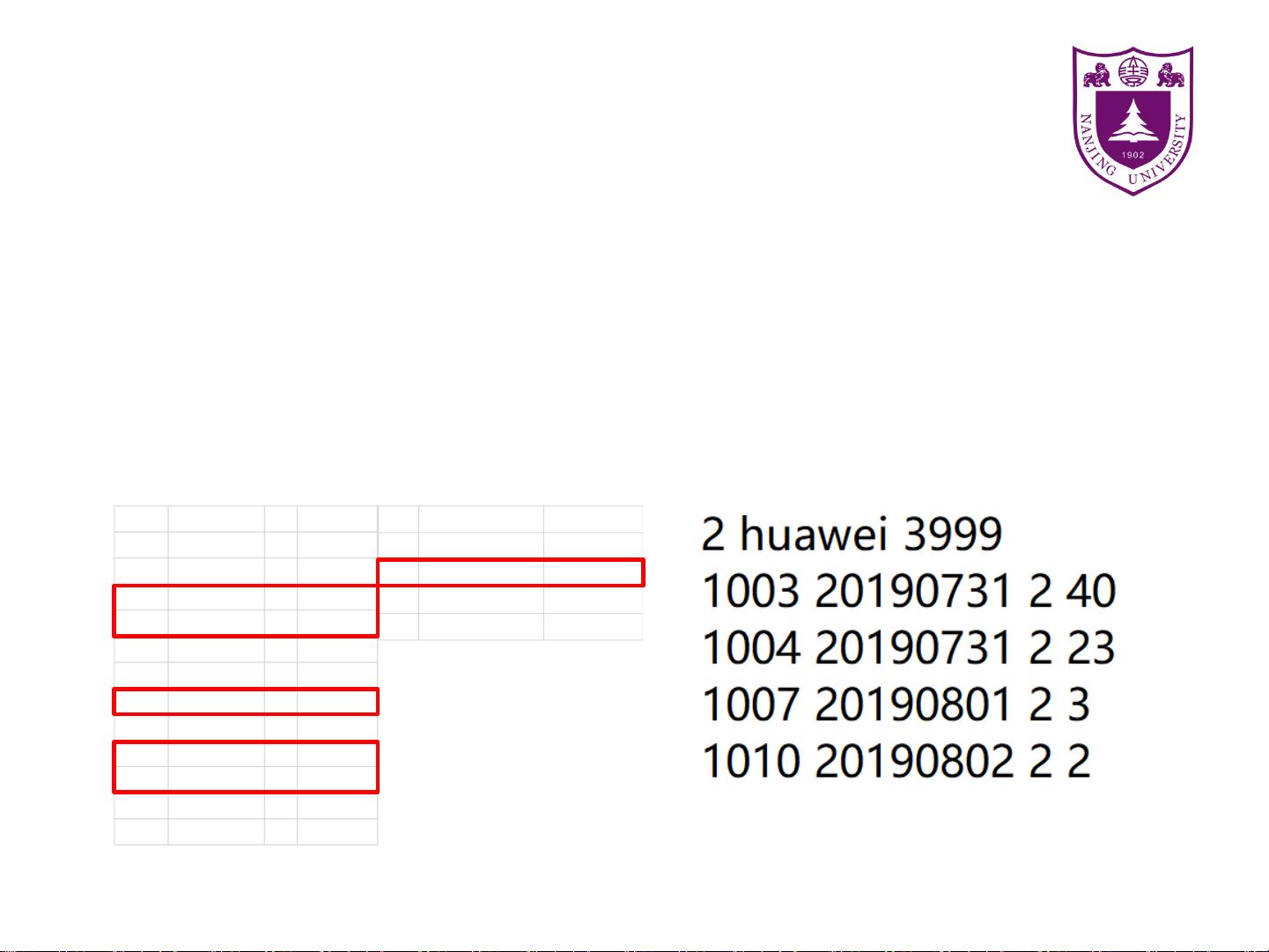

1. **MapReduce操作**:学生需要使用MapReduce模型对order.txt和product.txt中的数据进行处理。order.txt包含订单信息,如oid、odata、pid、pname、price和oamount,而product.txt则包含产品信息,如pid、pname和price。实验的核心任务是将两个文件按照pid键值对进行关联,即将订单信息与对应的产品信息合并。

2. **数据封装**:在这个过程中,学生需要设计一个名为OrderBean的数据结构,用于封装order.txt中的每个订单记录,包括oid、odata、pid、pname、price和oamount字段。

3. **join操作**:在Mapper阶段,map函数将读取order.txt中的数据,通过oid查找product.txt中的相应产品信息,然后输出键值对(如(order.pid, OrderBean实例))。Reducer阶段会接收这些键值对,聚合具有相同pid的订单信息和产品信息。

4. **结果输出**:join操作完成后,结果数据将被写入HDFS,以便后续使用。

5. **Hive操作**:实验还涉及使用Hive对处理后的数据进行操作,包括创建表和执行SQL查询。例如,学生需要编写SQL语句(如`SELECT * from order LEFT JOIN product WHERE order.pid = product.id`)来查询合并后的数据,显示oid、pname、price等字段。

6. **设计思路**:整个实验的设计思路围绕着如何利用MapReduce的分布式处理能力,通过分治策略,将大文件拆分成小块在集群节点上并行处理,最后在Reducer阶段汇总结果。同时,通过Hive的SQL查询,展示了数据仓库和数据分析的基本应用。

这个实验不仅要求学生理解MapReduce的工作原理和模式,还涵盖了大数据处理中的数据整合、查询优化以及Hadoop生态系统中其他组件的使用,对于提升学生的实际操作能力和理论知识有重要作用。

2022-06-05 上传

2022-08-08 上传

2021-11-18 上传

2009-09-04 上传

2021-09-16 上传

2021-10-29 上传

2022-11-05 上传

2021-08-14 上传

2021-10-24 上传

莉雯Liwen

- 粉丝: 29

- 资源: 305

最新资源

- 单片机串口通信仿真与代码实现详解

- LVGL GUI-Guider工具:设计并仿真LVGL界面

- Unity3D魔幻风格游戏UI界面与按钮图标素材详解

- MFC VC++实现串口温度数据显示源代码分析

- JEE培训项目:jee-todolist深度解析

- 74LS138译码器在单片机应用中的实现方法

- Android平台的动物象棋游戏应用开发

- C++系统测试项目:毕业设计与课程实践指南

- WZYAVPlayer:一个适用于iOS的视频播放控件

- ASP实现校园学生信息在线管理系统设计与实践

- 使用node-webkit和AngularJS打造跨平台桌面应用

- C#实现递归绘制圆形的探索

- C++语言项目开发:烟花效果动画实现

- 高效子网掩码计算器:网络工具中的必备应用

- 用Django构建个人博客网站的学习之旅

- SpringBoot微服务搭建与Spring Cloud实践