本地部署开源大模型的完整教程:LangChain、Streamlit、LLAMA

需积分: 5 141 浏览量

更新于2024-01-26

13

收藏 1.98MB DOCX 举报

本文介绍了一种本地部署开源大模型的完整教程,该教程使用了LangChain和Streamlit Llama两个工具。大型语言模型(llm)近几个月来备受关注,这些模型具有巨大的潜力,尤其对于聊天机器人、个人助理和内容创作的开发人员来说。大型语言模型能够生成与人类语言非常相似的文本,并且能够自然理解输入的提示。它们通过使用广泛的数据集进行训练,包括书籍、文章、网站等来源。通过分析这些数据中的统计模式,LLM能够预测最可能出现的单词或短语。

在这个教程中,作者首先介绍了LangChain这个令人印象深刻且免费的框架。LangChain能够无缝链接来自多个模块的组件,使用大部分的LLM来创建应用程序。LangChain广泛应用于聊天机器人、生成式问答(GQA)和摘要等领域。

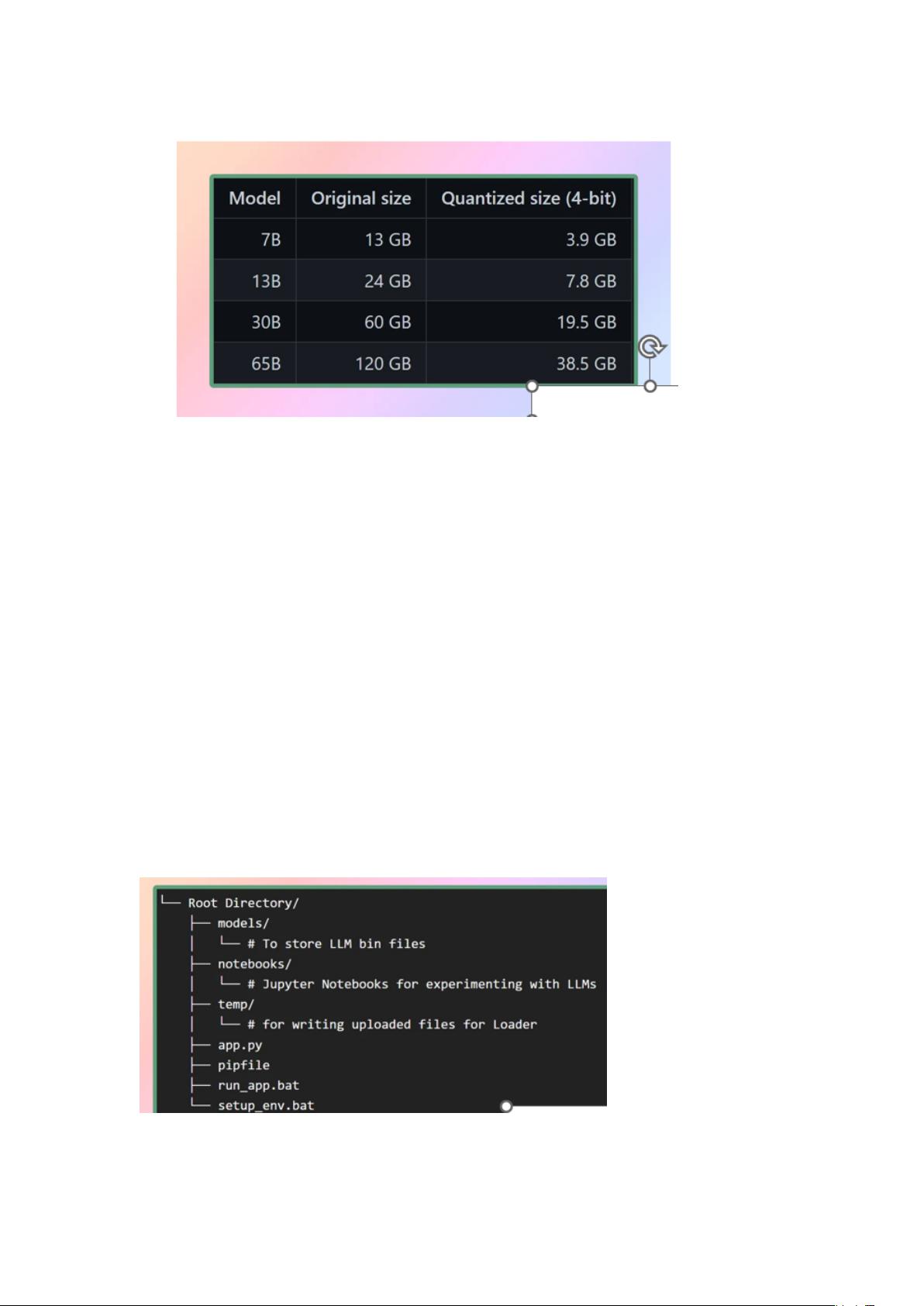

接下来,作者介绍了LLaMA这个由Facebook的母公司Meta AI设计的新型大型语言模型。LLaMA拥有70亿到650亿个参数的模型集合,是目前最全面的语言模型之一。在2023年2月24日,Meta向公众发布了LLaMA模型,并展示了他们对开放科学的奉献。

根据这个教程的描述,首先,你需要将LangChain和Streamlit Llama这两个工具下载到本地的开发环境中。然后,按照教程的指导,安装和配置这些工具,确保它们能够正常运行。

在安装和配置完成后,你需要准备训练LLM所需的数据集。这些数据集可以包括各种来源,如书籍、文章和网站。你需要将这些数据集导入到LangChain中,并进行预处理和清理,以便能够用于LLM的训练。

接下来,你可以使用LangChain的组件来构建LLM应用程序。通过组合不同的组件,你可以创建各种不同类型的应用程序,如聊天机器人、生成式问答系统和摘要生成器。LangChain提供了一套易于使用的API,使得构建这些应用程序变得简单和高效。

最后,你可以使用Streamlit Llama来部署和展示你的LLM应用程序。Streamlit Llama是一个用于构建Web应用程序的工具,它能够将你的应用程序快速部署到云端,并提供友好的用户界面。

总之,通过本地部署开源大模型的完整教程LangChain和Streamlit Llama,你将能够轻松地创建和部署各种类型的应用程序。这些应用程序可以用于聊天机器人、生成式问答系统、摘要生成器等领域,为开发人员提供了强大的工具和技术支持。

2023-09-19 上传

点击了解资源详情

点击了解资源详情

2024-01-25 上传

130 浏览量

点击了解资源详情

2024-12-26 上传

缘分天空

- 粉丝: 6

- 资源: 24

最新资源

- csharpjkmemoty,c#简单mssql线程池+异步socket服务端完整源码,c#

- subclass-dance-party

- ExiFlow-开源

- Pre-2020 Google Icons-crx插件

- recipe-book:格雷格和艾莉的食谱书(v4)

- weekly_u3etas

- nCode,c#教材订购系统源码,c#

- chatterbox-client

- Wikiquote (ES)-crx插件

- 实时股票查看器:绘制和分析来自彭博或雅虎的实时市场数据。-matlab开发

- 物资管理系统项目源码.zip

- EqualitySpad.t9qmko61wz.gaF8I5O

- React横幅制作者

- I-Need-a-Hero

- main-form,c#如何将源码生成dll,c#

- investment-app:决定投资计划之前要问的问题