Kubernetes云原生实践:RBD与CephFS存储系统详解与操作

版权申诉

93 浏览量

更新于2024-08-06

收藏 920KB PDF 举报

在云原生技术的发展中,Kubernetes作为容器编排的核心组件,其平台存储系统对于实现高效、弹性的应用部署至关重要。本文档深入探讨了在Kubernetes环境中使用云原生方式管理块存储和文件存储的最佳实践。

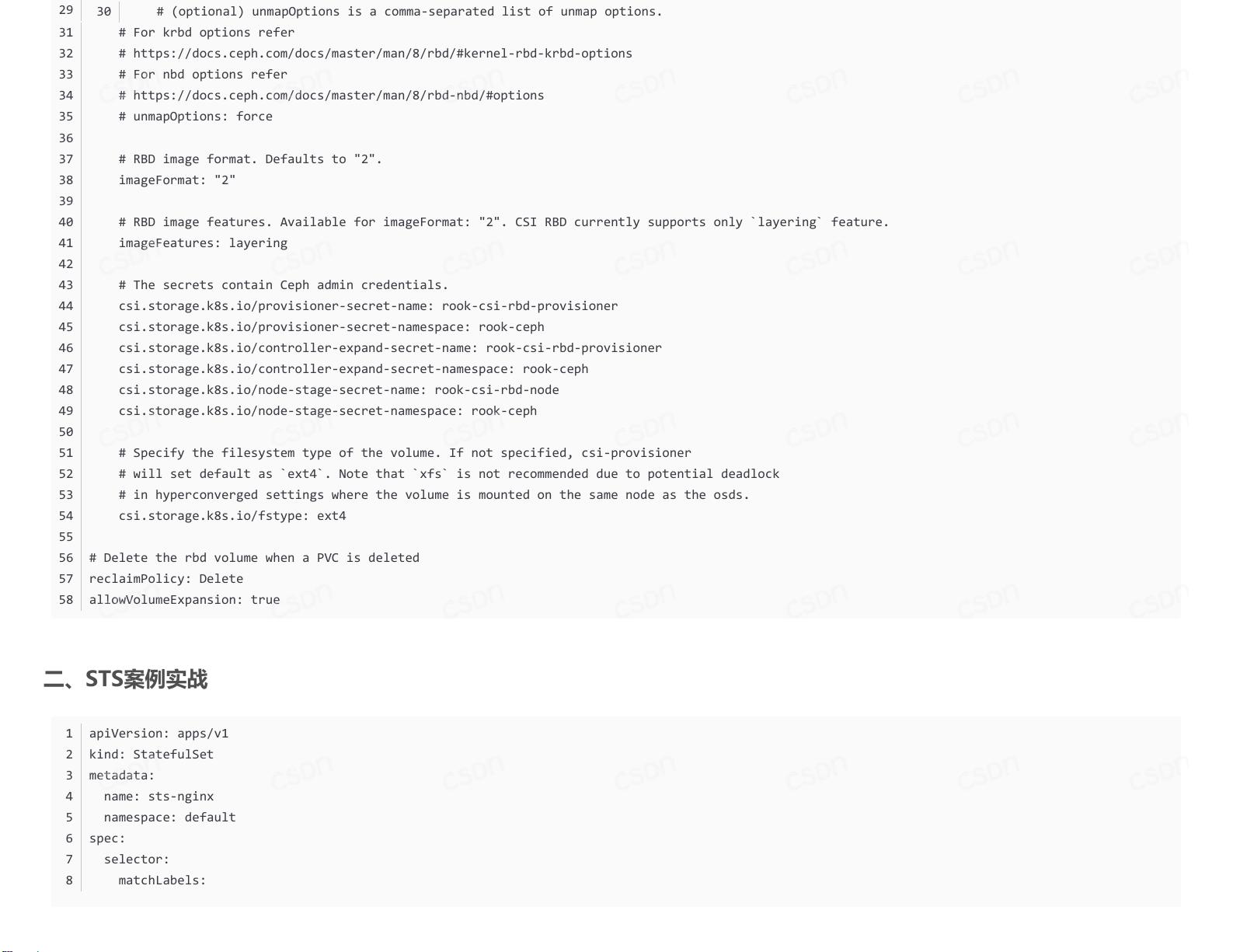

首先,我们关注的是块存储,具体来说是基于RBD( RADOS Block Devices)的解决方案。RBD是一种高效、可扩展的分布式存储,适合读写频繁且对数据持久性要求高的场景。在配置RBD时,关键步骤包括创建一个CephBlockPool,例如"replicapool",设置数据副本数量为2以提供冗余。此外,还需要定义一个StorageClass,如"rook-ceph-block",指定存储驱动(rook-ceph.rbd.csi.ceph.com)和集群ID等相关参数。需要注意的是,通常推荐使用RWO(ReadOnlyMany)模式,避免过多并发写操作可能带来的问题,同时在处理删除操作时,因为RDB的删除不会自动触发PVC(Persistent Volume Claim)的删除,因此需要用户手动管理。

接着,文件存储方面,文章介绍了CephFS(Ceph File System)的使用。CephFS是一种面向文件系统的对象存储,适合共享存储或需要支持大量小文件的应用。配置CephFS涉及创建文件系统、挂载到Kubernetes工作负载,并进行必要的测试以确保其功能正常。在pvc扩容方面,文章提到可以实现动态卷扩容,即随着应用需求的增长,能够动态增加存储资源,这有助于保持应用的灵活性。

在整个过程中,作者强调了遵循官方文档(CephDocs),确保操作的正确性和兼容性。此外,由于云原生环境的复杂性,选择合适的存储策略和管理工具对于提升系统的稳定性和效率非常重要。

这篇云原生(三十四)| Kubernetes篇之平台存储系统实战提供了关于如何在Kubernetes上有效地集成和管理RBD和CephFS存储系统的关键步骤,包括配置、测试和扩容策略,这对于在云环境中构建高可用、可扩展的应用具有实际指导意义。

303 浏览量

2021-09-18 上传

2024-01-10 上传

2024-03-04 上传

2023-07-24 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

Lansonli

- 粉丝: 20w+

- 资源: 116

最新资源

- 掌握Jive for Android SDK:示例应用的使用指南

- Python中的贝叶斯建模与概率编程指南

- 自动化NBA球员统计分析与电子邮件报告工具

- 下载安卓购物经理带源代码完整项目

- 图片压缩包中的内容解密

- C++基础教程视频-数据类型与运算符详解

- 探索Java中的曼德布罗图形绘制

- VTK9.3.0 64位SDK包发布,图像处理开发利器

- 自导向运载平台的行业设计方案解读

- 自定义 Datadog 代理检查:Python 实现与应用

- 基于Python实现的商品推荐系统源码与项目说明

- PMing繁体版字体下载,设计师必备素材

- 软件工程餐厅项目存储库:Java语言实践

- 康佳LED55R6000U电视机固件升级指南

- Sublime Text状态栏插件:ShowOpenFiles功能详解

- 一站式部署thinksns社交系统,小白轻松上手