Tensorflow实战LSTM:理解与代码实现

33 浏览量

更新于2024-08-04

收藏 163KB PDF 举报

"该资源是关于使用TensorFlow实现长短期记忆网络(LSTM)的详细指南,涵盖了LSTM的基本概念以及在实际编程中可能遇到的问题和解决方案。"

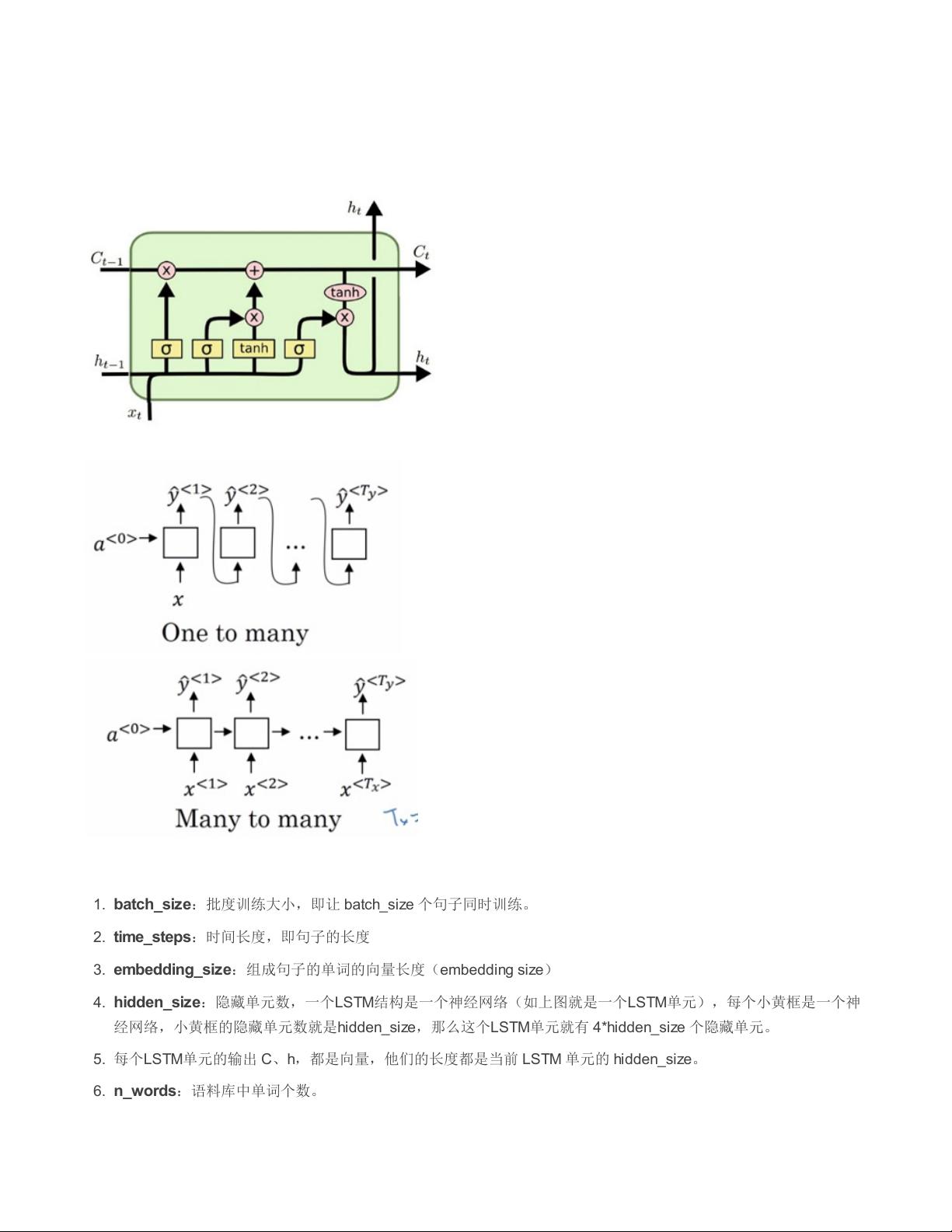

在深度学习领域,LSTM(Long Short-Term Memory)是一种特殊的循环神经网络(RNN),设计用于处理序列数据中的长期依赖问题。LSTM通过引入门控机制(输入门、遗忘门和输出门)来控制信息的流动,从而避免了传统RNN中梯度消失或爆炸的问题。

在TensorFlow中实现LSTM时,我们需要了解一些关键参数和结构:

1. **批度训练大小(batch_size)**: 这是指在每次训练迭代中,一起被处理的样本数量。批量训练有助于提高模型训练的稳定性和效率。

2. **时间步(time_steps)**: 它表示序列数据的长度。例如,如果处理的是每个句子,time_steps就是句子的单词数量。

3. **嵌入大小(embedding_size)**: 这是将词汇表中的每个单词映射到的连续向量的维度。嵌入有助于捕捉词汇的语义关系。

4. **隐藏单元数(hidden_size)**: LSTM单元的隐藏状态维度,决定了模型的记忆容量。每个LSTM单元包含多个神经网络(对应于输入门、遗忘门、输出门和细胞状态),每个都有hidden_size个节点。

5. **细胞状态(C)** 和 **隐藏状态(h)**: LSTM的输出包括细胞状态(存储长期信息)和隐藏状态(通常用于下一个时间步的输入)。它们都是大小为hidden_size的向量。

6. **词汇量(n_words)**: 这是训练数据中不同单词的数量,用于创建词汇表和编码文本。

在TensorFlow中实现LSTM时,可以使用`tf.nn.rnn_cell.LSTMCell`或者`tf.contrib.rnn.LSTMCell`类。以下是一个简单的LSTM层构建示例:

```python

import tensorflow as tf

# 创建LSTM单元

lstm_cell = tf.nn.rnn_cell.LSTMCell(hidden_size)

# 如果需要多层LSTM,可以使用tf.nn.rnn_cell.MultiRNNCell

multi_lstm_cell = tf.nn.rnn_cell.MultiRNNCell([lstm_cell] * num_layers)

# 将输入转换为嵌入

embedding_layer = tf.Variable(tf.random_uniform([n_words, embedding_size], -1, 1))

inputs_embedded = tf.nn.embedding_lookup(embedding_layer, inputs)

# 运行LSTM

outputs, _ = tf.nn.dynamic_rnn(multi_lstm_cell, inputs_embedded, dtype=tf.float32)

```

在这个例子中,`tf.nn.embedding_lookup`用于查找输入序列对应的嵌入向量,`tf.nn.dynamic_rnn`函数则用于执行LSTM的前向传播,返回所有时间步的输出和最终的细胞状态。

值得注意的是,实际应用中还需要考虑模型训练的损失函数、优化器以及训练过程中的序列数据处理(如padding或截断以统一时间步长)。此外,为了防止过拟合,可能还需要添加正则化项或使用dropout策略。

在实践中,理解LSTM的内部工作原理以及如何正确配置和使用TensorFlow API是至关重要的,这包括选择合适的超参数、理解和初始化权重以及有效利用GPU资源等。通过不断实验和调试,可以逐步完善模型,提高其在特定任务上的性能。

2021-08-04 上传

2018-08-26 上传

2023-04-01 上传

2021-06-02 上传

2024-03-03 上传

2022-12-17 上传

2022-08-10 上传

2017-11-02 上传

2018-08-13 上传

快乐无限出发

- 粉丝: 1182

- 资源: 7375

最新资源

- 开源通讯录备份系统项目,易于复刻与扩展

- 探索NX二次开发:UF_DRF_ask_id_symbol_geometry函数详解

- Vuex使用教程:详细资料包解析与实践

- 汉印A300蓝牙打印机安卓App开发教程与资源

- kkFileView 4.4.0-beta版:Windows下的解压缩文件预览器

- ChatGPT对战Bard:一场AI的深度测评与比较

- 稳定版MySQL连接Java的驱动包MySQL Connector/J 5.1.38发布

- Zabbix监控系统离线安装包下载指南

- JavaScript Promise代码解析与应用

- 基于JAVA和SQL的离散数学题库管理系统开发与应用

- 竞赛项目申报系统:SpringBoot与Vue.js结合毕业设计

- JAVA+SQL打造离散数学题库管理系统:源代码与文档全览

- C#代码实现装箱与转换的详细解析

- 利用ChatGPT深入了解行业的快速方法论

- C语言链表操作实战解析与代码示例

- 大学生选修选课系统设计与实现:源码及数据库架构